Teoria Informacji i Metody Kompresji Danych -...

Transcript of Teoria Informacji i Metody Kompresji Danych -...

3

Robert SusmagaInstytut Informatyki

ul. Piotrowo 2

Poznań

kontakt mail’owy

kontakt osobisty

Centrum Wykładowe, „blok informatyki”, pok. 7

Wyłączenie odpowiedzialności

Prezentowane materiały, będące dodatkiem pomocniczym do wykładów, z konieczności fragmentarycznym i niedopracowanym, należy wykorzystywać z pełną świadomością faktu, że mogą nie być pozbawione przypadkowych błędów, braków, wypaczeń i przeinaczeń :-)

Autor

• Informacja w...

– mediach

– języku

– internecie

– życiu

– jeszcze innych miejscach

...i wreszcie...

– nauce/naukach

Informacja

8

Informacja

• Informacja w języku

„Multimedialny słownik PWN – wyrazy obce”

informacja -cji, lm -cje, ż1. «wiadomość o czymś przekazana ustnie lub pisemnie»

biol. informacja genetyczna «dane o cechach dziedzicznych organizmu zakodowane w genach, wyrażające się kolejnością ułożenia czterech podstawowych ogniw łańcucha DNA» mat. teoria informacji «dział matematyki stosowanej dotyczący zagadnień kodowania i przetwarzania danych»

2. «dział urzędu lub miejsce w jakiejś instytucji, w którym można otrzymać wiadomości na jakiś temat»

3. inform. «dane przetwarzane przez komputer»<łac. informatio>

„informacja” jako rzeczownik policzalny / niepoliczalny

• Informacja w internecieInformacja (łac. informatio – przedstawienie, wizerunek; informare – kształtować, przedstawiać) –termin interdyscyplinarny, definiowany różnie w różnych dziedzinach nauki; najogólniej –właściwość pewnych obiektów[1], relacja między elementami zbiorów pewnych obiektów, której istotą jest zmniejszanie niepewności (nieokreśloności)[2].

Można wyróżnić dwa podstawowe punkty widzenia informacji[3]:

1. obiektywny – informacja oznacza pewną właściwość fizyczną lub strukturalną obiektów (układów, systemów), przy czym jest kwestią dyskusyjną[4], czy wszelkich obiektów, czy jedynie systemów samoregulujących się (w tym organizmów żywych);

2. subiektywny – informacja istnieje jedynie względem pewnego podmiotu, najczęściej rozumianego jako umysł, gdyż jedynie umysł jest w stanie nadać elementom rzeczywistości znaczenie (sens) i wykorzystać je do własnych celów.

Wyróżnia się trzy, powiązane ze sobą, koncepcje (teorie) informacji[1][2], związane z jej aspektami semiotycznymi[5]:

1. statystyczno-syntaktyczną z probabilistycznym i składniowym;

2. semantyczną ze znaczeniowym;

3. pragmatyczną z wartościowym (cennościowym) – w odniesieniu do problemu podejmowania przez jej odbiorcę decyzji związanych z jego celem.

• https://pl.wikipedia.org/wiki/Informacja

Informacja

• Informacja w życiu

– DNA

• kwas dezoksyrybonukleinowy: nukleotydy:

– adenina, guanina (purynowe), tymina, cytoza (pirymidynowe)

• tzw. „poprzeczki” składają się z par: Ad Ty, Cyt Gu

• alfabet: {A,T,G,C} (inaczej: {Ad, Ty, Cyt, Gu})

• jeżeli N jest liczbą „poprzeczek” w cząstce, to L = 4N, gdzie N 105, czyli L 1060000

– RNA

• kwas rybonukleinowy...

Informacja

• Informacja w jeszcze innych miejscach

– informacja w fizyce / chemii / kosmologii

• opis: parametry / właściwości stanu

– w szczególności:

» fizyka/chemia kwantowa (nieprzewidywalność)

» kosmologia (znikanie)

Informacja

• Informacja w jeszcze innych miejscach

– informacja w polityce

• pogląd: „informacja = władza”

– informacja w religii

• artykuł: J. Huebner „A Christian Theory of Information”

– informacja w sztuce

• książka: M. Porębski „Sztuka a informacja”

– ...

Informacja

• Informacja w nauce/naukach

– [Sobczak] informacja: „wiadomość, na podstawie której odbiorca opiera swoje działanie”

– [Pawlak] „system informacyjny”; informacja: element systemu informacyjnego

Informacja

• Informacja w nauce/naukach

– informacja informuje

• odpowiada na pewne (konkretne, znane) pytanie

• ale sama odpowiedź to jedynie dane

– natomiast informacja to coś więcej!

– więcej niż dane (ale mniej niż wiedza!)

» ..., mereologia, infologia, ...

• relacja: informacja a dane to trochę tak, jak kwadrat a prostokąt

• wniosek: (w ogólności) dużo danych dużo informacji

– potrzebne: to coś...

» dopiero wtedy: (może być tak, że) dużo danych = dużo informacji(istotny aspekt: objętość!)

» wymagany dodatkowy aspekt: przydatność!

Informacja

• Dr hab. Marcin Miłkowski (Zakład Logiki i Kognitywistyki Instytutu Filozofii i Socjologii PAN) „Filozofia informacji”

--------------------------------------------------------------------------------------------

– W poszukiwaniu informacji semantycznej

• Informacja semantyczna ma mieć własność prawdziwości

– ale niekoniecznie fałszywości: w ujęciu Dretskego i Luciana Floridiego informacja nie może być fałszywa

• Wiele konkurencyjnych koncepcji…

--------------------------------------------------------------------------------------------

Informacja

• Bogdan Stefanowicz (Wyższa Szkoła Inf. Stosowanej i Zarządzania w Warszawie)„Wiedza w interpretacji infologicznej”

--------------------------------------------------------------------------------------------– Wśród nich na uwagę zasługuje próba oparcia analizy tego pojęcia na podejściu

infologicznym, wywodzącym się z prac Bo Sundgren (1973) i Börje Langeforsa (1980, 1995). Istotę ich koncepcji można wyrazić jako założenie, że każde pojęcie – zgodnie z tezami podejścia cybernetycznego – może być elementem składowym pewnego pojęcia nadrzędnego i jednocześnie pojęciem nadrzędnym w stosunku do innych pojęć, które wchodzą w jego skład. Tak więc wiedza, jak i informacja, a także mądrość, mogą być rozpatrywane jako pojęcia nadrzędne w stosunku do innych pojęć. I tak, informacja może być traktowana jako pojęcie nadrzędne w stosunku dano danej, wiedza – jako pojęcie obejmujące podrzędne pojęcie informacji, zaś mądrość obejmująca pojęcie wiedzy.

--------------------------------------------------------------------------------------------

Informacja

• Informacja w naukach

– przykład

• 5, 5$, ...

(ile? czego? dużo/mało? inwestować!)

– czyli:dane informacja wiedza mądrość (?)

• pytanie wobec tego, czy (odpowiednio) wymagają:mądrość – wiedzy, wiedza – informacji, a informacja – danych?

Informacja

[…] Alibaba westchnął ciężko, usiadł leniwie na ławcei odłożył książkę. Nosiła ona tytuł: „T e o r i a i n f o r m a c j i”. Trąciliśmy się łokciami. To brzmiało dość tajemniczo [...]

Edmund Niziurski, „Sposób na Alcybiadesa”, 1964

21

Informacja

• „Multimedialny słownik PWN – wyrazy obce”

teoria w zn. 1: -rii, lm -rie, -rii, ż; w zn. 2, 3: -rii, ż, blm1. «całościowa koncepcja stworzona przez naukowca lub filozofa,

zawierająca opis i wyjaśnienie określonych zjawisk i zgadnień; także czyjakolwiek koncepcja na określony temat» filoz. teoria poznania «inaczej epistemologia (w zn. 1)» mat. teoria prawdopodobieństwa «inaczej probabilistyka»

2. «dział nauki o literaturze, kulturze, sztuce itp. zajmujący się systematyzowaniem pojęć i twierdzeń leżących u podstaw tych dziedzin»

3. «teza jeszcze nieudowodniona lub nieznajdująca potwierdzenia w praktyce»

<fr. théorie, z p.-łac. theoria (u św. Hieronima), z gr. theōría obserwacja, oglądanie, pogląd oparty na faktach obserwowanych’; zmiana zn. za sprawą teologów, stawiających objawienie ponad poglądy oparte nadanych zmysłowych>

• Informacją w oderwaniu od jej nadawców, nośników, adresatów, itp., zajmują się tzw. teorie informacji, np.:

– np. jakościowa teoria informacji Mazura

(zasadniczo związana z cybernetyką)

• precyzuje np. pojęcie dezinformacji

– np. ilościowa teoria informacji Kołmogomorowa

(zasadniczo związana z teorią obliczeń)

• pozwala na naturalne interpretacje w kompresji

– np. ilościowa teoria informacji Shannona

(zasadniczo związana ze statystyką)

• pozwala na naturalne interpretacje w analizie danych

• dalej na tym wykładzie: głównie o niej!

Informacja

You can’t manage what you can’t measure!

You can’t manage what you don’t measure!

You won’t manage what you don’t measure!

...

(an old management adage)

• Funkcjonalność informacji

– aby informację sprawnie wykorzystywać, trzeba ją sprawnie mierzyć!

• albo mniej sprawnie, ale w każdym razie: jakoś

• ...a przestać zadawać pytania typu: co to jest?, gdzie to jest?, ...

– stąd: podstawowe zadanie (ilościowych) teorii informacji: mierzenie informacji

Informacja

• Rozumienie nauk

– klasyczne (bardziej filozoficzne)

• „Dlaczego?”

– współczesne (bardziej pragmatyczne)

• „Jak?”

– przykład: psychologia

• psychologia klasyczna interesowała się głównie fazą namysłu poprzedzającą powzięcie postanowienia („aktem woli”)

• psychologia współczesna bada związki podejmowania decyzji z poznawaniem i motywacją

Dygresja

• Funkcjonalność informacji

– po zastosowaniu rozumienia współczesnego

• stosowana w wyjaśnianiu (rozmaitych) innych rzeczy

• np.:

– związków między różnymi parametrami opisującymi zjawiska (tzw. zmiennymi)

» predykcja, klasyfikacja

– wbrew (niektórym) pozorom (dość złożony aparat matematyczny, itd..)

• zaskakiwać może poziom uproszczeń!

• a to dlatego, że w badaniach złożoności pomagają głównie... uproszczenia

– np. jakieś A = 0, jakieś A = jakieś B, itd.

Informacja

• Claude Elwood Shannon (ur. 30 kwietnia 1916, zm. 24 lutego 2001)– laureat (1972) nagrody Shannona!

amerykański matematyk i inżynier, profesor Massachusetts Institute of Technology (MIT). Jeden z twórców teorii informacji. Jako jeden z pierwszych pojął ważność kodu binarnego i już jako młody człowiek twierdził, że ciągami zer i jedynek da się opisać tekst, obraz i dźwięk.

– ... najsłynniejsze dzieło to „Matematyczna teoria komunikacji” opublikowana w 1948 roku, która położyła podwaliny pod teorię informacji i kodowania

– ... zafascynowany był maszynami liczącymi i urządzeniami, określanymi obecnie mianem gadżetów – zaprojektował np. pianino odtwarzające w kolejności losowej zaprogramowane uprzednio utwory muzyczne, czy samouczącą się „mysz” (znajdowała drogę przez labirynt, na którego końcu Shannon kładł kawałek sera)

– pracował także nad sztuczną inteligencją, rozwijając koncepcje maszyn Turinga(m.in. stworzenie w 1956 r. komputera szachowego MANIAC 1)

• https://pl.wikipedia.org/wiki/Claude_E._Shannon

Miara informacji

• Informacja w podejściu Shanonna

– przedmiot badań: (przekazywana) wiadomość – w praktyce: jakieś dane

• pozbawiona treści/znaczenia/semantyki

– badania semantyki były niemodne w czasach Shanonna

• główny nacisk: zgodność „wejścia” z „wyjściem”

– podstawowy kontekst: zniekształcenia transmisji w (szeroko rozumianych) kanałach informacyjnych

Miara informacji

• Izabela Bondecka-Krzykowska (Wydział Matematyki i Informatyki UAM) „Informacja w informatyce cz. 1 teoria komunikacji C. Shannona”

--------------------------------------------------------------------------------------------

– Cechy matematycznej teorii komunikacji Shannona:

• W teorii tej informacja jest tylko wybraniem jednego symbolu ze zbioru możliwych symboli.

• Nie jest to teoria informacji w zwykłym sensie. Informacja ma w niej wyłącznie znaczenie techniczne. Teoria ta całkowicie ignoruje np. kontekst komunikatów.

• Największą ilość informacji generuje tekst, w którym prawdopodobieństwo wystąpienia każdej litery jest takie samo, tzn. kompletnie losowy ciąg (paradoks małp).

• Matematyczna teoria komunikacji jest teoria informacji z pominięciem jej znaczenia. Zajmuje się ona bowiem badaniem informacji na poziomie syntaktycznym.

– Matematyczna teoria komunikacji traktuje informacje jak zjawisko fizyczne, przedmiotem jej zainteresowania jest sposób kodowania i przesyłania informacji a nie jej zawartość semantyczna.

--------------------------------------------------------------------------------------------

Miara informacji

• Wobec faktu, że informacja

– informuje, tzn. odpowiada na konkretne, znane pytanie

zadaniem potencjalnej „miary informacji”

– nie jest charakteryzowanie wyłącznie „objętości” składających się na nią danych, lecz także ich „przydatności”*, rozumianej jako trudność pytania, na które te dane niosą odpowiedź; a konkretnie :

• nisko oceniamy informacje trywialne / spodziewane / bardzo oczywiste / bardzo prawdopodobne, łatwo zgadywalne, przewidywalne

• wysoko oceniamy informacje nietrywialne / niespodziewane / mało oczywiste / mało prawdopodobne, trudno zgadywalne, nieprzewidywalne

* ze słowem „objętość” lepiej od „przydatność” komponuje się słowo „złożoność”, ale (niestety) złożoność implikuje strukturę (mniej czy bardziej rozbudowaną), o której tu akurat nie ma mowy (dlatego zostajemy przy „przydatność”)

Miara informacji

• Odpowiednio, „miara informacji”

– jest funkcją (tzn. zależy wyłącznie od) ich

• „objętości” /rozmiary?/

oraz

• „przydatności” /prawdopodobieństwo?/

– nie jest funkcją* (tzn. nie zależy od) żadnych dalszych cech danych, np. ich (szeroko rozumianej)

• adekwatności

• doniosłości

• użyteczności

• aktualności

• ...

te bowiem bardzo trudno „ogarnąć” i, w rezultacie, sformalizować(w każdym razie na tyle, aby mogły być wyrażane matematycznie)

– przeciwdziedzina: liczby (rzeczywiste) nieujemne

* (co nie znaczy, że /w przyszłości/ nie można uczynić jej taką funkcją /po odpowiednim sformalizowaniu odpowiednich, nowych aspektów/)

Miara informacji

• Niestety, to nie koniec problemów z „ogarnianiem”, ładniej mówiąc: formalizowaniem, informacji, ponieważ (na domiar złego) jest ona także czymś względnym

– „punkt siedzenia określa punkt widzenia”

Miara informacji

• Bogdan Stefanowicz (GUS)„Informacja. Wiedza. Mądrość.”

--------------------------------------------------------------------------------------------

– Dobitną ilustracją wpływu założeń domyślnych jest sytuacja opisana przez Klemensa Stróżyńskiego (2006, s. 14). Otóż wyobraźmy sobie kogoś (osobę X), która spotyka inną osobę (osobę Y) i stwierdza, że Y idzie tylko w jednym bucie. Co pomyśli X? [...]

1) Y pewnie zgubił but

albo

2) Y pewnie znalazł but.

--------------------------------------------------------------------------------------------

Miara informacji

• Dr hab. Marcin Miłkowski (Zakład Logiki i Kognitywistyki Instytutu Filozofii i Socjologii PAN) „Filozofia informacji”

--------------------------------------------------------------------------------------------

– Uwaga: jak stosować miarę Shannona

• Weźmy dowód matematyczny. On ma prawdopodobieństwo 1.

• Wydawałoby się zatem, że żaden dowód nie niesie żadnej informacji w sensie Shannona.

• Ale tylko wtedy, kiedy odbiorca (którym może być maszyna!) zna tekst tego dowodu i wie, że dany tekst jest dowodem.

• Ilość informacji zależy od stopnia zaskoczenia odbiorcy. Nie jest absolutna!!!

--------------------------------------------------------------------------------------------

Miara informacji

• Rada na wszystkie trudne do ogarnięcia aspekty informacji: zignorować! (tym samym zasadniczo upraszczając sprawę)

– (zostawić tylko „objętość” i „przydatność”)

Miara informacji

• Nauka przez zabawę, a konkretnie:tzw. „zabawa w 10 pytań” (u nas: N = 8 pytań)

– cel: odgadnięcie wylosowanej liczby naturalnej ze zbioru {1, 2, ..., 8}

– reguły:

• wolno zadawać pytania o odpowiedziach typu „tak/nie”

• zabawa się kończy po odgadnięciu wybranej liczby

– założenie ogólne: racjonalność pytań

• nietrywialne

• bez powtórzeń / bez implikowanych powtórzeń

• ...

Miara informacji

• Możliwe są różne pytania (i odpowiedzi), np.:

– (a) czy jest to 2?

• odpowiedź: albo tak, albo nie

– (b) czy jest to liczba większa od 2?

• odpowiedź: albo tak, albo nie

– (c) czy jest to liczba podzielna przez 2?

• odpowiedź: albo tak, albo nie

– ...

Miara informacji

• Wobec faktu, że odpowiedzi typu „tak/nie” dzielą zbiór na dwie części, powyższe (oraz wszystkie inne) pytania formułujemy następująco:

– (a) czy liczba należy do zbioru {2} czy do zbioru {1, 3, 4, ..., 8}?

(krótko: {2} czy {1, 3, 4, ..., 8}?)

• odpowiedź: albo {2}, albo {1, 3, 4, ..., 8}

– (b) czy liczba należy do zbioru {3, 4, ..., 8} czy do zbioru {1, 2}?

(krótko: {3, 4, ..., 8} czy {1, 2}?)

• odpowiedź: albo {3, 4, ..., 8}, albo {1, 2}

– (c) czy liczba należy do zbioru {2, 4, 6, 8} czy do zbioru {1, 3, 5, 7}?

(krótko: {2, 4, 6, 8} czy {1, 3, 5, 7}?)

• odpowiedź: albo {2, 4, 6, 8}, albo {1, 3, 5, 7}

– ...

Miara informacji

• Możliwe są także różne strategie zadawania pytań (rozumiane jako serie konkretnych pytań), np.:

– strategia A, typu

• {1} czy {2, 3, ..., 8}?

• jeżeli {2, 3, ..., 8}, to {2} czy {3, 4, ..., 8}?

• ...

– strategia B, typu

• {1, 2, 3, 4} czy {5, 6, 7, 8}?

• jeżeli {1, 2, 3, 4}, to {1, 2} czy {3, 4}?

• ...

Miara informacji

• Strategie powinny być skuteczne / kompletne

– tzn.: muszą zawsze doprowadzać do osiągnięcia celu

• (patrz też: założenia ogólne)

Miara informacji

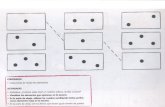

• Strategia typu A (tutaj: dla kolejności 1, 2, ..., 8)• {1}

• {2, 3, ..., 8}

• {2}

• {3, 4, ..., 8}

• {3}

• {4, 5, ..., 8}

• {4}

• {5, 6, 7, 8}

• {5}

• {6, 7, 8}

• {6} • {7, 8}

• {7}

• {8}

Miara informacji

• Strategia typu B (tutaj: dla kolejności 1, 2, ..., 8)• {1, 2, 3, 4}

• {1, 2}

• {1}

• {2}

• {3, 4}

• {3}

• {4}

• {5, 6, 7, 8}

• {5, 6}

• {5}

• {6}

• {7, 8}

• {7}

• {8}

Miara informacji

• Rozegrano dwie „partyjki” zabawy

– jedną z użyciem strategii A

– jedną z użyciem strategii B

zakończone osiągnięciem celu

– tzn.: poznaniem wylosowanej liczby

Miara informacji

• Czyli:

– ponieważ

• różnymi zestawami pytań (strategiami ich zadawania)

– osiągnięto

• ten sam cel

– to można przyjąć pewne kluczowe założenie dotyczące tych strategii

• pomimo wyraźnych różnic, strategie mają wspólną cechę:

„przekazują” taką samą ilość informacji!!!

(czymkolwiek by ta informacja nie była...)

Miara informacji

• Stąd: pomysł na mierzenie ilości informacji:

– uznać, że cała (rozpatrywana) ilość informacji to np. C jednostek

– znaleźć jakiś parametr strategii Q

– podzielić C przez Q

– twierdzić, że „nośnik” (opisany parametrem Q) zawiera (średnio) C / Q jednostek informacji

– przykładowe pomiary (po uproszczeniu, że C = 1)

• jeżeli na jakąś strategię składa np. 5 pytań, to jej jedno pytanie zawiera średnio 1/5 jednostki informacji

• jeżeli na inną strategię składa np. 10 pytań, to jej jedno pytanie zawiera średnio 1/10 jednostki informacji

• ...

Miara informacji

• Stąd: pomysł na mierzenie ilości informacji:

– niech Q będzie liczbą pytań składających się na strategię

– strategia A: 7, strategia B: 7

• brak różnicy!

– ale to nie to stanowi główny problem...

– krytyka

• tak zdefiniowana miara nie ma jednak żadnego związku z „praktyką” procesu zadawania pytań (i uzyskiwania odpowiedzi), chociażby z tym, ile (co najmniej / co najwyżej) pytań należy zadać, aby zagwarantować osiągnięcie celu (tzn. poznanie wybranej liczby)

– tymczasem dopiero osiągnięcie tego celu pozwala na wykorzystanie założenia kluczowego!

Miara informacji

• Stąd: pomysł na mierzenie ilości informacji:

– niech Q będzie liczbą odpowiedzi gwarantujących osiągnięcie celu

Miara informacji

• Strategia A• {1}

• {2, 3, ..., 8}

• {2}

• {3, 4, ..., 8}

• {3}

• {4, 5, ..., 8}

• {4}

• {5, 6, 7, 8}

• {5}

• {6, 7, 8}

• {6} • {7, 8}

• {7}

• {8}

1: 1 odp., 2: 2 odp., 3: 3 odp., 4: 4 odp., 5: 5 odp., 6: 6 odp., 7: 7 odp., 8: 7 odp.

Miara informacji

• Strategia B• {1, 2, 3, 4}

• {1, 2}

• {1}

• {2}

• {3, 4}

• {3}

• {4}

• {5, 6, 7, 8}

• {5, 6}

• {5}

• {6}

• {7, 8}

• {7}

• {8}

1: 3 odp., 2: 3 odp., 3: 3 odp., 4: 3 odp., 5: 3 odp., 6: 3 odp., 7: 3 odp., 8: 3 odp.

Miara informacji

• Charakterystyki ilościowe

– pytanie: jaka jest średnia wymaganej liczby odpowiedzi w sytuacji, gdyby zabawa miała być powtórzona wielokrotnie (z liczbami wybieranymi za każdym razem w sposób losowy)

– odpowiedź:

strategia A

1: 1 odp., 2: 2 odp., 3: 3 odp., 4: 4 odp., 5: 5 odp., 6: 6 odp., 7: 7 odp., 8: 7 odp.

• średnia: (1+2+...+7+7)/8 = 35/8 = 4.375

strategia B

1: 3 odp., 2: 3 odp., 3: 3 odp., 4: 3 odp., 5: 3 odp., 6: 3 odp., 7: 3 odp., 8: 3 odp.

• średnia: (3+3+...+3)/8 = 24/8 = 3.000

– uwaga: (zauważalna) przewaga strategii B ewidentnie rośnie ze wzrostem N:

• np. dla N = 64 otrzymamy średnio

– strategia A: 32.484 pytania

– strategia B: 6.000 pytań

• np. dla N = 1024 otrzymamy średnio

– strategia A: 512.499 pytań

– strategia B: 10.000 pytań

• ...

Miara informacji

• Charakterystyki ilościowe

– ponieważ:zestaw (średnio) 4.3 odpowiedzi na pytania ze strategii A

niesie tyle samo informacjico zestaw (średnio) 3.0 odpowiedzi na pytania ze strategii B więc:

• jedna odpowiedź ze strategii B

niesie (średnio) więcej informacji niż

• jedna odpowiedź ze strategii A

Miara informacji

• Uwaga: ponieważ odpowiedzi w praktyce nie zmieniają się w trakcie zabawy (zawsze: albo „tak”, albo „nie”), przykazywana informacjamusi tkwić w (odpowiednio formułowanych i) zadawanych pytaniach (a nie tylko w udzielanych odpowiedziach!)

– jak pamiętamy: informacja to coś więcej niż dane

• (która stanowią odpowiedź)

Miara informacji

• Miara informacji

– szeroki kontekst

• źródło, nadawca, emisja, odbiorca, ...

• idea kanału informacyjnego (jednowymiarowego)

• transmisja (monolog) a wymiana? (dialog)

Miara informacji

• Miara informacji

– wąski kontekst

• dany jest n-elementowy ciąg znaków z alfabetu m-elementowego (przekaz), przy czym znaki (a także ich ciągi) są równie prawdopodobne

– (całkowite) n 0

– (całkowite) m 1

• istnieje mn różnych ciągów tego typu (przekazów)

– np.:

» n = 1, m = 2: 21 = 2 (2 ciągi jedno elementowe)

» n = 5, m = 2: 25 = 32 (32 ciągi 5-cio elementowe)

» n = 10, m = 2: 210 = 1024 (1024 ciągi 10-cio elementowe)

» itd.

» n = 0, m – dowolne: m0 = 1 (1 ciąg pusty /bez względu na wartość m/)

Miara informacji

• Miara informacji

– pewne (dalej pomijane, ale) kluczowe założenia:

• interpretowalna jest (tylko i wyłącznie)

– (1) różnorodność ciągu odebranych znaków,

• interpretowalna nie jest (natomiast)

– (2) żaden parametr procesu ich nadawania

– (3) liczba znaków

Miara informacji

• Miara informacji

– założenie (1)

• interpretacja odebranych znaków (transmisja „cyfrowa”)

– sytuacja wyidealizowana: alfabet Z

– sytuacja nieco bardziej praktyczna: alfabet Z {?}

Miara informacji

• Miara informacji

– założenie (2)– dotyczy takich parametrów jak: moc, jakość, czas, prędkość, częstotliwość, ...

• interpretacja (np.) prędkości nadawania (transmisja „analogowa” + konwersja analogowo-cyfrowa)

– sytuacja wyidealizowana: bezbłędny pomiar prędkości

– sytuacja nieco bardziej praktyczna: pomiar prędkości obarczony błędami

Miara informacji

• Miara informacji

– założenie (3)

• interpretacja liczby odebranych znaków

– synchroniczny proces emisji/odbioru znaków

» proces synchroniczny a asynchroniczny

» znak „pusty” (spacja, przerwa, ...) a brak sygnału

» idea „nasłuchu”

– alfabet jednoelementowy (m = 1) w kanale synchronicznym

» jeżeli przy kolejnych nasłuchach źródło emituje więc jedynie ciągi złożone z tego jednego, jedynego znaku; odebranie kolejnego znaku jest więc w pełni przewidywalne, i w rezultacie żaden ciąg (bez względu na swoją długość) złożony z tej litery nie niesie żadnej informacji

» inaczej: faktu odebrania n znaków alfabetu jednoelementowego nie można w żaden sposób interpretować w przypadku synchronicznym*, ponieważ oznacza on jedynie, że nasłuchu dokonano n razy (a nie, że nadano n znaków)

* w ogólności możliwe (i naturalne) jest interpretowanie odebranegociągu n znaków alfabetu jednoelementowego jako liczby n (zapisanej w jedynkowym systemie liczenia)

Miara informacji

• Miara informacji

– przykłady

• zrozumiałość wypowiedzi

– aspekt cyfrowy

• treść wypowiedzi a (np.) tonacja wypowiedzi

– aspekt cyfrowy a analogowy

• treść wypowiedzi a (np.) „mowa ciała”

– kanały wielowymiarowe

– dalsze (bardziej życiowe) przykłady

• podpowiadanie w grze Milionerzy

• ...

Miara informacji

• Miara informacji

– ogólnie: niech dla przyjętych m i n miara informacji wyraża się funkcją L(m,n)

• argumenty: m i n (parametry danych, które mają „przełożyć się” na informację)

– m: wskaźnik „przydatności”; interpretacja: duże m = duża przydatność*

» m 1

– n: wskaźnik „objętości”; interpretacja: duże n = duża objętość

» n 0

uwaga: wzrost m jest inaczej interpretowany niż wzrost n

(„reakcja” miary powinna być inna)

* „intuicja” pomocna przy rozumieniu „przydatności”:

dane charakteryzują się dużą przydatnością, gdy trudno je zdobyć (czyli: przewidzieć, chociażby metodą odgadywania)

Miara informacji

• Miara informacji

– rozpatrywać można różne postaci takiej funkcji

• L(m,n) = m+n

• L(m,n) = m·n

• L(m,n) = sin(m)·cos(n)

• ...

Miara informacji

• Miara informacji

– wymagane właściwości (niekoniecznie niezależne od siebie)

• L(m,n) 0

• L(m,n) słabo monotoniczna* względem m i n, przy czym dla skrajnych wartości m i n (czyli dla m = 1 i n = 0), miara jest zerowa; konkretnie

– L(1,n) = 0

» przy trywialnym przekazie (m = 1), miara jest zerowa

uzasadnienie: m = 1 oznacza, że istnieje tylko jeden znak alfabetu, źródło emituje więc jedynie ciągi złożone z tego jednego, jedynego znaku;odebranie kolejnego znaku jest więc w pełni przewidywalne, i w rezultacie żaden ciąg (bez względu na swoją długość) złożony z tej litery nie niesie żadnej informacji

– L(m,0) = 0

» przy braku przekazu (n = 0), miara jest zerowa

• L(m,k·n) = k·L(m,n)

– przy k-krotności objętości przekazu, miara rośnie k-krotnie

• L(k·m,n) = L(k,n) + L(m,n)

– przy k-krotności przydatności przekazu, miara rośnie o L(k,n)

* (słaba) monotoniczność funkcji f(x) względem x:

im większe x, tym większe (lub takie samo) f(x)

Miara informacji

• Miara informacji

– przykładowe uzasadnienie ostatniej właściwości

– jeżeli każdy z przekazywanych m znaków, np.:

• litera (alfabetu angielskiego): m = 26

• cyfra (dziesiętna): m = 10

• itp.

charakteryzuje się dokładnie jedną dodatkową cechą, która jest w pełni niezależna od (treści) samych znaków, np.:

• litera jest wyrażona albo dużą literą alfabetu albo małą literą alfabetu

• cyfra jest albo poprzedzona ustalonym znakiem (plus albo minus) albo nie

• itp.

to wypadkowa liczność alfabetu wzrasta (stanowi iloczyn oryginalnej liczności m oraz liczby dodatkowych (niezależnych) cech k)

Miara informacji

• Miara informacji

– przykładowe uzasadnienie ostatniej właściwości

– w powyższych przypadkach

• (po prostu) litery: m = 26

• litery (m = 26) duże albo małe (k = 2): k·m = 2·26 = 52 „znaki”

• (po prostu) cyfry: m = 2

• cyfry (m = 10) z ewentualnym znakiem (k = 3): k·m = 3·10 = 30 „znaków”

Miara informacji

• Miara informacji

– przykładowe uzasadnienie ostatniej właściwości

– oznacza to, że (wobec wspomnianej niezależności treści znaku i jej dodatkowej cechy) w jednym przekazie można zamieszczać dwie osobne „wiadomości”

Miara informacji

• Miara informacji

– przykładowe uzasadnienie ostatniej właściwości

– przykład: z danych, na które składają się znaki w postaci

• cyfr (binarnych): m = 2

charakteryzujące się dodatkową cechą pogrubienia

• cyfra jest albo zapisana krojem pogrubionym albo nie: k = 2

możliwe jest odczytywanie dwóch liczb (w obu przypadkach: binarnych) naraz, np.:

• 0

– „treści” („1” = 1, „0” = 0): 0

– „cechy” („pogrubienie” = 1, „brak pogrubienia” = 0): 1

• 1010

– „treści” („1” = 1, „0” = 0): 1010

– „cechy” („pogrubienie” = 1, „brak pogrubienia” = 0): 1100

Miara informacji

• Miara informacji

– przykładowe uzasadnienie ostatniej właściwości

– wniosek: wypadkowy alfabet skrywa w sobie dwa niezależne alfabety:

• alfabet treści (w tym przypadku, wobec m = 2, binarny)

• alfabet cech (w tym przypadku, wobec k = 2, binarny)

– wartość miary wyrażona dla wypadkowej liczności alfabetu (L(2·2,n)) powinna być więc równa sumie wartości wyrażonych dla obu alfabetów (L(2,n) oraz L(2,n)) osobno, czyli:

L(2·2,n) = L(2,n) + L(2,n)

(a w ogólności)

L(k·m,n) = L(k,n) + L(m,n)

Miara informacji

• Miara informacji

– niech L(m,n) = m+n

– właściwość nieujemności zapewniona

• m+n 0 (dla m 1 i n 0)

– właściwość słabej monotoniczności zapewniona

• m+n jest monotoniczne względem m i n

– problem:

• dla n = 0 zachodzi: L(m,0) = m+0 = m

– przy braku przekazu, miara jest niezerowa

• wynik spodziewany: L(m,0) = 0

– przy braku przekazu, miara jest zerowa

Miara informacji

• Miara informacji

– niech L(m,n) = m·n

– właściwość nieujemności zapewniona

• m·n 0 (dla m 1 i n 0)

– właściwość słabej monotoniczności zapewniona

• m·n jest monotoniczne względem m i n

– właściwość „przy braku przekazu, miara zerowa” zapewniona

• L(m,0) = m·0 = 0

– problem:

• dla m = 1 zachodzi: L(1,n) = 1·n = n

– przy trywialnym przekazie, miara jest potencjalnie niezerowa (dla n > 0)

• wynik spodziewany: L(1,n) = 0

– przy trywialnym przekazie, miara jest zerowa

Miara informacji

• Miara informacji

– niech L(m,n) = mn

– właściwość nieujemności zapewniona

• mn 0 (dla m 1 i n 0)

– właściwość słabej monotoniczności zapewniona

• mn jest monotoniczne względem m i n

– problem:

• dla n = 0 zachodzi: L(m,0) = m0 = 1

– przy braku przekazu, miara jest niezerowa

• wynik spodziewany: L(m,0) = 0

– przy braku przekazu, miara jest zerowa

Miara informacji

• Miara informacji

– niech L(m,n) = mn – 1

– właściwość nieujemności zapewniona

• mn – 1 0 (dla m 1 i n 0)

– właściwość słabej monotoniczności zapewniona

• mn – 1 jest monotoniczne względem m i n

– właściwość „przy braku przekazu, miara zerowa” zapewniona

• L(m,0) = m0 – 1 = 1 – 1 = 0

– właściwość „przy trywialnym przekazie, miara zerowa” zapewniona

• L(1,n) = 1n – 1 = 1 – 1 = 0

– problem:

• dla n = k·p zachodzi: L(m,k·p) = mk·p – 1 = (mp)k – 1 = (mp –1+1)k – 1 = (L(m,p)+1)k – 1

– miara rośnie co najmniej L(m,p)k–1 krotnie

(powód: rozwinięcie wyrażenia (L(m,p)+1)k zawiera składnik L(m,p)k = L(m,p)k–1·L(m,p))

» np. przy dwukrotności (k = 2) przekazu, miara rośnie co najmniej L(m,p)-krotnie

• wynik spodziewany: L(m,k·p) = k·L(m,n)

– przy k-krotności przekazu, miara rośnie k-krotnie

Miara informacji

• Miara informacji

– niech L(m,n) = logP(mn) = n·logP(m)

– właściwość nieujemności zapewniona

• n·logP(m) 0 (dla m 1 i n 0)

– właściwość słabej monotoniczności zapewniona

• n·logP(m) jest monotoniczne względem m i n

– właściwość „przy braku przekazu, miara zerowa” zapewniona

• L(m,0) = logP(m0) = 0·logP(m) = 0

– właściwość „przy trywialnym przekazie, miara zerowa” zapewniona

• L(1,n) = logP(1n) = n·logP(1) = n·0 = 0

– właściwość „przy k-krotności obj. [...] rośnie k-krotnie” zapewniona

• L(m,k·n) = k·n·logP(m) = k(n·logP(m)) = k·L(m,n)

– właściwość „przy k-krotności przyd. [...] rośnie o L(k,n)” zapewniona

• L(k·m,n) = n·logP(k·m) = n·(logP(k)+logP(m)) = n·logP(k)+n·logP(m) = = L(k,n) + L(m,n)

Miara informacji

• Miara informacji

In = L(m,n) = n·logP(m) [Hartley]

– miara informacji ciągu n-elementowego (równe prawdopodobieństwa)

– za „jednostkę” tej miary uznaje się podstawę P logarytmu

• dla P = 2: „bit”

• dla P = e: „nit” („nat”, „N/neper”)

• dla P = 3: „trit”

• dla P = 10: „dit” („ban”, „H/hartley”)

– zastosowania

• (w ramach teorii informacji) zwyczajowo przyjmuje się

– P = e w częściach teoretycznych (dowody)

– P = 2 w częściach praktycznych (zadania)

• (w ramach informatyki) zwyczajowo stosuje się

– P = 2 w pomiarach objętości danych

Miara informacji

• Miara informacji

– miara informacji a miara danych

• nibble/nybble

• byte

– pewna istotna różnica • biti (liczba 0/1 w pliku) a bitS (jednostka miary informacji)

– biti mierzy dane (jednostkowa „objętość”)– bitS mierzy informacje (jednostkowa „przydatność”)

• w szczególnym przypadku: biti = bitS– (prawdopodobieństwa zer i jedynek równe)

Miara informacji

Miara informacji

• Miara informacji

– wielokrotności wielokrotności bitów (znany mętlik)

– dla bajtów– https://pl.wikipedia.org/wiki/Jednostka_informacji

• układ SI (wielokrotności liczby 10)

– kilobajt (kB) – 103 = 1000 bajtów;

– megabajt (MB) – 106 = 10002 = 1 milion bajtów;

– gigabajt (GB) – 109 = 10003 = 1 miliard bajtów;

– terabajt (TB) – 1012 = 10004 = 1 bilion bajtów.

• układ IEC (wielokrotności liczby 2)

– kibibajt (KiB) – 210 = 1024 bajty;

– mebibajt (MiB) – 220 = 10242 = 1 milion 48 tysięcy 576 bajtów;

– gibibajt (GiB) – 230 = 10243 = 1 miliard 73 miliony 741 tysięcy 824 bajty;

– tebibajt (TiB) – 240 = 10244 = 1 bilion 99 miliardów 511 milionów 627 tysięcy 776 bajtów.