ToZależy no.6

-

Upload

redakcja-to-zalezy -

Category

Documents

-

view

229 -

download

14

description

Transcript of ToZależy no.6

str. 34Kamil Prządka Koniec wojen patentowych?

str. 24Ewa KoślaczReklamacja bez paragonu

str. 44Przemysław PryszczMacroprudential Policy – a reborn of the new policy tools five years after the financial crisis

str. 14Mateusz Niewiński Underemployment. Normalne zjawisko czy nowa dysfunkcja rynku pracy?

To Zalezy

.

Niezale¿ny Magazyn Studencki

Nr

3/20

13 (

6)

ISSN 2084-7874

STR. 4

HIGH FREQUENCY TRADINGczyli spodziewany gość na polskiej giełdzie

HIGH FREQUENCY TRADING POD LUPĄ

W ubiegłym semestrze, na zajęciach z prawa finansowego na Uniwersytecie Warszawskim, Pani doktor pokazała slajd z najważniejszymi informacjami dotyczącymi naszej Giełdy Papierów Wartościowych w Warszawie.

Było tam wszystko. Historia powstania, prezesi, liczba spółek, informacje o rodzajach instrumentów i najważniejsze indeksy. Ten slajd wbił mi się jednak szczególnie w pamięć, bowiem na dole ostatni punkt stanowił informację o systemie informatycznym używanym na GPW. „System Warset” – tak też widniało na prezentacji w maju 2013 r. Jeden ze studentów podniósł rękę i zwrócił Pani doktor uwagę, że

od ponad miesiąca giełda funkcjonuje na nowej platformie UTP, na wzór giełd z grupy NYSE. Na następnych zajęciach slajd został poprawiony...

Po pierwsze, abstrahując już od wszelkiej oceny powyższej sytuacji, uzmysławia ona, iż wymiana systemu UTP chyba nie była rewolucją medialną. Po drugie, jak sama GPW przyznała, dla przeciętnego inwestora giełdowego system nie stał się przełomową rewolucją technologiczną. Aczkolwiek jest ścisły obszar dla którego UTP tą rewolucją już jest. Jest nim handel wysokiej częstotliwości, powszechnie znany jako High Frequency Trading. Nasz redaktor, Wojtek Milewski, postanowił przyjrzeć się bliżej ostatnim trendom na świecie z zakresu wykorzystywania algorytmów i komputerów w tradingu. W temacie znajdzie się również całościowa ocena HFT i jego wpływu na wszystkich uczestników rynku. Szczerze polecamy niezwykle interesującą lekturę, zarówno osobom, które o systemach już dotychczas pogłębiły swoją wiedzę, jak i czytelnikom spotykającym się z pojęciem po raz pierwszy.

Przyjemnej lektury!

Redaktor Naczelna

Redaktor Naczelna – Agnieszka Żurawska Redaktorzy Prowadzący – Przemysław Pryszcz,

Wojciech Milewski

Projekt graficzny – Agnieszka Żurawska, Kamil Prządka, Jakub Pawlik

Korekta – Izabela Wiśniewska, Agnieszka Żurawska

Strona internetowa tozalezy.pl – Kamil Prządka, Ewa Dębska

Okładka wykonana z wykorzystaniem grafik: nanex.net , altingfest.deviantart.com

Wydawca:

Koło Naukowe Strategii Gospodarczej Uniwersytetu Warszawskiego

Kontakt: [email protected]

SPIS TREŚCI TEMAT NUMERU High Frequency Trading, czyli spodziewany gość na polskiej giełdzie WOJCIECH MILEWSKI 4

RYNKI KAPITAŁOWE Kapitał własny jako forma finansowania transakcji fuzji i przejęć KATARZYNA OKOŃ 10

MAKROEKONOMIA Underemployment. Normalne zjawisko czy nowa dysfunkcja rynku pracy? MATEUSZ NIEWIŃSKI 14 Czy mamy się czego bać, czyli o ryzyku finansowym w Chinach BARTOSZ WASILWESKI 20 PRAWO Reklamacja bez paragonu EWA KOŚLACZ 24

TO ZALEŻY Minister Finansów Jacek Rostowski – dobry czy zły? MATEUSZ NIEWIŃSKI,

MARCIN SENDERSKI 26

EDUKACJA Ekseprymenty naturalne mogą odmienić oblicze nauk ekonomicznych. Wydobyte z natury MARCIN SENDERSKI 30

TECHNOLOGIE Koniec wojen patentowych? KAMIL PRZĄDKA 34

OPINIE Idea placement czy CSR? Czyli co warunkuje istnienie organizacji non-profit JOANNA CHLEBIEJ 36 Co z tymi emeryturami? TOMASZ HAŁAJ 38

RECENZJE Tim Clissold, Mr China, czyli Amerykanin w Pekinie JAN JĘCZMYK 40

SYLWETKI Marissa Mayer JOANNA CHLEBIEJ 42

ENGLISH SECTION Macroprudential Policy – a reborn of the new policy tools five years after the financial crisis PRZEMYSŁAW PRYSZCZ 44

N11Is it the time to redefine

emerging markets?

To Zalezy

.

Niezale¿ny Magazyn Studencki

Nr

3/20

12

ISSN 2084-7874

str. 58Koniec z rajami podatkowymi – o planach Ministerstwa Finansów

str. 40Bańki spekulacyjne kiedyś i dziś - jak niewiele uczy nas historia

str. 68Korespondencja z Sankt Gallen: Ryzyko wraca do łask

str. 28Cezary Stypułkowski - wywiad specjalnie dla To Zależy

To Zalezy

.

Niezale¿ny Magazyn Studencki

Nr

2/20

12

ISSN 2084-7874

Japonia – kraj „więdnącej” wiśni?

O tym, jak Japończycy stracili dwie dekady...Czy Japonii uda się utrzymać rekordowo niskie koszty obsługi długu?Czym jest balance sheet recession?

To Zalezy

.

Niezale¿ny Magazyn StudenckiNr 1/

2012

str. 16Czy czeka nas stracona

dekada?

str. 10Portugalia w świetle jupiterów

str. 52Eurocrisis and

Slovakia - glimpse into how the

country’s public, politicians

and experts view the situation

Eurostrefa jednak bez

Grecji?

str. 5Czy makroekonomia

ma jeszcze znaczenie?

Szklane sufity w biznesieczyli o kobietach, parytecie, zdrowym rozsądku oraz kontrowersyjnych regulacjach Komisji Europejskiej

str. 28Marcin Senderski Z dużej chmury mały deszcz

str. 24Bartosz Wasilewski Smok kontra orzeł. Renminbi jako waluta światowa?

str. 62Halil Yasin Keklik Neurofinance: How does the brain of an investor work?

str. 14Mateusz Niewiński Gdzie jesteś zielona, polska wyspo?

To Zalezy

.

Niezale¿ny Magazyn Studencki

Nr

1/20

13 (

4)

ISSN 2084-7874

str. 4

Temat numeru4

W kwietniu tego roku GPW wprowadziła, używany także na giełdach z grupy NYSE, system notujący UTP (Universal Trading Platform). Szybkość oraz ilość przesyłanych przez niego informacji umożliwia stosowanie technologii High Frequency Trading. Co prawda, obroty niezbędne do swobodnego wykorzystania strategii z nią związanych generowane są jedynie na pojedynczych spółkach i kontraktach, jednak wraz z systemem WARSET zniknęły techniczne ograniczenia. Polski rynek kapitałowy wchodzi w erę, gdzie człowiek tworzy i kontroluje algorytmy, resztą zajmuje się komputer.

HIGH FREQUENCY TRADING, czyli spodziewany gość na polskiej giełdzie.

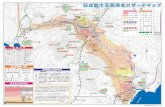

Rys. 1 Średnie opóźnienie realizacji zleceń - NYSE

źródło: opracowanie własne na podstawie www.utpplan.com

0,13

0,90

6,48

46,66

335,92

2007 2008 2009 2010 2011 2012 2013

MILISEKUNDY

Rosnące od lat 90-tych zainteresowanie wykorzystaniem na rynku możliwości komputerów, rozpoczęło trwający do dziś wyścig technologiczny pomiędzy bankami, funduszami i innymi instytucjami. Przyśpieszyło to rozwój handlu algorytmicznego, w którym zaprojektowany przez człowieka program jest instalowany na komputerze, gdzie stanowi instrukcje postępowania dla maszyny dokonującej transakcji.

emisoft.pl

Temat numeru 5

Wojciech MilewskiStudent III roku Wydziału Nauk

Ekonomicznych, laureat dziewiątej edycji Międzyuczelnianego Forum Dealerów Bankowych, stypendysta rektora UW, aktywny członek KNSG UW.

Dla przeciętnego czytelnika zaskakujący może wydać się fakt, że podstawową działalnością algorytmów jest dzielenie dużych zleceń złożonych przez człowieka na mniejsze i realizacji tych drugich. Transakcja przeprowadzana jest tak, aby całkowity wpływ na rynek był możliwie najmniej widoczny, a ceny wykonania jak najlepsze. Jest to postępowanie nastawione raczej na minimalizowanie kosztów, niż zysk sam w sobie. Programy te nie podejmują decyzji co do alokacji kapitału, a jedynie realizują zlecenia, stąd często, dla odróżnienia od bardziej zaawansowanych algorytmów decyzyjnych, nazywane są algorytmami egzekucyjnymi. Algorytmy decyzyjne natomiast, potrafią samodzielnie podjąć decyzję kiedy i jaki walor ma zostać zakupiony lub sprzedany, uwzględniając również rynkowe nastroje czy zarządzanie ryzykiem portfela. Swoje działania opierają nie tylko na analizie technicznej czy fundamentalnej, lecz często główną rolę gra tam pozbawiona jakiejkolwiek uznaniowości analiza ilościowa. Szczególnym rodzajem handlu algorytmicznego jest handel wysokich częstotliwości (High

Frequency Trading, HFT).

Czas to pieniądz – to aktualne od setek lat powiedzenie, obecnie staje się coraz bardziej dosłowne. Jego autor zapewne nawet nie był w stanie zmierzyć tego, co współcześni traderzy rozumieją pod słowem ‘czas’. W dobie coraz szybszych algorytmów, szybszych komputerów oraz szybszych łączy, prędkość przesyłania informacji stała się kluczową sprawą w uzyskaniu przewagi nad pozostałymi graczami. Na największych światowych parkietach gra w obszarze HFT nie toczy się o sekundy czy jej

setne części – obecnie czas liczy się w mili- lub mikrosekundach. Taka technologia umożliwia pełne wykorzystanie możliwości handlu algorytmicznego. Zysk w transakcjach HFT generowany jest dzięki minimalnym zwrotom z poszczególnych inwestycji (z reguły pojedyncze bp, co oznacza ułamki centa na akcje), jednak przy bardzo dużej ilości transakcji – w ciągu dnia pojedynczy algorytm przeprowadza ich nawet do kilku tysięcy. Dzięki temu rynki, na których obserwujemy działanie HFT, charakteryzują się wysoką płynnością i dużym wolumenem

Temat numeru6

obrotu. Zajmowana przez komputer pozycja zamykana jest w ciągu kilku minut, choć najczęściej jej czas nie przekracza paru sekund. Dlatego też, w tej grze nie biorą udziału długoterminowi inwestorzy, patrzący na transakcje z punktu widzenia tygodnia, miesiąca czy roku. Jednak, aby powyższe działania przyniosły oczekiwany zysk, konieczne jest wystąpienie kilku przedstawionych poniżej czynników.

Pierwszym elementem

niezbędnym do sprawnego funkcjonowania systemów HFT jest wysokiej jakości technologia. Im większe opóźnienia w przesyle informacji, tym większe prawdopodobieństwo, że zlecenie już w momencie przyjmowania do systemu znajdzie się poza rynkiem. Powoduje to, że zarówno giełdy jak i inwestorzy podejmują inwestycję w celu rozwoju technologii. Te pierwsze chcąc przyciągnąć do siebie graczy, rynkową płynność oraz pieniądze z tym związane,

starają się wyprzedzić konkurencję wprowadzając coraz nowocześniejsze systemy notujące. Mają one umożliwić szybszą obsługę większej ilości zleceń. Obecnie NYSE i NASDAQ realizują dziennie średnio odpowiednio 20 i 7 mln transakcji przy średnich opóźnieniach 0,37 i 1,3ms1 – dla porównania czasy reakcji monitorów LCD wynoszą od 1 do 5 milisekund. Gwałtowny rozwój techniki w tym względzie jest potwierdzany przez fakt, że 3 lata temu opóźnienia były kilkunastokrotnie większe. Mając świadomość skali, nie dziwi w tym momencie usługa kolokacji2. Jest to odpłatnie oferowana przez giełdy możliwość umieszczenia komputerów generujących zlecenia bezpośrednio w jej budynku. Oznacza to, że droga jaką będzie musiała pokonać informacja pomiędzy serwerem giełdowym, a systemem gracza, zostaje skrócona do minimum. Kolokacja powiązana jest z usługą DMA (Direct Market Access), która pozwala bankowi czy funduszowi mieć bezpośredni dostęp do rynku, z pominięciem brokera. W sferze prywatnych przedsięwzięć, możemy usłyszeć o światłowodach mających na celu bezpośrednie połączenie odległych rynków finansowych – przykładowo kosztem 300 mln dolarów połączono Chicago i New Jersey. Dysponując wystarczającą technologią, kolejnym krokiem jest zaprojektowanie odpowiedniego algorytmu. Jest to miejsce, w którym każdy komputer będzie 1 UTP SIP PLAN, 2013 Q2 U.S. Consolidated Tape Data2 W trakcie pisanie tego arty- W trakcie pisanie tego arty-kułu GPW opublikowało cennik usługi kolokacji – za kilkadziesiąt tysięcy zło-tych (20 tys. jednorazowo + 8 tys. co miesiąc) możemy stać się właściciela-mi jednej z nowych 18 szafek na nasz własny serwer postawiony tuż przy serwerze giełdy.

Temat numeru 7

zależny od człowieka. Wybory, jakie podejmie komputer, o ile nie zostaną błędnie przekazane, w rzeczywistości będą wyborami programisty. Najczęściej, programy tworzone są w powszechnie stosowanych, wydajnych językach programowania, tj. C++ lub Java. Jednak elementem HFT, który najbardziej różnicuje poszczególnych inwestorów, jest strategia uwzględniona w danym algorytmie.

Podstawową strategią jest market making, z tą tylko różnicą w stosunku do tradycyjnego, że nacisk kładziony jest na minimalne opóźnienie przekazywanego zlecenia. Dzięki szybkości przesyłanych informacji komputery nie musza się obawiać zmienności, mogącej spowodować, że nagle ich kwotowania znajdą się poza rynkiem. Powoduje to możliwość wystawienia oferty zawężającej spread. Co prawda, zlecenia te z reguły charakteryzują się mniejszym wolumenem niż tradycyjne, jednak z punktu widzenia rynku i tak prowadzą do ograniczenia kosztów transakcyjnych, a także zwiększają jego efektywność. Prawdopodobnie właśnie dzięki HFT, na przestrzeni ostatnich 5 lat rozwinięte rynki odnotowały skurczenie się spreadów od 2 do 5 razy3. Niewątpliwym wabikiem tej strategii są również pewne profity, które proponują giełdy w zamian za zapewnianie płynności. Szacuje się, że to niebudzące zastrzeżeń zastosowanie HFT, stanowi około 70 proc. wszystkich transakcji realizowanych z użyciem tej technologii4. Kolejną strategią jest arbitraż statystyczny. Polega on na zebraniu, analizie i 3 Analizy Credit Suisse AES4 The Diversity of High-Fre- The Diversity of High-Fre-quency Traders, Björn Hagströmer , Lars L. Norden, May 18, 2013

prognozowaniu cen powiązanych ze sobą instrumentów w celu wychwycenia odchyleń na poszczególnych rynkach. Jeśli owa różnica przekracza koszty transakcyjne, transakcja zostaje zawarta ze statystycznym zyskiem. Oczywiście człowiek nie byłby w stanie tak szybko wyliczyć odpowiedniej ceny i zaobserwować różnicy. Niewątpliwie, strategia ta stabilizuje rynek, sprzyjając ograniczeniu krótkookresowej zmienności. Spotkać się również możemy z arbitrażem wydarzeniowym, kiedy to komputery wykorzystują przewagę w szybkości uzyskania informacji nad innymi graczami. Pojawiająca się informacja często jest przyczyną nagłego ruchu ceny danego instrumentu. Algorytmy starają się więc jako pierwsze ustawić swoje zlecenia na rynku i w ten sposób wyprzedzić konkurencję. Szybkość transmisji danych niezbędna jest na każdym z etapów: zdobycia nowej informacji, przełożeniu jej na nowe ceny oraz aktualizacji cen. Podobnie jak w arbitrażu statystycznym, człowiek nie jest w stanie rywalizować z komputerem. Żadna z dotychczas omówionych strategii nie wykorzystuje jednak niejawnych informacji oraz nie powoduje utrudnień dla pozostałych graczy.

Istnieje też druga strona medalu, której negatywne oddziaływanie tak często rzutuje na całość. Brak regulacji prawnych powoduje, że możemy napotkać wiele programów mających na celu opóźnienie przekazu informacji dla innych graczy i wykorzystywanie zaawansowanej technologii w sposób etycznie wątpliwy. Najbardziej powszechną strategią wśród tych budzących wątpliwości, jest detekcja

płynności. Pozwala ona wykryć spodziewane ruchy rynku poprzez odszukiwanie ofert z limitem, obecnie niewidocznych w książce zleceń. Na rynek wysyłana jest duża ilość zleceń mająca na celu odkrycie limitów cen dla większych zleceń. Gdy tylko limit zostanie odkryty, komputer anuluje pozostałe wysłane przez siebie zlecenia, a następnie dzięki podłączeniu do innych giełd szybko wykupuje dany walor i odsprzedaje po wyższej cenie. Kolejną kontrowersyjną strategią jest flash trading, dający kilkudziesięcio milisekundowy podgląd oczekującego na przyjęcie do systemu zlecenia (co przy obecnych opóźnieniach, a raczej ich braku, daje szansę na jego wyprzedzenie). Praktyka ta na niektórych giełdach jest zabroniona, natomiast brak jest odgórnego jej zakazu. Ostatnim z istotnych, jednak chyba najmocniej krytykowanym zagrożeniem związanym z HFT, jest quote stuffing. Polega on na zapychaniu łączy ogromną ilością zleceń tak, aby opóźnić dostęp do informacji dla innych inwestorów. Jedynym sposobem na uniknięcie opóźnień z niego wynikających jest bezpośredni dostęp do systemu giełdy, dlatego też każda instytucja działająca w obszarze HFT taki dostęp posiada. Pozostali otrzymują bieżące kwotowania dopiero, gdy zostaną one przesłane przez giełdowy system. Giełdy w USA połączone są systemem CQS (Consolidated Quotation System), posiadającym wydajność 750 notowań na każda milisekundę. Za przyczyną powyższej strategii, bywają momenty, kiedy liczba ta, okazuje się niewystarczająca. Powoduje to, że cześć z inwestorów może otrzymywać informacje z rynku, które już nie są aktualne. Praktyka ta ograniczona jest przez nadzory

Temat numeru8

finansowe większości krajów. Prym, jeśli chodzi o regulację całego zagadnienia HFT, wiodą Niemcy oraz Kanada.

Największą zaletą, a jednocześnie wadą maszyny, jest to, że nie myśli. Zrobi to, co polecił jej wykonany przez człowieka algorytm, bez emocji, bez dopominania się o dodatkowe informacje, których nie zawierała instrukcja. Jak się okazuje, może to być drogą do ponadprzeciętnej rentowności. Wykazano, że transakcje bazujące na HFT posiadają wskaźnik Sharpe’a (miara nagrody na jednostkę ryzyka) kilkadziesiąt razy wyższy (9,2) niż tradycyjne strategie (0,31)5. Im krótszy okres, tym zyskowność jest większa, a wskaźnik Sharpe’a może sięgać wartości liczonych w tysiącach. Następnym czynnikiem zwiększającym atrakcyjność inwestycyjną, jest krótki czas testowania zaproponowanych rozwiązań – do wiarygodnej oceny zastosowanej techniki potrzeba zaledwie miesiąca lub dwóch miesięcy danych. Kolejną z cech charakterystycznych wszystkich strategii HFT jest fakt, że nie przewidują przetrzymywania walorów przez noc, co wiąże się z brakiem opłat z tym związanych. Nie bez znaczenia jest również nikła korelacja krótkookresowych 5 The Trading Profits of High Frequency Traders; Matthew Baron, Jonathan Brogaard, Andrei Kirilenko; sierpień 2012

wahań cen (stanowiących źródło zysku) z realną wartości firmy. Dzięki temu, skuteczność działania algorytmów HFT nie jest powiązana z panującą koniunkturą, co umożliwia dywersyfikację portfela. Wszystkie, wymienione teraz, jak i wcześniej czynniki, przyczyniają się do pokaźnego procentowego udziału HFT w giełdowych transakcjach – sięga on 51 proc. w USA i 39 proc. w UK.6 Warte zauważenia jest, że pomimo wysokiej skali udziałów i medialnego rozgłosu jakiego nabrały, zyski netto nie są imponujące w stosunku do dużych, tradycyjnych funduszy inwestycyjnych. Dużym obciążeniem finansowym są niezbędne ciągłe wydatki na 6 szacunki TABB Group

oprogramowanie i technologię. Szacuje się, że zyski całego sektora spadły do 1,25 mld w 2012 roku, w stosunku do 5 mld w roku 2009 roku.7 Przyczyną takiego stanu rzeczy może być rosnąca konkurencja w tym obszarze oraz niektóre regulacje, zabraniające stosowania części kontrowersyjnych praktyk.

Przeglądając internetowe artykuły, trudno nie zauważyć istnienia wielu głosów uznających HFT za kolejne niebezpieczne narzędzie stosowane przez dużych graczy w celu wyzyskania drobnego inwestora. W historii niejednokrotnie obserwowaliśmy już akcje, indeksy czy kontrakty, których 7 szacunki Rosenblatt Securi- szacunki Rosenblatt Securi-ties

Temat numeru 9

notowania za sprawą działania algorytmów bazujących na HFT, potrafiły w ciągu kilkudziesięciu sekund zanotować wahania rzędu kilkudziesięciu procent. Popularnym przykładem są wydarzenia z 6 maja 2010 roku zwane flash crash. Tego dnia na rynkach, w związku z sytuacją w Grecji, panowała duża niepewność. O godzinie 2:32, w momencie, kiedy rynek tracił już ponad 300 punktów (otwarcie na poziomie 10862) pewien fundusz (właściwie jego algorytm, jednak nie działający w technologii HFT) rozpoczął sprzedaż dużego pakietu kontraktów E-mini S&P500. Spowodowało to przeszacowanie przez algorytmy HFT wartości innych aktywów, co z kolei zaowocowało wzrostem podaży na rynku akcji. Podążające za trendem automaty, mocno go przyśpieszyły. Na domiar złego, z powodu zbyt dużej zmienności, części komputerów została wyłączona, co spowodowało zmniejszenie płynności i dalsze spadki. Od godziny 14:41, w ciągu 5 minut, DJIA spadł o 600 punktów, przez co łącznie tego dnia sięgnął poziomu -9,2 proc.8, jednak po kilkunastu kolejnych minutach indeks wrócił do poziomów sprzed 2:30. Wydarzenia te pokazują jak wielką siłę mogą mieć połączone algorytmy HFT, jeśli zostaną im przekazane jednoznaczne sygnały. Warto jednak zauważyć, że podążały one jedynie za rynkowym trendem, same nie stanowiąc impulsu. Kolejnym przykładem, według mnie lepiej oddającym ewentualne zagrożenia, jakie niesie ze sobą HFT, jest mający miejsce w sierpniu 2012 roku, niekontrolowany zakup aktywów przez fundusz Knight Capital. W związku z nieostrożnymi 8 raport SEC : http://www.sec.gov/news/studies/2010/markete-vents-report.pdf

testami nowo zainstalowanego oprogramowania, w ciągu niecałej godziny komputer realizował transakcje które ostatecznie zaowocowały dla funduszu łączną stratą w wysokości 460 milionów dolarów. Uświadamia to jak istotną częścią pracy w tej technologii powinna być kontrola algorytmów.

Podsumowując, HFT staje się kolejną gałęzią w rozwoju rynków kapitałowych. Należy podkreślić, że konieczne jest rozróżnienie na poszczególne strategie, które są od siebie znacząco odmienne. Zarówno sama technologia HFT, jak i zdecydowania większość jej zastosowań, moim zdaniem sprzyjają rynkom kapitałowym i popycha je do dalszego rozwoju. Z punktu widzenia długoterminowego inwestora nie wywierają one negatywnego wpływu na jego zysk, natomiast płynność, jaka jest zapewniona, pozwala mu go w każdej chwili zrealizować. Dzięki szybkości przesyłanych informacji, proces odkrywania ceny następuje szybciej, zwiększana jest stabilność rynku oraz niwelowane są międzygiełdowe wahania cen. Również węższe spready przyczyniają się do wzrostu efektywności rynku. Przeważająca część zastosowań HFT może być tłumaczona jako przyśpieszenie myśli programisty czy palców tradera. Gdyby tylko człowiek był w stanie analizować informacje tak samo szybko, prawdopodobnie nikt nie miałby mu za złe, że wykorzystując swoje doświadczenie kupuje taniej i sprzedaje drożej mimo, że obie transakcje wykonał w ciągu 1 sekundy. Problemem rzutującym na zagadnienie HFT są jednak strategie ukierunkowane bezpośrednio na utrudnianie działania innym inwestorom

oraz celowe wprowadzanie ich w błąd. Zysk osiągany dzięki informacjom niejawnym także jest mocno kontrowersyjny. Działania te nie zwiększają efektywności rynku, a jedynie przyczyniają się do powiększenia zasobności portfela najbardziej zaawansowanych technologicznie graczy oraz negatywnego postrzegania całej technologii. Niektóre fundusze, działając według zasady „duży może więcej”, ulegają pokusie i wykorzystują luki w ciągle nieusystematyzowanym w tym względzie prawie. Ustawodawcy powinni pamiętać, że to właśnie wobec tych „złych” zastosowań HFT powinny być ukierunkowane ich działania. Wzrosnąć powinny też obostrzenia dotyczące kontroli nowowprowadzanych algorytmów oraz nagłej zmienności na rynkach tak, aby w przyszłości nie powtórzyły się sytuacje z 1 sierpnia czy 6 maja.

Rynki kapitałowe10

Kapitał własny jako forma finansowania

transakcji fuzji i przejęć

Popularność fuzji i przejęć wzrasta z roku na rok. Początki tego typu transakcji w Polsce zauważa się w latach dziewięćdziesiątych XX wieku, czyli okresie po transformacji gospodarczej w naszym kraju. Wiązały się one z procesem prywatyzacji przedsiębiorstw państwowych, a następnie przejmowaniu ich przez podmioty zagraniczne. Z upływem czasu nastąpił wzrost znaczenia krajowych inwestorów, a co za tym idzie – zwiększyła się popularność transakcji fuzji i przejęć w Polsce. Dekoniunktura na rynku oraz światowy kryzys gospodarczy spowodowały, że liczba transakcji oraz ich wartość zmniejszyła się analogicznie do sytuacji na świecie. Obecnie rynek M&A w Polsce jest rynkiem stosukowo stabilnym. Zauważalne ożywienie gospodarcze pociąga za sobą wzrost ilości transakcji fuzji i przejęć.

Sposób finansowania odgrywa w przedsiębiorstwie istotną rolę, jest równie ważny w transakcjach fuzji bądź przejęcia. Wybór źródła finansowana transakcji powinien być poprzedzony dogłębnymi analizami sytuacji finansowej spółki, ponieważ wybrana forma finansowania może wpływać między innymi na wartość transakcji, postępowanie nabywców oraz przyszłe zyski, które przedsiębiorstwo planuje osiągnąć. Rodzaj oferty, motyw fuzji czy przejęcia, dostępność źródeł finansowania w danym otoczeniu, znajomość przepisów podatkowych, stopień

płynności finansowej podmiotu będącego nabywcą oraz poziom dźwigni finansowej podmiotu przejmującego i przejmowanego powinny być uwzględniane przy wyborze źródła finansowania transakcji M&A.W tym artykule analizie poddano kapitał własny jako jedno ze źródeł zdobycia gotówki na sfinansowanie transakcji fuzji bądź przejęcia. Kapitał własny (ang. equity) uznawany jest za jedną z tradycyjnych form finansowania. Powyższy rodzaj kapitału może być uzyskiwany ze źródeł wewnętrznych oraz zewnętrznych. Wśród źródeł wewnętrznych wyróżnia się

wypracowane i zatrzymane przez przedsiębiorstwo zyski. Opierają się one głównie na wykorzystaniu zgromadzonej przez przedsiębiorstwo gotówki. Natomiast wśród źródeł zewnętrznych wymienia się między innymi wpływy z emisji akcji lub udziałów. W literaturze kapitał własny prezentowany jest jako stosunkowo bezpieczne źródło pozyskania kapitału. W procesie finansowania fuzji i przejęć jako źródło kapitału własnego wykorzystać można gotówkę przedsiębiorstwa pochodzącą głównie z wypracowanych zysków. Ponadto wymienia się

capitalcampaignmagic.com

Rynki kapitałowe 11

możliwość pozyskania funduszy poprzez emisję akcji z prawem poboru dla dotychczasowych akcjonariuszy, czy finansowanie private equity oraz venture capital.Posiadana gotówka to najbardziej płynna forma oszczędności. Służy ona finansowaniu bieżących inwestycji, ale jej nagromadzenie można wykorzystać przy finansowaniu większych inwestycji. W literaturze spotyka się pojęcie kosztu utraconej wartości, który wiąże się z utratą pewnych korzyści w związku z realizacją innej inwestycji.Emisja akcji jest kolejną formą wykorzystującą kapitał własny. Ta forma pozyskania kapitału dotyczy spółek kapitałowych. Można dokonać jej na przykład w ofercie prywatnej. Wtedy skierowana jest ona do ograniczonej liczby inwestorów. Można również przeprowadzić emisję w ramach oferty publicznej. W emisji akcji, spółka akcyjna uznawana jest za stronę krótką transakcji, natomiast stroną długą jest inwestor. Istnieje możliwość sprzedaży akcji innym inwestorom na rynku wtórnym. Wspomniane prawo poboru (ang. subscription right) daje posiadaczowi akcji spółki możliwość zakupu akcji z nowej emisji po ustalonej wcześniej cenie emisyjnej. Kapitał private equity/venture capital zaliczany jest do kapitału o charakterze średnio lub długoterminowym. Najczęściej ten rodzaj finansowania występuje w przedsiębiorstwach, które nie są notowane na rynku giełdowym. Głównym celem inwestora jest wzrost wartości przedsiębiorstwa. Inwestor dostarcza niezbędnego kapitału, ale także udziela wsparcia menedżerskiego. Ten rodzaj

uznawany jest za stosunkowo ryzykowny.Trudno jest określić wielkość zysku, którą można osiągnąć wykorzystując kapitał własny. Każda forma finansowanie wiąże się z ponoszeniem kosztu. Wśród metod służących do oszacowania kosztu kapitału własnego w przedsiębiorstwie wyróżnia się model Gordona służący do oceniania kapitału akcyjnego zarówno zwykłego, jak i uprzywilejowanego, model wyceny aktywów kapitałowych CAPM, który określa koszt pozyskanego kapitału akcyjnego, model Bond plus, nazywany metodą stopy dochodu z obligacji z premią za ryzyko oraz metodę składania poszczególnych elementów ryzyka. Kapitał własny to jedna z form finansowania. Posiada ona zarówno zalety i wady. Do głównych zalet zalicza się łatwość oraz niski koszt pozyskania kapitału własnego. Jest to kapitał bezterminowy, a podlega on spłaceniu jedynie w przypadku likwidacji spółki czy podjęciu uchwały walnego zgromadzenia o umorzeniu akcji. Kolejną zaletą jest możliwość zachowania kontroli nad firmą, o ile w ramach emisji akcje lub udziały obejmują dotychczasowi akcjonariusze.

Udział akcjonariuszy w zyskach pozostaje bez zmian. Pozytywną stroną jest również fakt, że emitent może sam decydować o terminie spłaty, warunkach emisji, cenie, oprocentowaniu obligacji. Znaczącą zaletą jest małe ryzyko uzyskiwania środków z kapitału własnego. Finansowanie kapitałem własnym ma również wady. Jedną z nich są formalności niezbędne przy emisji akcji. W przypadku emisji akcji wadą jest również zmniejszenie udziału dotychczasowych właścicieli w zyskach przedsiębiorstwa, jednak może to być wyeliminowane poprzez nabywanie akcji przez dotychczasowych właścicieli. Analizując wybór źródła finansowania w procesie fuzji i przejęć, należy odwołać się do popularnych modeli rynkowych. Wybór kapitału własnego jako rodzaju finansowania odnosi się do modelu anglosaskiego, w którym dominuje powyższa forma. Model ten nazywany jest również modelem rynkowo zorientowanym (ang. market-based system). Model anglosaski opiera się na rynku finansowym, a dokładniej – na rynku kapitałowym. Funkcjonuje w krajach takich jak Stany Zjednoczone, Kanada, Australia, Wielka Brytania.

KATARZYNA OKOŃ

Studentka Uniwersytetu Ekonomicznego w Poznaniu,

kierunku Inwestycje Kapitałowe i Strategie Finansowe Przedsiębiorstw na Wydziale Zarządzania oraz kierunku Finanse, Audyt i Podatki na Wydziale Ekonomii. Interesuje się fuzjami i przejęciami, rynkami kapitałowymi oraz metodami finansowania przedsięwzięć.

Rynki kapitałowe12

strategicehs.com

Polega na poszukiwaniu źródeł finansowania na rynkach kapitałowych poprzez wykorzystanie obecnych na nim form finansowania powiązanych z giełdą i emisją papierów wartościowych. Pozyskiwanie kapitałów opiera się na emisji zbywalnych instrumentów finansowych za pośrednictwem giełdy i rynku kapitałowego. W powyższym systemie rola banków jest minimalna i ogranicza się do udzielana

kredytów krótkoterminowych na pokrycie bieżącej działalności. Nieco większą rolę w modelu anglosaskim mają fundusze oraz banki inwestycyjne, ponieważ są one powiązane z działalnością rynku kapitałowego.Podsumowując, nie ma jednej idealnej formy finansowania, która zapewnia o powodzeniu transakcji, dlatego kapitał własny może stanowić źródło finansowania wybierane w procesie fuzji i przejęć.

Omówiona forma posiada zarówno wady jak i zalety, jednak decyzja o jej wyborze zależy od wielu czynników, między innymi od specyfiki podmiotu i rynku, branży, w której prowadzona jest działalność oraz zysków, jakie przedsiębiorstwo chce osiągnąć. Źródło finansowania określa sposób zdobycia środków niezbędnych do opłacenia transakcji, dlatego nie należy go utożsamiać z formą zapłaty.

GLOBAL MANAGEMENT CHALLENGEPoland 2013

po raz 14 w Polsce!

NOWY SYMULATOR!Rozbudowany zakres decyzyjny

Patron honorowy

Patroni mediani:

Sponsorzy:

Organizator:

www.gmcpoland.pl

Rejestracja zespołów studenckich jest możliwa do 30 października.

GMC posiada akredytację Europejskiej Fundacji Rozwoju Zarządzania.

»pół miliona

uczestników na świecie!

»25 tysięcy

absolwentów w Polsce!

Zapraszamy drużyny studenckie (3-5 osób) do rywalizacji w wirtualnym świecie biznesu!

» pierwsze praktyki zarządzania » weryfikacja i uzupełnienie wiedzy akademickiej » rozwój umiejętności: pracy w zespole,

planowania strategicznego, myślenia analitycznego

» rywalizacja z profesjonalistami i praktykami biznesu

» nawiązanie kontaktów z potencjalnymi pracodawcami

» promocja finalistów w prasie i Internecie » możliwość udziału w Finałowej Gali » dla zwycięzców – reprezentowanie naszego

kraju na Finałach Światowych, studia podyplomowe w Akademii Koźmińskiego

Korzyści dla studentów:

GMC to największa na świecie symulacja biznesowa - interaktywna gra strategiczna, w której zespoły wcielają się w role zarządów wirtualnych przedsiębiorstw. Projekt jest przeznaczony dla studentów i menedżerów, którzy chcą rozwijać twarde, biznesowe umiejętności, jak i miękkie, związane ze współdziałaniem, wzajemną motywacją.

Współpraca Patron internetowy

WARSAW

short logotype

horizontal logotype

vertical logotype

Rynki kapitałowe 13

GLOBAL MANAGEMENT CHALLENGEPoland 2013

po raz 14 w Polsce!

NOWY SYMULATOR!Rozbudowany zakres decyzyjny

Patron honorowy

Patroni mediani:

Sponsorzy:

Organizator:

www.gmcpoland.pl

Rejestracja zespołów studenckich jest możliwa do 30 października.

GMC posiada akredytację Europejskiej Fundacji Rozwoju Zarządzania.

»pół miliona

uczestników na świecie!

»25 tysięcy

absolwentów w Polsce!

Zapraszamy drużyny studenckie (3-5 osób) do rywalizacji w wirtualnym świecie biznesu!

» pierwsze praktyki zarządzania » weryfikacja i uzupełnienie wiedzy akademickiej » rozwój umiejętności: pracy w zespole,

planowania strategicznego, myślenia analitycznego

» rywalizacja z profesjonalistami i praktykami biznesu

» nawiązanie kontaktów z potencjalnymi pracodawcami

» promocja finalistów w prasie i Internecie » możliwość udziału w Finałowej Gali » dla zwycięzców – reprezentowanie naszego

kraju na Finałach Światowych, studia podyplomowe w Akademii Koźmińskiego

Korzyści dla studentów:

GMC to największa na świecie symulacja biznesowa - interaktywna gra strategiczna, w której zespoły wcielają się w role zarządów wirtualnych przedsiębiorstw. Projekt jest przeznaczony dla studentów i menedżerów, którzy chcą rozwijać twarde, biznesowe umiejętności, jak i miękkie, związane ze współdziałaniem, wzajemną motywacją.

Współpraca Patron internetowy

WARSAW

short logotype

horizontal logotype

vertical logotype

Makroekonomia14

Underemployment sprawia wiele problemów statystykom i ekonomistom, zaczynając od polskiego tłumaczenia – „zatrudnienie poniżej kwalifikacji”, które jest nieco karkołomne, lecz moim zdaniem najodpowiedniejsze1. Inny problem to sprecyzowanie, co konkretnie ten wskaźnik ma mierzyć. Obecnie odnosi się on do trzech rozłącznych zjawisk:

− nadmierne wykwalifikowanie (ang. overqualification), czyli osoba, która posiada specjalistyczne wyszkolenie (np. wyższe wykształcenie kierunkowe, specjalne licencje, względnie duże doświadczenie) pracuje na stanowisku, które nie wymaga tych umiejętności, np. lekarz pracujący jako

1 Alternatywne tłumaczenie to „niepełne wykorzystanie siły roboczej”, które przedstawia problem z punktu widzenia makroekonomii. Angielski termin jest częściej stosowany w odniesieniu do człowieka, który jest “underemployed”, tzn. zatrudniony poniżej kwalifikacji.

dostawca, inżynier będący sprzedawcą, itd. Jest to jednocześnie najtrudniejsza kategoria do zmierzenia, gdyż tak ostre przypadki jak wyżej wymienione zdarzają sie dość rzadko, a statystycy częściej mają do czynienia z zatrudnieniem poniżej kwalifikacji na poziomie stanowisk w ramach jednej branży;

− mimowolna praca w niepełnym wymiarze godzin (ang. involuntary part-time), osoba, która ma możliwość i chęć pracować w pełnym wymiarze godzin, lecz znajduje tylko możliwość zatrudnienia na niepełny etat. To dość „łatwa” do zmierzenia kategoria, wystarczą badania ankietowe. Warto zauważyć, że część pracowników z tej grupy nadal poszukuje pracy, tj. innej w pełnym wymiarze godzin lub dodatkowej na niepełnym etacie;

Zatrudnienie poniżej kwalifikacji to zjawisko, które bada się od kilku-kilkunastu lat, lecz jednocześnie nie mówi się o nim prawie wcale. Łatwiej jest skomentować stopę bezrobocia, gdyż ten atrybut gospodarki jest względnie łatwo mierzalny, zrozumiały i ważny dla przeciętnego przedstawiciela nowoczesnego społeczeństwa. Jednak do określania sytuacji gospodarczej, samo zjawisko bezrobocia nie wystarczy. Ekonomiści, w myśl zasady: «pokaż mi swój rynek pracy, a powiem ci jaką gospodarką jesteś», badają charakterystyki tego rynku. Jedną z najważniejszych cech rynku pracy, poza bezrobociem, jest właśnie zjawisko underemployment.

Normalne zjawisko czy nowa dysfunkcja rynku pracy? UNDEREMPLOYMENT. tr

ippy

4u.d

evia

ntar

t.com

bqw

.dev

iant

art.c

om

Makroekonomia 15

− przerost zatrudnienia (ang. overstaffing), co oznacza zatrudnianie nadmiernej liczby pracowników, których możliwości nie są w pełni wykorzystywane. Nie należy tego mylić (choć jest to powiązane) z przetrzymywaniem pracowników przez okres recesji (aby oszczędzić na kosztach ponownej rekrutacji), bo przerost zatrudnienia ma miejsce niezależnie od cyklu koniunkturalnego. Niestety, na poziomie całej gospodarki, nie da się zmierzyć tej grupy pracowników, choć można próbować szacować ukryte bezrobocie2;

Z punktu widzenia makroekonomisty, underemployment jest szacunkową, dodatkową miarą oddalenia produkcji bieżącej od produkcji potencjalnej, którą należy uwzględnić w zależności poziom bezrobocia-wzrost gospodarczy. W tym wypadku pożądaną wartością jest wskazanie 2 Jest to inna nazwa przerostu zatrudnienia.

bliskie zera przy naturalnej stopie bezrobocia. Innymi słowy, prawie wszyscy pracownicy w gospodarce są wykorzystywani adekwatnie do swoich możliwości i nie zasilają grupy bezrobotnych.

Społeczny punkt widzenia jest nieco inny. Zatrudnienie poniżej kwalifikacji w krótkim terminie zawsze będzie lepsze niż brak pracy. Jednak im dłużej osoba pracuje na stanowisku, które uważa za wymagające umiejętności poniżej jego kwalifikacji, a także nie jest w stanie znaleźć nowej, bardziej adekwatnej pracy, tym większa jej frustracja, co może powodować szereg różnego rodzaju chorób lub zachowań społecznych, podobnie jak u osób bezrobotnych. Jednak w tym przypadku te zachowania zwykle są nierozumiane, bo te osoby mają w końcu źródło utrzymania.

Teoria teorią, ale jak to się liczy?

Statystyczna miara underemployment zależy od kraju przeprowadzającego badanie, lecz żadna

MATEUSZ NIEWIŃSKI

Trader, analityk, publicysta, blogger. Student II roku studiów II stopnia na kierunku Finanse i Rachunkowość w SGH. Na rynku Forex od grudnia 2006. Ulubione tematy to opcje walutowe i midterm trading. Ciągle doskonali swoje umiejętności, chętnie poznaje nowe dziedziny finansów. Aktywnie działa na rzecz polskiej społeczności traderów Forex.

blad

eren

nard

.dev

iant

art.c

om

Makroekonomia16

z nich nie oddaje w pełni skali zjawiska. W USA, Bureau of Labor Statistics, przedstawia kilka miar stopy bezrobocia, a zjawisko zatrudnienia poniżej kwalifikacji całkiem nieźle, choć bardzo umownie, określa różnica między stopą bezrobocia U-6 i U-3 lub różnicy między U-6 i U-4. Miarą oficjalną jest stopa U-3, a wszystkie z wyższą cyfrą zawierają informacje o dodatkowych osobach, które nie są „oficjalnie bezrobotne”. To całkiem dobre przybliżenie poziomu underemployment. Stopa U-6 zawiera oprócz oficjalnie bezrobotnych także tzw. discouraged workers3, inne osoby, które z różnych przyczyn nie poszukiwały ostatnio pracy oraz osoby zatrudnione w niepełnym wymiarze godzin, które mogą pracować na pełny etat4. Te kategorie można różnie traktować, ostatnia doskonale pokrywa jedną ze składowych omawianego zjawiska, a pozostałe odnoszą się do niego w pewnej części.

W Unii Europejskiej badania są nieco dokładniejsze, bo publikowane są oddzielne wskaźniki określające jako procent siły roboczej: zatrudnionych poniżej kwalifikacji w niepełnym wymiarze godzin, osób poszukujących pracy, lecz niedostępnych natychmiastowo (bezrobotnych lub zatrudnionych, którzy szukają nowej pracy, lecz w najbliższym czasie nie mogą jej wykonywać) oraz osób mogących pracować, lecz nieposzukujących

3 To osoby niewliczane do siły roboczej, ponieważ nie poszukiwały zatrudnienia w ciągu ostatnich czterech tygodni, lecz są zdolne i chętne do znalezienia pracy w przyszłości. 4 Więcej informacji jest dostępne na oficjalnej stronie BLS: www.bls.gov/lau/stalt.htm

pracy5.

Te miary nie odzwierciedlają w całości, ani nawet w większej części, definicji underemployment przedstawionej na początku artykułu, lecz są powszechnie stosowane przez statystyków i ekonomistów. Nie bez podstaw. Osoby zdolne do pracy, lecz jej nieposzukujące w ciągu ostatnich kilku tygodni, to tylko miara statystyczna i trzeba pamiętać, że nawet jeśli nie są wliczane do siły roboczej, pracować mogą. Z pewnych powodów nie znalazły pracy, być może jej nie było, ale całkiem prawdopodobnie nie znaleźli odpowiedniej pracy do swoich kwalifikacji. Można więc nadać tej grupie etykietę «niezatrudnieni z powodu braku odpowiedniej pracy”. W jakimś stopniu oddaje to zjawisko zatrudnienia poniżej kwalifikacji – co więcej, jest stosowane w większości opracowań, stąd te same wskaźniki będą omówione w dalszej części artykułu.

A w jaki sposób powinno się odpowiednio mierzyć tę grupę społeczną? Ciekawą koncepcją jest badanie bezrobocia wśród młodych, gdyż ta grupa jest najbardziej narażona na zatrudnienie poniżej kwalifikacji. Szczególnie ciekawe jest monitorowanie losu absolwentów szkół zawodowych, techników i uczelni wyższych, aby sprawdzić, czy pracują w wyuczonym zawodzie i na stanowiskach umożliwiających im wykorzystanie nabytej wiedzy i umiejętności. Bardziej odważną 5 Informacje o tych wskaźnikach są dostępne na stronie internetowej Eurostatu i obejmują szczegółowe statystyki: http://epp.eurostat.ec.europa.eu/statistics_explained/index.php/Underemployment_and_potential_additional_labour_force_statistics

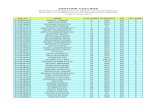

Rys. 1 Suma wskaźników dot. underemployment w UE na przykładzie UE (27 krajów), strefy euro (17 krajów) i Polski.

źródło: Eurostat

Makroekonomia 17

koncepcją byłoby zadanie kilku dodatkowych pytań podczas spisów powszechnych, które odnosiłyby się do problemu zatrudnienia poniżej oczekiwań. Z pewnością byłaby to najdokładniejsza dostępna miara tego zjawiska.

Underemployment na świecie

Obserwując poziom zatrudnienia poniżej oczekiwań (w wersji statystycznej) i wykorzystując dostępne informacje, można wyciągnąć kilka ciekawych wniosków. Niestety, nawet te dane należy przyjąć z dystansem, gdyż okres ich zbierania nie jest jeszcze dostatecznie długi. Obejmują około dwóch cykli gospodarczych w USA i jeden niepełny w Europie. Na stronie internetowej International Labour Organistation możemy znaleźć komunikat: The ILO does not have a program of statistical compilation of underemployment series6. Problem nie jest nowy, wcześniej nie zwracano na niego uwagi, a dopiero w 1994 roku, w Stanach Zjednoczonych, spróbowano wstępnie oszacować zjawisko. W Europie pełne dane są dostępne dopiero od 2008 roku (część z nich od 2005 roku). Ale mimo tych braków można wyciągnąć sensowne wnioski.

6 “ILO nie posiada statystycznego zbioru danych dotyczącego zatrudnienia poniżej kwalifikacji”, źródło: www.ilo.org/global/statistics-and-databases/statistics-overview-and-topics/underemployment/national-statistics-and-ilo-compilation-activities/lang--en/index.htm

Wcześniej, kilka statystyk dla Stanów Zjednoczonych, opartych na różnicy między wskaźnikami U-6 i U-3: przeciętna wartość spreadu to 4,6 punktu procentowego, minimalna 2,9 (2000r.), maksymalna 7,3 (2010r.). Średnia wartość jest zawyżona przez ostatni kryzys, gdyż w czasie poprzedniej recesji wartość różnicy była zbliżona do 4 p.p. W Europie wielkość underemployment jest mierzona poprzez zsumowanie trzech wymienionych wcześniej w artykule wskaźników, i w badanym okresie wynosi ok. 5 proc. dla krajów Unii Europejskiej (EU27) i ok. 3,6 proc. dla Polski. Wyjaśnienie znacznie niższego odczytu może być poparte przez szereg hipotez:

− Eurostat i GUS mają nieco inne metodologie liczenia stopy bezrobocia, dlatego dla Polski jest ona średnio niższa o kilka p.p. według Eurostatu. Te same zjawisko może występować w przypadku innych miar związanych z rynkiem pracy;

− przeciętnie Polacy mają niższe kwalifikacje zawodowe (mimo rosnącego odsetka osób z wyższym wykształceniem), dlatego szybciej znajdują pacę odpowiadającą ich kwalifikacjom (mniejszy problem nadmiernego wykwalifikowania) lub stają się bezrobotni;

− dobrze wykształceni młodzi Polacy mają większe szanse na zatrudnienie

Rys. 2 Porównanie stóp bezrobocia w Stanach zjednoczonych: U-3 i U-6, kolorem szarym zaznaczono okresy recesji.

źródło: BLS, Macrotrends

Makroekonomia18

w dowolnym kraju Unii Europejskiej, w zawiązku z czym pracują na stanowisku odpowiadającym ich kwalifikacjom poza granicami Polski;

− Polska jest zaliczana do krajów emerging markets i cechuje się średnio wyższym wzrostem gospodarczym, a więc większymi możliwościami do tworzenia nowych miejsc pracy, które wymagają wysokich kwalifikacji7.

Niezależnie od tego, która z hipotez wyjaśnia sytuację, można zauważyć, że w Polsce, przynajmniej statystycznie, problem ten jest mniejszy w porównaniu z krajami bardziej rozwiniętymi. Jednak aby wyznaczyć bardziej ogólne trendy, trzeba spojrzeć na dane opisujące amerykański rynek pracy i na ich podstawie można stwierdzić, że:

− zatrudnienie poniżej kwalifikacji jest cykliczne podobnie do zjawiska bezrobocia8;

− w czasie recesji stopa underemployment rośnie szybciej niż stopa bezrobocia, a w czasie ożywienia spada szybciej niż stopa

7 Ta hipoteza jest poparta założeniem, że zjawisko underemployment zachowuje się podobnie jak zjawisko bezrobocia, co wymaga nieco bardziej zaawansowanego dowodu. W tym przypadku to założenie zostało sformułowane na podstawie nieekonometrycznej analizy danych statystycznych z USA i Europy. 8 Wniosek wyciągnięty w oparciu o oficjalne wskaźniki, jednak raport Measuring Underemployment at the County Level przedstawia badania, które dowodzą, że nie istnieje związek statystyczny między bezrobociem i underemployment (str. 11).

bezrobocia (spread się zwęża), a więc jest bardziej zmienna;

− stan zatrudnienia poniżej kwalifikacji jest swoistym buforem między zatrudnieniem oczekiwanym a pozostaniem bez pracy, co jest szczególnie ważne podczas recesji (pozwala zachować obywatelom źródło dochodu);

− (hipoteza) stopa underemployment jest średnio niższa w krajach rozwijających się (o średnim wyższym wzroście gospodarczym) niż w krajach rozwiniętych9;

− (ciekawostka) wzrostu stopy zatrudnionych poniżej kwalifikacji można się spodziewać między grudniem a styczniem, a spadku między lutym a marcem, najbardziej stabilnym miesiącem jest grudzień10 (dotyczy tylko USA).

Powyższe wnioski nie są przełomowe i sprowadzają się do zastosowania analizy zbliżonej do analizy bezrobocia. Zresztą, teoria ekonomii sugeruje, aby traktować zjawiska bardzo podobnie, gdyż są 9 Wymaga to badań i odpowiedniego dowodu, sam przykład Polski i innych rozwijających się członków UE nie jest wystarczający. Dlatego podaną hipotezę należy na razie traktować jako luźne spostrzeżenie. 10 Technicznie: odczyty spreadu wyższego w styczniu niż w grudniu (11 przypadków wzrostu i 4 utrzymania na próbie 20) i niższego w marcu niż w lutym (13 przypadków spadku i 3 utrzymania na próbie 20). W grudniu wielkość spreadu była taka sama jak w lutym 9 razy na 19 przypadków (przy trzech możliwych wynikach: wzrost, spadek, utrzymanie). Próba jest zbyt mała, a te wnioski nie mogą być potwierdzone w danych Eurostatu (odczyt kwartalny), więc należy to traktować jako statystyczną ciekawostkę.

CIEKAWE PUBLIKACJE:

1. Under-employment crisis. A TUC analysis of under-employment across the UK, http://bit.ly/N82hoD

2. Measuring Underemployment at the County Level by Christopher R. Bollinger, Paul Coomes and Mark Berger, August 2003, http://www.ukcpr.org/Publications/Bollinger_DP2003-08.pdf

3. Unemployment and inactivity in the 2008–2009 recession, Paul Gregg and Jonathan Wadsworth, http://tinyurl.com/napm35w

4. An econometric analysis of underemployment and overemployment in the UK, Jose Luis Iparraguirre and Hui-Yu Tseng, http://tinyurl.com/npmahe9

5. Psychological Effects of Unemployment and Underemployment, Kerry Bolger, PhD, www.apa.org/about/gr/issues/socioeconomic/unemployment.aspx

6. Underemployment and potential additional labour force statistics, Eurostat, http://tinyurl.com/nfpk6cj

Makroekonomia 19

silnie powiązane. Pozostaje mieć nadzieję, że w przyszłości jakiś sławny ekonomista obierze za temat swoich badań ilościową zależność między wzrostem gospodarczym, stopą bezrobocia i stopą underemployment oraz dostarczy nowych ciekawych wniosków w tej dziedzinie.

Skutki ekonomiczne i społeczne

We wcześniejszych akapitach wykazano, że zatrudnienie poniżej kwalifikacji jest podobne do bezrobocia. Można pomyśleć, że ich skutki są takie same. To fakt, są one podobne, lecz pojawiają się w innym czasie i z pewnego punktu widzenia, skutki underemployment są „łagodniejsze”. Z prawie każdego punktu widzenia, lepiej być zatrudnionym11 niż bezrobotnym, jednak te dwa różne stany wywołują różne implikacje ekonomiczne. Zatrudnieni nie są uwzględniani w oficjalnej stopie bezrobocia, bo albo pracują w niepełnym wymiarze godzin albo są wyłączeni z siły roboczej. Poza tym, coś produkują, świadczą usługi itp., tylko w stopniu o wiele niższym niż ich możliwości. W związku z tym mają swój udział w tworzeniu PKB, choć nie tak duży, jaki potencjalnie mogliby mieć. To ma znaczenie głównie w rozważaniach teoretycznych, szczególnie, że oficjalnie ta grupa nie jest zbyt liczna (wyżej pokazano, że przeciętny poziom underemployment to ok. 4-5% siły roboczej), więc na realny wzrost PKB wpływ ma niewielki. Poza tym, nie trzeba subsydiować tej grupy (np. zasiłek dla bezrobotnych), płaci ona świadczenia (podatek dochodowy i inne, np. ubezpieczenie zdrowotne), a także stanowi bardziej aktywnych konsumentów w porównaniu do bezrobotnych. Grupa zatrudnionych poniżej kwalifikacji powoduje 11 Od tego momentu zatrudniony i zatrudniony poniżej kwalifikacji będą używane wymiennie.

mniejsze skutki ekonomiczne niż bezrobotni, przez co jest najczęściej ignorowana.

Pod względem oddziaływania na społeczeństwo, grupa underemployed także nie wpływa na nie tak negatywnie jak grupa bezrobotnych. Głównie dlatego, że ciągle mają źródło dochodów i mogą zaspokoić przynajmniej podstawowe potrzeby swoje i swoich rodzin. Jednak osoby zatrudnione na mniej ważnych, mniej płatnych lub mało prestiżowych stanowiskach, mogą się spotkać z wykluczeniem społecznym i negatywnymi reakcjami innych ludzi. Mogą

też czuć się pozbawione pomocy instytucji państwowych, jako osoby, które ostatecznie mają pracę, i nie otrzymać np. darmowych świadczeń, które otrzymują bezrobotni. Najpoważniejszym skutkiem społecznym może być emigracja do krajów, w których łatwiej znaleźć zatrudnienie w danej dziedzinie, co można zaobserwować obecnie w Unii Europejskiej, poprzez np. wchłanianie specjalistów z południa i wschodu Europy przez kraje Europy Zachodniej.

Podsumowanie

Problem underemployment nie jest zjawiskiem nowym, lecz w poprzednich dekadach nie przywiązywano do niego jakiejkolwiek wagi. Dopiero niedawno podjęto próby sprecyzowania zjawiska, zmierzenia go i wyciagnięcia konstruktywnych wniosków. Niestety, oficjalne miary, choć przybliżają wielkość grupy zatrudnionych poniżej kwalifikacji, nie oddają w pełni obrazu zjawiska. Można by wiele dyskutować o dysproporcjach ze względu na pochodzenie, płeć i wiek, ale to nie ma znaczenia, dopóki nie pojawią się odpowiednie badania tej grupy. Nie do końca wiadomo, czy underemplyment to tylko dodatek do bezrobocia i podlega tym samym prawom, czy to zupełnie inne zjawisko, które należy dopiero opisać teoretycznie. Zwłaszcza, że badania BLSu wskazują na występowanie tej zależności, a inne badania, np. raport Measuring Underemployment at the County Level i dane Eurostatu (które jednak są zbyt mała próbą aby wyciągnąć istotne wnioski) – już nie. Pozostaje tylko mieć nadzieję, że ten problem zostanie zbadany i rozstrzygnięty, do czego zachęcam czytelników, zwłaszcza, ze to bardzo dobry temat na prace magisterską, jeśli nie nawet na rozprawę doktorską.

12m

ilebr

.wor

dpre

ss.co

m

Makroekonomia20

Pod koniec XVIII wieku Wielka Brytania, która po wojnie siedmioletniej była już wówczas największą potęgą świata, podjęła kompletnie nieudaną próbę nawiązania stosunków handlowych z Chinami. Szefem poselstwa Jerzego III do Państwa Środka był George Macartney, który zupełnie nie potrafił odnaleźć się w chińskiej rzeczywistości – choć teza ta jest kontrowersyjna wśród historyków, to uważa się, że fiasko rozmów brytyjsko-chińskich wynikało ze zbyt butnej postawy dyplomaty w stosunku do cesarza Qianlong. Jakkolwiek było naprawdę, niewątpliwe jest, że wizyta Macartneya doprowadziła do zderzenia dwóch zupełnie innych światów, które dotychczas niczego o sobie nawzajem nie wiedziały. Plonem tej wizyty były również słynne słowa: „nic bardziej mylnego niż ocenianie Chin według norm europejskich”, znane obecnie szeroko jako tzw. „aksjomat Macartneya”. Truizm – mógłby ktoś rzec. Zaskakujące jest jednak, jak często trzeba go przypominać i jak wiele „europejscy” (według realiów XXI wieku po prostu zachodni) obserwatorzy tracą, gdy o nim zapominają.

Czy mamy się czego bać, czyli o ryzyku finansowym w Chinach

panoramio.com

Makroekonomia 21

Świetnym przykładem takiego postępowania jest przerażenie z jakim wiele analityków opisuje czerwcowe wydarzenia na chińskim rynku międzybankowym nazwane chińskim „credit crunch” (co dosadnie pokazuje, że o „banalnym” aksjomacie Macartneya kolejny raz zapomniano). 20 czerwca stopa jednodniowych (overnight) pożyczek międzybankowych w Chinach wyniosła rekordowe 13,85%, a najistotniejsza stopa tego rynku – 7-dniowa stawka repo – 12,06% (obie stopy oczywiście w skali roku). Niedługo

później indeksy chińskich akcji znalazły się na poziomach najniższych od czterech lat. W większości komentarzy mogliśmy przeczytać o niespodziewanym wzroście ryzyka kryzysu finansowego w Chinach i niedoborze płynności na tamtejszym rynku międzybankowym. Prawdziwe nie jest ani jedno, ani drugie, a sytuacja podczas „credit crunch” z czerwca i następujących po nim tygodniach każe raczej postawić tezę, że chiński sektor finansowy jest bezpieczniejszy i stabilniejszy niż wcześniej.

BARTOSZ WASILEWSKI

Student Wydziału Prawa i Administracji UW oraz Szkoły

Głównej Handlowej. Na rynku akcji GPW od lipca 2009 roku, na rynku CATALYST od sierpnia 2011. Zwycięzca VII edycji Akademii Giełdowej. Makler papierów wartościowych z uprawnieniami do wykonywania czynności doradztwa inwestycyjnego. Obecnie pracuje w firmie doradztwa compliance.

Wykres 1. Struktura terminowa stawek lokat na rynku międzybankowym Chin z 28 czerwca 2013. Opadający kształt krzywej świadczy o chwilowym braku podaży pieniądza krótkoterminowego, a nie o utracie "zaufania" między uczestnikami rynku.

źródło: shibor.org za: cpInvestments.pl

panoramio.com

Makroekonomia22

Kiedy podobny „credit cruch”, czyli nagły wzrost kosztu finansowania wskutek niedoboru płynności na rynku międzybankowym, będący zazwyczaj wynikiem braku zaufania między uczestnikami tego rynku, zdarza się w państwach zachodnich, stanowi to poważne zagrożenia dla ich systemu finansowego. Brak płynności może doprowadzić do szybkiego bankructwa mniejszych banków uzależnionych od finansowania na rynku międzybankowym. Podmioty te operują zwykle na tak wysokim poziomie dźwigni finansowej, że nawet kilkudniowy brak dostępu do rynku może doprowadzić do ich bankructwa. W takim wypadku konieczne jest albo bankructwo, albo dokapitalizowanie banku przez dotychczasowych lub nowych właścicieli. Aby tego uniknąć, bank centralny zwykle „wstrzykuje” do systemu dodatkową płynność w postaci taniej gotówki dla każdego – scenariusz doskonale znany z amerykańskiego kryzysu zaufania po upadku Lehman Brothers we wrześniu 2008 roku. Ogromne rozmiary zachodnich rynków finansowych powodują, że takie działania są kosztowne, a czasem również nieskuteczne (szczególnie gdy kryzys zaufania trwa dłużej niż kilka dni).Warto zauważyć, że żadne z opisanych wyżej ryzyk nie ma szans na materializację w Państwie Środka. Chiński system finansowy jest bowiem diametralnie odmienny od zachodnich odpowiedników i nie powinien być „oceniany według ich norm”. Podział na bank centralny i banki komercyjne w Chinach jest całkowicie fikcyjny (przyjęty wyłącznie w celu porównania systemu chińskiego i zachodniego) z jednego prostego powodu: chiński sektor bankowy jest ściśle kontrolowany przez państwo. To nie bank centralny pełni rolę regulatora w swobodnym, co do zasady, handlu pieniądzem między bankami komercyjnymi. Nie jest też pożyczkodawcą ostatniej instancji, jak banki centralne na Zachodzie. Chiński system finansowy należy traktować raczej jako jedno wielkie przedsiębiorstwo w ramach którego dystrybuowane są środki należące do tego samego właściciela – państwa. Ten prosty i powszechnie przecież znany fakt implikuje kilka równie prostych wniosków. Po pierwsze, na chińskim rynku międzybankowym nie jest możliwy kryzys zaufania (państwo nie może przestać ufać samemu sobie). Po drugie, nie jest możliwe bankructwo żadnego z uczestników „rynku” bez wiedzy i woli państwa, gdyż państwo może zawsze nakazać pożyczenie pieniędzy przez jeden bank drugiemu bankowi

lub po prostu dokapitalizować podmiot mający kłopoty – i może to uczynić z dnia na dzień, nie martwiąc się o procedury demokratyczne czy protesty obywateli (jak w przypadku bailoutu amerykańskiego AIG). Pamiętajmy, że to chińska partia komunistyczna kontroluje, nie tylko banki „komercyjne”, ale i bank centralny, a przez to podaż pieniądza. Li Keqiang może drukować juany znacznie szybciej i znacznie bardziej efektywnie niż Ben Bernanke dolary!Podsumowując, należy stwierdzić, że chiński czerwcowy „credit crunch” nie spowodował wzrostu ryzyka kryzysu w sektorze finansowym w Chinach. Dlaczego twierdzę, że spowodował jego spadek? Źródłem tego ryzyka jest przede wszystkim brak wystarczających informacji o poszczególnych uczestnikach rynku. Po pierwsze, system bankowy w Chinach rozrasta się w tempie geometrycznym i Ludowy Bank Chin po prostu nie jest w stanie analizować, przetwarzać i interpretować wszystkich informacji o nim. Po drugie, chińskie banki, które były zmuszone do finansowania wskazanych przez partię komunistyczną inwestycji, nierzadko całkowicie chybionych, mają bardzo duży portfel złych kredytów, których rozmiary trudno nawet oszacować. Po trzecie wreszcie, dane przekazywane przez banki są zwykle fałszowane. Znamy ten mechanizm z polskiego systemu centralnie sterowanego – papier wszystko przyjmie, normy trzeba wyrabiać, premie dostawać, stanowiska zachowywać. O ryzyku systemowym nikt na niższych szczeblach władzy partyjnej nie myśli. Szeroko znany (zarówno wśród samych Chińczyków jak i analityków z Zachodu) jest fakt fałszowania danych o wzroście PKB przez władze lokalne. Gdyby dodać do siebie raportowane przez poszczególne prowincje dane o wytworzonym produkcie, chiński wzrost PKB byłby znacznie wyższy niż podawany przez Pekin. Podobnie jest z danymi z banków, szczególnie mniejszych operujących w niszach określanych (znów na modłę zachodnią) jako shadow banking. Jak bank centralny może zasypać tą dziurę informacyjną? Na przykład wywołując „credit crunch”. Zachowanie Ludowego Banku Chin przed, w trakcie i po wydarzeniach z czerwca wskazuje jednoznacznie, że stanowiły one kontrolowany eksperyment banku centralnego, który w ten sposób zidentyfikował podmioty narażone na zwiększone ryzyko płynności. Analitycy JP Morgan kilka dni po „credit crunch” przedstawili przekonujące wytłumaczenie jego przyczyn. Wzrost stawek pożyczek międzybankowych

Makroekonomia 23

zbiegł się w czasie z wprowadzeniem przez państwo zakazem fikcyjnych transakcji typu Sell-Buy-Back (S-B-B), wykorzystywanych przez mniejsze, lokalne chińskie banki do finansowania produktów inwestycyjnych typu Wealth Management Products (WMP). Oto jak wygląda ten mechanizm: najpierw bank pozyskuje bazę depozytową oferując WMP charakteryzujące się bardzo atrakcyjnym oprocentowaniem i bliskim terminem zapadalności. Aby sfinansować kosztowny produkt bank kupuje ryzykowne, wysoko rentowne obligacje korporacyjne o znacznie dłuższej zapadalności od WMP. W celu zlikwidowania powstającej w ten sposób luki płynności, bezpośrednio przez zapadalnością WMP bank sprzedawał obligację w ramach transakcji S-B-B innemu „zaprzyjaźnionemu” bankowi, wypłacał należną sumę posiadaczom WMP, sprzedawał nowy produkt tego typu i natychmiast odkupował rentowną i ryzykowną obligację. Po wprowadzeniu zakazu tego typu praktyk, banki,

które najsilniej angażowały się w ryzykowne produkty typu WMP, znalazły się pod wysoką presją płynnościową i musiały akceptować rosnące stawki pożyczek międzybankowych. Ludowy Bank Chin ma więc dobre informacje na temat podmiotów, w których koncentruje się ryzyko systemowe związane z WMP. Całą operację można rozumieć jako przeprowadzenie stress testów, podobnie jak czyni się to na Zachodzie, jednak nie w Excelu, lecz w praktyce. Stawki na rynku międzybankowym wróciły zaś do normy – w chwili pisania tego artykułu stopa overnight wynosiła 3%, a stopa tygodniowa 3,5%. Struktura terminowa również wróciła do normalności – krzywa dochodowości uwzględnia koszt płynności i jest rosnąca. Dwa miesiące po „credit crunch”, które wzbudziło przerażenie wśród zachodnich inwestorów, chiński rynek międzybankowy działa normalnie i płynnie, a bank centralny zdobył całą masę cennych informacji o uczestnikach tego rynku, jego głębokości i drożności.

Wykres 2. Uproszczony schemat finansowania tzw. Wealth Management Products przez banki chińskie.

źródło: Reuters za: zerohedge.com

Prawo24

REKLAMACJA BEZ PARAGONU

„Jeżeli towar konsumpcyjny jest niezgodny z umową, kupujący może żądać doprowadzenia go do stanu zgodnego z umową przez nieodpłatną naprawę albo wymianę na nowy, chyba że naprawa albo wymiana są niemożliwe lub wymagają nadmiernych kosztów.” Tak stanowi § 8 Ustawy z dnia 27 lipca 2002 r. o szczególnych warunkach sprzedaży konsumenckiej oraz o zmianie Kodeksu cywilnego (Dz. U. z dnia 5 września 2002 r.)Co jednak zrobić, gdy sprzedawca żąda od nas dowodu zakupu w formie paragonu?Zwrot towaru bez dokumentu fiskalnego sprzedawcy w Polsce nadal jest mało rozpowszechniony. Część z nas nie zabiera ich ze sklepu, inni gubią je w natłoku dokumentów, a ci, którzy je sumiennie przechowują najczęściej spotykają się z sytuacją, że po kilku miesiącach są całkowicie wypłowiałe i nieczytelne. Znane większości stwierdzenie „podstawą reklamacji jest paragon” zniechęca klientów do walczenia o swoje prawa. Warto jednak zauważyć, że stanowisko sprzedawców nie ma żadnego poparcia w przepisach prawa. Co więcej stwierdzenia „Do reklamowanego lub zwracanego produktu konieczne jest dołączenie paragonu” czy też „Podstawą przyjęcia reklamacji jest dowód

zakupu towaru (paragon fiskalny lub faktura)” zostały zawarte w rejestrze klauzul niedozwolonych prowadzonym przez Prezesa UOKiK. Na przedsiębiorcę posługującego się ww. stwierdzeniami może zostać nałożona kara pieniężna w kwocie do 10 % przychodu osiągniętego w roku poprzedzającym datę nałożenia na niego kary. Udając się z reklamacją musimy jedynie udowodnić fakt daty nabycia oraz miejsca zakupu przedmiotu. Potwierdzeniami zakupu są nie tylko paragony i faktury. Mogą nimi być wyciągi bankowe, umowy, wyciągi z kart płatniczych czy też kredytowych, a także oświadczenia: zarówno kupującego, jak i świadków będących z nami podczas zakupów. Wiele przedsiębiorstw odnotowuje sprzedaż za pomocą dodatkowych systemów

komputerowych. Często można spotkać się również z sytuacją, gdy przedsiębiorstwa przechowują nagrania z kamer monitorujących obiekt. Sprzedawca znając konkretną datę i godzinę – w ramach dobrej woli i w razie wątpliwości co do sprzedaży w jego przedsiębiorstwie towaru – może odnaleźć na rolkach kasowych kopię zagubionego przez nas paragonu. Wszystkie powyższe sytuacje mogą pomóc w udowodnieniu czasu oraz miejsca zakupu trefnego towaru.Sytuacja udowodnienia zakupu sprzedawcy wydaje się być jeszcze prostsza w przypadku zakupów internetowych. W takim przypadku warto posłużyć się: potwierdzeniem zamówienia towaru, korespondencją ze sprzedawcą, czy też przedstawieniem listu przewozowego. Każda z powyższych dokumentacji

weaponsman.com

Prawo 25

może wspomóc nasze starania o uznanie naszej reklamacji.Jeśli sklep nadal będzie kwestionował nasze prawa należy udać się z zaistniałą sytuacją do powiatowego lub odpowiednio miejskiego rzecznika konsumentów.Należy jednak pamiętać o drugiej stronie medalu. Sprzedawca, który udzielił nam reklamacji, musi fakt ten udokumentować na gruncie podatkowym. Ciężar jej uzasadnienia znajduje się po stronie przedsiębiorcy, który w prowadzonej przez siebie księgowości powinien posiadać dowody potwierdzające stan rzeczywisty. Takimi też dokumentami musiałby się okazać w przypadku kontroli skarbowej.W interpretacji indywidualnej, nr IBPP2/443-121/08/ICz z 12 maja 2008 r., dyrektor Izby Skarbowej w Katowicach stwierdził jednak, iż „zgromadzenie przez przedsiębiorcę dowodów (...) stanowiących dowód przeciwny do dowodu, jakim jest zapis z kasy

rejestrującej, przy uwzględnieniu wyjątkowego charakteru zdarzeń, może stanowić podstawę do skorygowania obrotu i kwot podatku należnego (...)”.Wydawane przez sprzedawców paragony są nietrwałe. Ich całkowita nieczytelność następuje średnio po 7-8 miesiącach. Znane większości są legendarne i zarazem śmieszne formy wydłużania ich przydatności (przetrzymywanie zafoliowanych w lodówce, obklejanie taśmą bezbarwną, czy

też prasowanie już nieczytelnego dokumentu, które powoduje efekt negatywu).Jeżeli chcemy ułatwić zarówno sobie jak i sprzedawcy życie, niezwłocznie po otrzymaniu towaru – kserujmy paragon, lub prośmy sprzedawcę o wystawienie faktury (mamy do tego prawo w ciągu 7 dniu) czy też w przypadku przedsiębiorcy niebędącego czynnym podatnikiem podatku VAT – rachunku (możemy się ubiegać o jego wystawienie w ciągu 3 miesięcy).

EWA KOŚLACZ

Studentka Szkoły Głównej Handlowej. Absolwentka i stypendystka rektora UW na kierunku Finanse i Rachunkowość. Specjalista d.s. księgowości w biurze rachunkowym ProPIT. Autorka publikacji podatkowych oraz ubezpieczeniowych w dzienniku Rzeczpospolita.

info.milestoneadvisors.net

To Zależy26

Ministrowie finansów w każdym kraju na świecie są poddawani nieustannej krytyce przez obywateli, ekonomistów i opozycję. Są „winni” wysokich podatków, deficytu budżetowego, zbyt małych wydatków, zmian w systemach emerytalnych bądź ich braku, a czasem nawet wini się ich za zbyt dobrą koniunkturę. Nie inaczej jest w Polsce. Przez ostatnich kilka miesięcy minister Rostowski jest krytykowany za każdą z wyżej wymienionych sytuacji. Ale czy to zasłużona krytyka, czy tylko opozycyjna paplanina? Mateusz Niewiński

Minister Finansów Jacek Rostowski – dobry czy zły?

W tym numerze Rubryka “To Zależy” była jeszcze trudniejsza do zredagowania niż kiedykolwiek wcześniej. O ile w poprzednich pozycjach oceniane były zjawiska i przedsięwzięcia ekonomiczne, o tyle obecnie na warsztat poszła ocena osoby publicznej. I to jakiej – Minister Finansów Jacek Rostowski wyzwala w ostatnim czasie emocje u wszystkich ekonomistów zaangażowanych w dyskusje publiczną. Warto zwrócić również uwagę, iż w tejże dyskusji sami ekonomiści są niezwykle podzieleni. Wydawać by się też mogło, iż tak fundamentalne kwestie jak kierunek(!) reformy emerytalnej czy też sama polityka budżetowa, nie powinny być powodem do gorących, kilkumiesięcznych sporów, jednak jak rzeczywistość pokazała, w ostatnim czasie byliśmy świadkami niezwykłej polaryzacji środowiska ekonomicznego.

W takim razie jak to jest - czy Jacek Rostowski jest dobrym ministrem czy też nie? Dwa przeciwne stanowiska zajmują nasi redaktorzy, i obaj przedstawiają solidne argumenty w poruszanym obszarze. Zapraszamy do lektury!

Nie taki Minister straszny jak go malują

Jak sprawdzić, czy minister finansów w Polsce działa skutecznie? Można przytoczyć nagłówki z gazet, które udowodnią nam, że obecny wicepremier jest najgorszym ministrem wszechczasów. Ja wolę sprawdzić, jak minister i jego podwładni realizują cele postawione im przez prawo. Tak, przez prawo, a nie przez program partii. Nie interesują nas przecież cele polityczne, te minister wypełnia doskonale.

W Polsce zadania ministra finansów reguluje wiele aktów prawnych, m.in. Konstytucja RP, „Ustawa o Radzie Ministrów”, „Ustawa o działach administracji rządowej”, dwa zarządzenia i jedno rozporządzenie Prezesa Rady Ministrów1. Najpełniejsze wyjaśnienie znajdziemy w artykule 7., 8. i 12. z „Ustawy o działach...”, które mówią, że podstawowymi zadaniami ministra finansów są:

− opracowanie i wykonanie budżetu państwa,1 Na podstawie http://www.mf.gov.pl/ministerstwo-finansow/minister-finansow/zadania-ministra-finansow

− zarządzanie systemem finansowania sektora publicznego,

− zarządzanie długiem publicznym,

− realizowanie przychodów i wydatków budżetu państwa,

− inne zadania dotyczące przepisów celnych, gier losowych, rachunkowości, prawa dewizowego, kontroli skarbowej i funkcjonowania rynku finansowego w Polsce.

Z wymienionych wyżej zadań minister zdaje sprawozdanie, szczególnie dotyczące wykonania budżetu państwa, które musi zostać przyjęte przez Sejm. Nawet jeśli obowiązuje dyscyplina partyjna, to w przypadku rażących nieprawidłowości, Sejm nie przyjmie sprawozdania z wykonania budżetu.

Pojawiają się i inne zarzuty, m.in. o błędne założenia (a dokładniej prognozy) przyjęte w ustawach

To Zależy 27

budżetowych na dany rok. Przypomnę tylko, że sam minister nie liczy wzrostu PKB w Excelu (ani na wielkim kalkulatorze), a robią to ekonomiści zatrudnieni w ministerstwie. I jak każda prognoza, te ministerialne także są obarczone błędem. Nie można wymagać od ministra bezbłędności, a jedynie racjonalności. Tę cechę Jacek Rostowski niewątpliwie posiada. Poprawki budżetu w czasach recesji są częste, a te ostatnie wydają się bardziej przemyślane, niż uważają ich krytycy – mogą poprawić sytuację budżetu w 2014 roku.

Kolejnym zarzutem jest oskarżenie wicepremiera o próbę demontażu systemu emerytalnego. Fakty są takie, że ministerstwo przygotowało raport, minister go przedstawił i zaproponował różne opcje. Nie wszystkie możliwe, ale większość z nich. Nadal są to tylko propozycje, choć w fazie zaawansowanej. Co więcej, gdyby się nie pojawiły, można by uznać zachowanie ministra za niekompetentne! Wszystkim krytykom przypominam, że to nie minister zdecyduje o przyszłości systemu emerytalnego w Polsce, ale parlament i prezydent (ma prawo weta) rozważą propozycje rządu (wcześniej musi je zaakceptować premier). Choć nie każda wypowiedź ministra w tym temacie jest fortunna, to trzeba pamiętać, że jest on politykiem i musi wkomponować się w linię polityczną partii rządzącej.

Także wzrost gospodarczy jest silnie powiązany z wypowiedziami o ministrze finansów. Zwykle jemu przypisuje się winę za złą koniunkturę, lecz w czasach prosperity zapomina się o nim. Jednak przecież zawsze może powiedzieć, że „nie przeszkadzał swoimi

działaniami” w fazie wzrostowej cyklu gospodarczego. Niestety, albo na szczęście, cykl koniunkturalny nie jest zależny od ministra finansów. Może on jedynie podjąć działania stymulacyjne, stosując odpowiednią politykę fiskalną. Jednak warto zauważyć, że w zakresie oficjalnych obowiązków nie zostało ujęte dbanie o wzrost gospodarczy. Jest to zadanie bardziej odpowiednie dla ministra gospodarki, choć to ministra finansów wyposażono w narzędzia umożliwiające jego wykonanie. Oczywiście, minister finansów „to robi”, lecz zawsze przed tym zadaniem priorytet będą miały zadania ustawowe. Te „niedopatrzenie” prawne zmienia nieco rolę ministra finansów, czego krytycy nie zauważają.

Wreszcie najpoważniejszy zarzut – nadmierne zadłużanie państwa. Mało kto pamięta o tym, że minister ma niewielki realny wpływ na wydatki i przychody budżetu państwa. Mniej więcej trzy czwarte wydatków to wydatki prawnie zdeterminowane (tzw. wydatki sztywne)2, których zmiana wymaga zmian odpowiednich ustaw, do czego nie zawsze znajdzie się poparcie polityczne. Poza tym, minister może tylko stanowczo poprosić swoich kolegów z innych resortów, aby ograniczyli wydatki, lecz nie zawsze osiągnie kwoty, jakich potrzebuje. Także strona przychodowa nie jest pod pełną kontrolą ministra finansów – nie zmusi on Polaków, aby poszli do sklepów, zrobili zakupy i zwiększyli wpływy z podatków pośrednich (największa pozycja przychodów budżetu). Może on 2 Na podstawie http://orka2.sejm.gov.pl/BASleksykon.nsf/dokument.xsp?id=856882A0D5E71D55C1257A5C0045B693&SessionID=DAYOMRDVIK

To Zależy28

Zdaje się, że jako pierwszy Rostowskiego przejrzał jego były zastępca, prof. Stanisław Gomułka, który

z bycia wiceministrem zrezygnował w 2008 roku zaledwie po trzech miesiącach wspólnej pracy. Dlaczego? „Dziennikowi” zwierzał się, że czuł brak poparcia politycznego dla swoich działań reformatorskich. To powinien być sygnał ostrzegawczy, że szumnie zapowiadane reformy w dziedzinie finansów publicznych okażą się

tylko przysłowiową dużą chmurą. Nie był.

Rację ma Leszek Balcerowicz mówiący o „fałszerstwie intelektualnym” Rostowskiego,

w kontekście demontażu filara kapitałowego w systemie zabezpieczenia emerytalnego. To fałszerstwo dotyka wielu płaszczyzn. Po pierwsze, minister bez mrugnięcia okiem

dowodzi, że stopy zwrotu w ZUS-ie są wyższe niż w OFE, zupełnie ignorując fakt, że ZUS jest

jedynie projekcją politycznych pobożnych życzeń, a nie skarbcem z pieniędzmi. Po

drugie, krytykuje rentowność OFE, doskonale wiedząc

Gdy w 2007 roku Jacek Rostowski zostawał ministrem finansów, rynki odetchnęły z ulgą. Był przedstawiany przez media jako profesor i wybitny ekonomista. Koledzy po fachu

wypowiadali się o nim w samych superlatywach.

Dziś minister kompromituje się na każdym polu. Jego dawni poplecznicy mogą tylko czerwienić się z zażenowania słysząc wypowiedzi, które po prostu nie przystoją

osobie z wykształceniem ekonomicznym. Nawet magistrowi, którym minister jest, choć prasa i inni politycy często z rozpędu

tytułują go profesorem. Marcin Senderski

podnieść stawki podatku lub wprowadzić nowe, lecz może to zmniejszyć wpływy do budżetu (odsyłam do teorii Laffera). Jedyną opcją pozostaje więc zadłużenie, które w racjonalnej wielkości i otrzymane od krajowych wierzycieli, nie jest bardzo szkodliwe.

Na problem zarządzania finansami publicznymi trzeba też spojrzeć z punktu widzenia samego ministra. Musi on przede wszystkim spełnić wymagania swojego bezpośredniego zwierzchnika, czyli premiera. To premier powołuje go na stanowisko i dopóki nie będzie miał on powodów do odwołania (np. zaniedbanie obowiązków ustawowych), pozycja ministra finansów będzie silna. Minister nie tworzy samodzielnie polityki państwa, więc nawet jeśli ma pomysły dotyczące reform gospodarczych, to musi się liczyć ze zdaniem koalicyjnych kolegów.

Wicepremier Jacek Rostowski jest ministrem finansów najdłużej piastującym ten urząd. Ponowny wybór (na drugą kadencję) oraz nagrody uznanego

serwisu „Emerging Markets3” – „minister finansów roku” – stanowią dobrą rekomendację dla naczelnika polskich finansów. Pan wicepremier nie jest ministrem idealnym, wszak odrobina krytyki jeszcze nikomu nie zaszkodziła, lecz większość zarzutów jest sformułowanych bez zrozumienia sytuacji, a także po prostu źle zaadresowanych. Warto o tym pamiętać, krytykując każdego z urzędujących ministrów, bez względu na opcję polityczną...

3 http://www.bankier.pl/wiadomosc/ Jacek-Rostowski-najlepszym-ministrem- finansow-2012-roku-2656553.html

Gdziekolwiek jesteś, Panie Ministrze

To Zależy 29

jednak, ż e

ich portfel inwestycyjny jest mało

urozmaicony, a możliwości dywersyfikacji niewielkie, w praktyce

ograniczone do dychotomii akcje vs. obligacje. Tym samym, trzeci podnoszony zarzut, jakoby

OFE w złej wierze skupowały dług generowany przez państwo, jest bezpodstawny, bo de facto fundusze nie mają innej alternatywy.

Popularny stał się również pogląd przypisujący OFE sprawstwo bardzo wysokiego długu publicznego w Polsce. „Nie ma żadnej wątpliwości, że stworzenie filara kapitałowego znacznie zwiększyło dług publiczny” – powiedział Rostowski na konferencji prasowej 26 czerwca. Rzekome wytłumaczenie? Gdyby część naszych składek nie płynęła do prywatnych funduszy, rząd nie musiałby drukować obligacji. To również niedorzeczność, bo każdy, kto śledzi poczynania rządów wie, że są to instytucje będące w stanie zaabsorbować i przejeść każde pieniądze. Nawet gdyby część składki emerytalnej, obecnie przekazywanej sektorowi prywatnemu, trafiała do ZUS-u, nie powstrzymałoby to rządu przed parciem do jeszcze większego zadłużenia. Ostatnio okazało się, że nawet dość mocno umocowany w polskim prawodawstwie 50-proc. próg ostrożnościowy (tj. relacja długu publicznego do PKB) to żadna przeszkoda dla nienasyconego rządowego apetytu.

Minister Rostowski żeruje na niewiedzy społeczeństwa. Owszem, świadomość zawiłości ekonomicznych jest dziś dużo większa niż przed wybuchem kryzysu gospodarczego. Słowa takie jak spread, konsolidacja fiskalna czy wzrost gospodarczy nie są już czarną magią dla gospodarczego „laikatu”. Wielu pojęło nawet różnicę między procentem a punktem procentowym. Jednak sprawa OFE jest złożona i właściwy osąd wymaga również znajomości kontekstu, a tego od Polaków trudno wymagać. Minister rozgrywa prymitywne instynkty społeczeństwa, z reguły wrogo nastawionego do świata wielkiej finansjery. Przeciętny obywatel nie powinien mieć jednak żadnych podstaw, by bardziej ufać państwu niż rynkowi.

Rostowski krytykuje reformę emerytalną rządu Jerzego Buzka, która miała swoje niedociągnięcia, ale którą kolejne gabinety pozostawiały nietkniętą niczym trędowatego. On sam też przez kilka lat nie robił nic w celu obniżenia prowizji pobieranych przez OFE czy zliberalizowania możliwości inwestycyjnych funduszy. Ministrowi nie przeszkadza to jednak w wyrażaniu dosadnej krytyki funkcjonowania II filara.

Schizofrenia tej sytuacji polega na tym,

że minister krytykuje samego siebie. Tymczasem, nie ma żadnego

pola do krytyki OFE, gdyż fundusze reagują wyłącznie na bodźce jakich dostarcza im regulator.

Maksymalizują swój zysk w sposób często niemoralny, bo mogą to robić – i to jest ekonomiczny sens, jaki można by nadać popularnym prawom Murphy’ego.