Sieci Neuronowe w Ujeciu Algorytmicznym Stanisław Osowski

-

Upload

izabela-figura -

Category

Documents

-

view

2.568 -

download

15

Transcript of Sieci Neuronowe w Ujeciu Algorytmicznym Stanisław Osowski

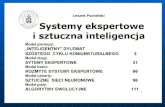

Spis tre�ci

Przedmowa..............................................................................................................................................................4 1. Wprowadzenie w tematyk� sieci neuronowych ..............................................................................................6

1.1. Wst� p............................................................................................................................................................6 1.2. Podstawowe architektury sieci neuronowych...............................................................................................7 1.3. Przegl � d podstawowych metod uczenia sieci ...............................................................................................9 1.4. Zdolno

�ci uogólniania sieci neuronowej ....................................................................................................16

2. Sieci neuronowe jednokierunkowe wielowarstwowe....................................................................................20 2.1. Podstawowe zale� no

�ci odnosz� ce si � do neuronu ....................................................................................20

2.2. Podstawowe definicje funkcji celu.............................................................................................................21 2.3. Algorytm propagacji wstecznej w postaci klasycznej ................................................................................24 2.4. Wyznaczanie gradientu metod� grafów przepływowych ...........................................................................27 2.5. Algorytmy gradientowe optymalizacji w zastosowaniu do uczenia sieci...................................................31 2.6. Metody doboru współczynnika uczenia.....................................................................................................37 2.7. Metoda gradientów sprz��� onych z regularyzacj � .......................................................................................42 2.8. Algorytmy heurystyczne ............................................................................................................................44 2.9. Porównanie efektywno

�ci algorytmów ucz� cych.......................................................................................46

2.10. Elementy optymalizacji globalnej ............................................................................................................47 2.11. Metody inicjalizacji wag ..........................................................................................................................50

3. Dobór optymalnej architektury sieci wielowarstwowej i danych ucz� cych..................................................59 3.1. Zdolno

�ci uogólniania sieci wielowarstwowej ...........................................................................................60

3.2. Metody redukcji sieci .................................................................................................................................62 3.3. Algorytm kaskadowej korelacji Fahlmana.................................................................................................71 3.4. Sie� neuronowa z rozszerzeniem funkcyjnym............................................................................................75 3.5. Analiza wra� liwo

�ciowa danych ucz� cych.................................................................................................80

3.6. Zwi � kszanie zdolno�ci uogólniania sieci przez wtr� canie szumu do wzorców ucz� cych..........................82

4. Wybrane zastosowania sieci neuronowych wielowarstwowych .........................................................85 4.1. Rozpoznawanie wzorców........................................................................................................................85 4.2. Kompresja danych ...................................................................................................................................88 4.3. Sie� neuronowa interpoluj � ca...................................................................................................................93 4.4. Modelowanie i sterowanie obiektów dynamicznych...........................................................................95 4.5. Predykcja obci � e� systemu elektroenergetycznego ....................................................................100

5. Sieci neuronowe o radialnych funkcjach bazowych .........................................................................103 5.1. Podstawy matematyczne......................................................................................................................103 5.2. Sie� neuronowa radialna........................................................................................................................107 5.3. Metody uczenia sieci neuronowych radialnych...............................................................................110 5.4. Porównanie sieci radialnych z sieciami sigmoidalnymi....................................................................122

6. Sieci rekurencyjne.......................................................................................................................................124 6.1. Wprowadzenie..........................................................................................................................................124 6.2. Sie� autoasocjacyjna Hopfielda................................................................................................................125 6.3. Sie� Hamminga........................................................................................................................................133 6.4. Sie� typu BAM .........................................................................................................................................136 6.5. Rekurencyjna sie� neuronowa typu RTRN ..............................................................................................142 6.6. Rekurencyjna sie� Elmana........................................................................................................................145 6.7. Rekurencyjna metoda propagacji wstecznej .............................................................................................149

7. Sieci samoorganizuj � ce si � na podstawie reguły Hebba .............................................................................152 7.1. Aspekt energetyczny samoorganizacji Hebba..........................................................................................152 7.2. Analiza składników głównych (PCA) ......................................................................................................153 7.3. Sieci neuronowe typu Heraulta-Juttena....................................................................................................156

8. Sieci samoorganizuj � ce si � działaj � ce na zasadzie współzawodnictwa......................................................168 8.1. Zale� no

�ci podstawowe............................................................................................................................168

8.2. Algorytmy uczenia sieci samoorganizuj � cych si � ....................................................................................173 8.3. Sie� odwzorowa jedno- i dwuwymiarowych..........................................................................................177 8.4. Odwzorowanie Sammona.........................................................................................................................180 8.5. Przykłady zastosowa sieci samoorganizuj � cych si � ...............................................................................181

9. Podstawy matematyczne systemów logiki rozmytej ...................................................................................187 9.1. Podstawowe poj � cia systemów rozmytych ..............................................................................................187 9.2. Zasady wnioskowania w zbiorach rozmytych..........................................................................................189 9.3. Interpretacja reguł wnioskowania w systemie wielowymiarowym..........................................................190 9.4. Układy logiki rozmytej w

�rodowisku pomiarowym ...............................................................................191

10. Sieci neuronowe o logice rozmytej ............................................................................................................197 10.1. Gradientowa metoda uczenia sieci rozmytej ..........................................................................................197 10.2. Uczenie samoorganizuj � ce si � sieci rozmytych......................................................................................205

10.3. Uczenie bezpo�rednie na podstawie tabeli przej

� � .................................................................................207 11. Implementacja sieci neuronowych w technologii VLSI ..........................................................................211

11.1. Elementy rozwi � za analogowych sieci neuronowych ..........................................................................211 11.2. Przegl � d komercyjnych układów scalonych...........................................................................................219

Dodatek A - Opis programu Netteach................................................................................................................225 A.1. Przygotowanie plików z danymi .............................................................................................................225 A.2. Opcje wywołania programu.....................................................................................................................226

Dodatek B - Opis programu Cascor ....................................................................................................................227 B.1. Opis parametrów wywołania programu...................................................................................................227 B.2. Przygotowanie plików ucz� cych..............................................................................................................228

Dodatek C - Opis programu Hfnet ......................................................................................................................229 Bibliografia..........................................................................................................................................................230

Przedmowa Sztuczne sieci neuronowe, zwane w skrócie sieciami neuronowymi, stanowi intensywnie rozwijaj � cy si �

dziedzin� wiedzy stosowani w wielu obszarach nauki. Maje wła�ciwo

�ci po� � dane w wielu zastosowaniach

praktycznych: stanowi uniwersalny układ aproksymacyjny odwzorowuj � cy wielowymiarowe zbiory danych, maj � zdolno

� � uczenia si � i adaptacji do zmieniaj � cych si � warunków �rodowiskowych, zdolno

� � uogólniania nabytej wiedzy, stanowi � c pod tym wzgl � dem system sztucznej inteligencji. Podstawi działania sieci s� algorytmy ucz� ce, umo� liwiaj � ce zaprojektowanie odpowiedniej struktury sieci i dobór parametrów tej struktury, dopasowanych do problemu podlegaj � cego rozwi � zaniu. W ksi ��� ce przedstawiono sieci neuronowe z punktu widzenia algorytmicznego, najbardziej u� ytecznego praktycznie. Jest to wyselekcjonowany przegl � d najlepszych metod uczenia sieci o ró� norodnej strukturze, zilustrowany wynikami wielu eksperymentów numerycznych i poparty zastosowaniami praktycznymi.

W rozdziale 1 jest przedstawiony krótki przegl � d podstawowych rodzajów i stowarzyszonych z nimi metod uczenia sieci, b� d� cy wprowadzeniem w tematyk� sieci neuronowych. Podano w nim najwa� niejsze definicje i zale� no

�ci odnosz� ce si � do wszystkich rodzajów sieci.

Rozdział 2 dotyczy sieci jednokierunkowych wielowarstwowych o sigmoidalnej funkcji aktywacji. Przedstawiono w nim wybrane, najefektywniejsze algorytmy uczenia tych sieci z zastosowaniem strategii propagacji wstecznej, zinterpretowanej za pomoc� grafów doł � czonych przepływu sygnałów. Szczegółowe rozwa� ania dotycz� równie� metod inicjalizacji warto

�ci wst� pnych wag, umo� liwiaj � cych znaczne

przyspieszenie procesu uczenia i unikni � cie pułapki minimów lokalnych. Rozdział 3 jest po

�wi � cony algorytmom doboru optymalnej architektury sieci wielowarstwowych, opartym

na metodach redukcji i rozszerzania sieci. W szczególno�ci du� o miejsca po

�wi � cono sieciom kaskadowej

korelacji Fahlmana oraz sieciom z rozszerzeniem funkcyjnym. Dwa ostatnie punkty rozdziału dotycz� doboru danych ucz� cych poprawiaj � cych zdolno

�ci uogólniaj � ce sieci neuronowych.

W rozdziale 4 omówiono wybrane zastosowania sieci neuronowych wielowarstwowych. Przedstawiono problematyk� rozpoznawania wzorców, kompresji danych, interpolacji z u� yciem sieci neuronowej, modelowania i sterowania obiektów dynamicznych oraz predykcj � obci ��� e systemu elektroenergetycznego.

Rozdział 5 dotyczy sieci o radialnych funkcjach bazowych. Po wprowadzeniu podstaw matematycznych omówiono podstawowe struktury sieci radialnych oraz algorytmy ucz� ce, wykorzystuj � ce zarówno metody gradientowe, jak i współzawodnictwo mi � dzy neuronami.

W rozdziale 6 zawarto podstawowe wiadomo�ci o sieciach rekurencyjnych. Wprowadzono struktury

i metody uczenia sieci Hopfielda, Hamminga, BAM, RTRN oraz sieci Elmana. Przedstawiono typowe zastosowania tych sieci.

Rozdział 7 jest po�wi � cony sieciom samoorganizuj � cym si � , w których uczenie jest oparte na uogólnionej

regule Hebba. Przedstawiono praktyczne zastosowania takich sieci do analizy składników głównych (PCA) oraz rozdzielania sygnałów (sieci Heraulta-Juttena).

W rozdziale 8 przedstawiono zagadnienia dotycz� ce algorytmów ucz� cych i zastosowa sieci samoorganizuj � cych si � w oparciu o współzawodnictwo neuronów. Dokonano porównania najskuteczniejszych metod uczenia oraz przedstawiono przykłady praktycznych zastosowa sieci tego typu.

W rozdziałach 9 i 10 omówiono tematyk� sieci neuronowych o logice rozmytej, stanowi � cych uogólnienie klasycznych sieci neuronowych. Po wprowadzeniu podstaw matematycznych przedstawiono podstawowi struktur� sieci oraz metody uczenia oparte na zastosowaniu metod gradientowych, mechanizmu klasteryzacji i tabeli przej

� � . Rozdział 11 stanowi przegl � d implementacji układów scalonych VLSI podstawowych wybranych struktur

sieci neuronowych. Przedstawiono przykładowe rozwi � zania elementów sieci oraz przegl � d komercyjnych opracowa sieci w postaci koprocesorów oraz neurokomputerów cyfrowych i analogowych.

Ksi ��� ka zawiera tak� e 3 dodatki po�wi � cone krótkiemu wprowadzeniu w wybrane programy uczenia sieci

neuronowych. Jest przeznaczona dla studentów wy� szych lat studiów oraz doktorantów zainteresowanych tematyk �

sztucznych sieci neuronowych. Ze wzgl � du na interdyscyplinarny charakter tematyki mo� e by� u� yteczna zarówno w technice, informatyce, fizyce, jak i w naukach biomedycznych. Stanowi fundament wiedzy o sieciach neuronowych zarówno dla pocz� tkuj � cych, jak i dla zaawansowanych w uprawianiu tej dyscypliny.

W zako czeniu przedmowy pragn� podzi � kowa� osobom i instytucjom, których wpływ na ostateczny kształt ksi ��� ki jest najwi � kszy. W szczególno

�ci dzi � kuj � recenzentowi ksi � � ki drowi in� . S. Jankowskiemu za

krytyczne uwagi i poprawki, których uwzgl � dnienie udoskonaliło ostateczn� wersji ksi ��� ki.

Prof. A. Cichockiemu i drowi L. Moszczy skiemu z Politechniki Warszawskiej serdecznie dzi � kuj � za udost� pnienie mi programu bs do

�lepego rozdzielania sygnałów, drowi P. Demartinesowi z INPG Grenoble

(Francja) za mo� liwo� � skorzystania z programu soma i drowi S. Fahlmanowi z Carnegie Mellon University

(USA) za prawo do korzystania z programu cascor. Szczególnie gor� co dzi � kuj � mojej

�onie i Rodzinie za wyrozumiało

� � i nieustanni pomoc okazywani mi w trakcie przygotowywania ksi � � ki, w tym za wysiłek wło� ony w przygotowanie maszynopisu pracy.

Ksi ��� k� napisałem podczas pobytu na Uniwersytecie Erlangen-Norymberga w Institut fur Elektrische Energieversorgung, w charakterze stypendysty programu TEMPUS (projekt JEP nr 07237-94). Chciałbym serdecznie podzi � kowa� prof. T. Łobosowi z Politechniki Wrocławskiej, koordynatorowi projektu, za umo� liwienie tego pobytu, a prof. G. Heroldowi, dyrektorowi Institut fur Elektrische Energieversorgung, oraz jego współpracownikom za okazani mi go

�cinno

� � . Na ostateczny kształt ksi � � ki du� y wpływ miała moja współpraca z Laboratorium Brain Information

Processing Research, Frontier Research Program (RIKEN), Japonia, kierowanym przez prof. Shin-ichi Amari, za co chciałbym zło� y� kierownikowi tej instytucji serdeczne podzi � kowanie.

Chciałbym gor� co podzi � kowa� instytucjom wydawniczym oraz autorom za prawo skorzystania z ich rysunków. W szczególno

�ci dzi � kuj � IEE Publishing Department, Stevenage Herts (Wielka Brytania) oraz

autorom pracy 137] za prawo do skorzystania z rys. 5.7, Wydawnictwu Complex Systems oraz autorom pracy [26] za rys. ti.4 i 8.5, drowi P. Demartinesowi za rys. 8.2, 8.3, 8.9, 8.11, drowi S. Fahlmanowi za rys. 3.6, 3.7, 3.8 oraz 6.14, prof. Y. Le Cunowi, J. S. Denkerowi, S. A. Solli (AT&T Bell Holmdel) za rys. 3.4, prof. B. Hassibiemu (Stanford University, USA), D. Storkowi (Ricoh California Research Center, USA) za rys. 3.5, Wydawnictwu Operations Research oraz autorom pracy [57] za rys. 2.11 i 2.12, Wydawnictwu American Association for the Advancement of Sciences (AAAS), Washington oraz autorom pracy (51] za rys. 6.1, Wydawnictwu Simon & Schuster oraz prof. S. Haykinowi, autorom ksi ��� ki (41], za rys. 1.5, Wydawnictwu Addison Wesley oraz prof. A. Zellowi, autorowi ksi ��� ki ~158~, za rys. 11.12, 11.13, 11.14 oraz 11.15, IEEE Publishing Department oraz autorom prac [87, 145, 84, 126, 76, 2, 43, 156] za rys. 3.17, 6.4, 6.10, 8.6, 8.7, 8.13, 11.1, 11.2, 11.3, 11.4, 11.5, 11.6, 11.7, 11.8, 11.9 oraz 11.10.

Warszawa w lutym 1996 r.

1. Wprowadzenie w tematyk sieci neuronowych

1.1. Wst p Badania systemów nerwowych istot � ywych sad i nadal stanowi � istotny czynnik post� pu w dziedzinie teorii systemów i ich zastosowa w praktyce. Ju� w 1943 r. McCulloch i Pitts [88] opracowali model komórki nerwowej, którego idea przetrwała lata i stanowi do dzisiaj podstawowe ogniwo wi � kszo

�ci u� ywanych modeli.

Istotnym elementem tego modelu jest sumowanie sygnałów wej�ciowych z odpowiedni � wagi i poddanie

otrzymanej sumy działaniu nieliniowej funkcji aktywacji. W efekcie sygnał wyj�ciowy neuronu yi jest

okre�lony w postaci

���

����

�= �

=

N

jjiji xWfy

1

(1. 1)

przy czym xj (j = 1, 2, … , N) reprezentuje sygnały wej�ciowe, a Wij - odpowiednie współczynniki wagowe,

zwane wagami synaptycznymi lub w skrócie wagami. Przy dodatniej warto�ci waga przekazuje sygnał

pobudzaj � cy, przy ujemnej - gasz� cy. Funkcja aktywacji f () mo� e mie� ró� ni posta� ; w modelu pierwotnym McCullocha-Pittsa jest to funkcja typu skoku jednostkowego.

W kilka lat pó� niej Hebb zaprezentował teori � uczenia (doboru wag Wij neuronów) w zastosowaniu do pami � ci asocjacyjnych. Wykorzystał przy tym obserwacje, � e waga poł � cze mi � dzyneuronowych jest wzmacniana przy stanach uaktywnienia neuronów. W modelu Hebba przyrost wagi ∆Wij w procesie uczenia jest proporcjonalny do iloczynu sygnałów wyj

�ciowych neuronów poł � czonych wagi Wij

( ) ( ) ( ) ( )kykykWkW jjijij η+=+1 (1. 2)

w którym k oznacza kolejny cykl, a η jest współczynnikiem uczenia. Na pocz� tku lat sze� � dziesi � tych Widrow

[149] opracował podstawy teoretyczne i podstawowe implementacje techniczne adaptacyjnych układów przetwarzaj � cych, stanowi � ce istotny wkład w rozwój sieci neuronowych.

W 1962 r. została opublikowana ksi � � ka Rosenblatta [124] prezentuj � ca teori � dynamicznych systemów neuronowych modeluj � cych mózg, oparu na modelu perceptronowym komórki nerwowej. W modelu tym przyjmuje si � opis neuronu w postaci (1.1), w którym funkcja aktywacji przyjmuje dwie warto

�ci binarne:

1 lub 0

( )�

≤>=

0001

udla

udlauf (1. 3)

Ograniczono� � mo� liwo

�ci jednego perceptronu i sieci jednowarstwowych zło� onych z perceptronów

spowodowały krytyk� tego podej�cia w ksi � � ce Minsky'ego i Paperta [91], która przyczyniła si � do znacznego

zmniejszenia finansowania tej dziedziny bada i w rezultacie spowolnienie rozwoju sieci neuronowych. Tylko nieliczne o

�rodki badawcze, skupione wokół takich naukowców jak Grossberg, Widrow, von der Malsburg,

Amari, Fukushima czy Kohonen, prowadziły badania w tej dziedzinie. Dopiero gwałtowny rozwój technologii układów o wielkim stopniu scalenia (VLSI) w latach osiemdziesi � tych spowodował ogromny wzrost zainteresowania układami przetwarzania równoległego informacji, do których s� zaliczane sieci neuronowe. Poczynaj � c od opublikowanych w 1982 r. prac Hopfielda (48~, rozwój teorii sieci neuronowych odbywa si � w zawrotnym tempie, a liczba o

�rodków uprawiaj � cych t� interdyscyplinarn� dziedzin� nauki jest ogromna.

Opracowanie, czy raczej powtórne odkrycie zasady propagacji wstecznej (46), w zastosowaniu do uczenia sieci wielowarstwowych zlikwidowało te ograniczenia sieci, które stanowiły główna przyczyn� jej krytyki w ksi ��� ce Minsky'ego i Paperta. Ogromny wzrost finansowania tej dziedziny nauki spowodował istotny post� p zarówno w teorii, jak i zastosowaniach praktycznych. W poł � czeniu z gwałtownym rozwojem systemów komputerowych dało to podstaw� opracowania nowych rozwi � za technologicznych dotycz� cych percepcji oraz sztucznego postrzegania i

�wiadomo

�ci, sterowania skomplikowanymi systemami, przetwarzania sygnałów mowy itp.

Jakkolwiek sieci neuronowe stanowi � dziedzin� wiedzy całkowicie samodzieln� , w rozwi � zaniach praktycznych stanowi � zwykle cz� � � steruj � c procesem b� d� cz� � � decyzyjna, przekazuj � c� sygnał wykonawczy innym elementom urz� dzenia, nie zwi � zanym bezpo

�rednio z sieciami neuronowymi. Funkcje pełnione przez

sie� mog� by� sklasyfikowane w kilku podstawowych grupach: aproksymacji, klasyfikacji i rozpoznawania wzorców, predykcji, sterowania oraz asocjacji.

Sie� aproksymuj � ca odgrywa rol � uniwersalnego aproksymatora funkcji wielu zmiennych [52], realizuj � c funkcj � nieliniow� o postaci

( )xfy = (1. 4) przy czym x jest wektorem wej

�ciowym, a y - realizowan� funkcj � skalarn� wielu zmiennych. Wiele zada

modelowania, identyfikacji, przetwarzania sygnałów da si � sprowadzi � do zagadnienia aproksymacyjnego. Przy klasyfikacji i rozpoznawaniu wzorców sie� uczy si � podstawowych cech tych wzorców, takich jak

odwzorowanie geometryczne układu pikselowego wzorca, rozkładu składników głównych wzorca czy innych

jego wła�ciwo

�ci. W uczeniu s� podkre

�lane ró� nice wyst � puj � ce w ró� nych wzorcach, stanowi � ce podstaw�

podj � cia odpowiedniej decyzji klasyfikacyjnej. W dziedzinie predykcji zadaniem sieci jest okre

�lenie przyszłych zachowa si � systemu na podstawie

ci � gu warto�ci z przeszło

�ci. Maj � c informacj � o warto

�ciach zmiennej x w chwilach poprzedzaj � cych predykcj �

x(k - 1), x(k - 2), …, x(k - N) sie� podejmuje decyzj � , jaka b� dzie estymowana warto� � x (k) badanego ci � gu

w chwili aktualnej k . Uwzgl � dniaj � c aktualny bł � d predykcji ε = x(k) - x (k) oraz warto� � tego bł � du

z przeszło�ci jest podejmowana adaptacja wag sieci umo� liwiaj � ca dokładniejszy predykcj � w przyszło

�ci.

W zagadnieniach sterowania procesami dynamicznymi sie� neuronowa pełni zwykle kilka funkcji. Stanowi model nieliniowy tego procesu, identyfikuj � c jego podstawowe parametry niezb� dne do wypracowania odpowiedniego sygnału steruj � cego. Pełni funkcj � układu

�ledz� cego i nad� � nego adaptuj � c si � do zmiennych

warunków �rodowiskowych. Mo� e równie� stanowi � bezpo

�redni neuroregulator typu PID zast� puj � cy

klasyczne rozwi � zania. Wa� ni rol � , zwłaszcza w sterowaniu robotów, odgrywa klasyfikacja i podejmowanie decyzji co do dalszego przebiegu procesu.

W zadaniach asocjacji roli sieci neuronowej jest pami ��� asocjacyjna. Mo� na tu wyró� ni � pami ��� autoasocjacyjn� , gdzie skojarzenie dotyczy tylko poszczególnych składowych wektora wej

�ciowego oraz

pami ��� heteroasocjacyjn� , w której zadaniem sieci jest skojarzenie ze sob� dwu wektorów. W przypadku podania na wej

�cie sieci wektora zaszumionego bud� pozbawionego pewnych fragmentów danych sie� potrafi

odtworzy� pełny wektor oryginalny, pozbawiony szumów, generuj � c przy tym pełni posta� drugiego odpowiadaj � cego mu wektora.

Najwa� niejsz� cech� sieci neuronowych, stanowi � c� o jej ogromnych zaletach i szerokich mo� liwo

�ciach zastosowa , jest równoległe przetwarzanie informacji przez wszystkie ogniwa. Przy ogromnej,

masowej skali powi � za neuronowych mo� liwe jest dzi � ki temu znaczne przyspieszenie procesu przetwarzania informacji. W wielu przypadkach jest mo� liwe przetwarzanie sygnałów w czasie rzeczywistym.

Ponadto przy bardzo du� ej liczbie powi � za mi � dzyneuronowych sie� staje si � odporna na bł � dy wyst� puj � ce w niektórych powi � zaniach. Funkcj � uszkodzonych wag przejmuje inne i w efekcie w działaniu sieci nie dostrzega si � istotnych zaburze .

Inn� nie mniej wa� n� cech� sieci jest zdolno� � do uczenia si � i uogólniania nabytej wiedzy. Sie� ma

wła�ciwo

� � sztucznej inteligencji. Wytrenowana na wybranej grupie danych ucz� cych potrafi skojarzy� nabyt � wiedz� i wykaza� dobre działanie na danych nie uczestnicz� cych w procesie uczenia. Istotn� zalet� sieci jest mo� liwo

� � jej realizacji w technice o wielkim stopniu scalenia. Zró� nicowanie elementów sieci jest niewielkie, a ich powtarzalno

� � ogromna. Stwarza to perspektyw� zbudowania uniwersalnego procesora, który, by� mo� e, w przyszło

�ci zast� pi klasyczne procesory steruj � ce pracy

komputerów (tzw. neurokomputery). Mo� liwo

�ci zastosowa sieci neuronowych w przetwarzaniu sygnałów s� ci � gle jeszcze nie do ko ca

zbadane i wydaje si � , � e b� d� one jeszcze przez wiele lat stanowi � o post� pie w technice informacyjnej.

1.2. Podstawowe architektury sieci neuronowych Sposoby poł � czenia neuronów mi � dzy sob� i ich wzajemnego współdziałania spowodowały powstanie ró� nych typów sieci. Ka� dy typ sieci jest z kolei

�ci�le powi � zany z odpowiednik metody doboru wag (uczenia).

Z wielu ró� nych rodzajów sieci ograniczono si � tutaj do kilku najcz� � ciej stosowanych, w tym sieci jednokierunkowej jednowarstwowej, sieci jednokierunkowej wielowarstwowej oraz sieci rekurencyjnych.

1.2.1. Sie� jednokierunkowa jednowarstwowa

W sieci tej neurony s� uło� one w jednej warstwie, zasilanej jedynie z w� złów wej�ciowych (rys. 1.1).

Poł � czenie w� złów wej�ciowych z neuronami warstwy wyj

�ciowej jest zwykle pełne (ka� dy w� zeł jest

poł � czony z ka� dym neuronem). Przepływ sygnałów wyst� puje w jednym kierunku, od wej�cia do wyj

�cia.

W � zły wej�ciowe nie tworzy warstwy neuronów, gdy� nie zachodzi w nich � aden proces obliczeniowy. Sposób

doboru wag i wybór metody uczenia stanowi tutaj o nazwie sieci. Z tego powodu sie� tego rodzaju mo� e stanowi � zarówno sie� Kohonena, jak i perceptron jednowarstwowy. B� d� z tym tak� e zwi � zane rodzaje funkcji aktywacji oraz metoda uczenia.

Rysunek 1.1 Schemat sieci jednokierunkowej jednowarstwowej

Rysunek 1.2 Schemat sieci jednokierunkowej dwuwarstwowej

1.2.2. Sie� jednokierunkowa wielowarstwowa

Cech� charakterystyczn� sieci jednokierunkowej wielowarstwowej jest wyst� powanie co najmniej jednej warstwy ukrytej neuronów, po

�rednicz� cej w przekazywaniu sygnałów mi � dzy w� złami wej

�ciowymi

a warstwy wyj�ciowi. Sygnały wej

�ciowe s� podawane na pierwszy warstw� ukryt� neuronów, a te z kolei

stanowi sygnały � ródłowe dla kolejnej warstwy. Typowy przykład sieci jednokierunkowej dwuwarstwowej przedstawiono na rys. 1.2. Wyst� puj tu poł � czenia pełne mi � dzy warstwami. W szczególno

�ci w niektórych

zastosowaniach pewne poł � czenia mi � dzyneuronowe mog� nie wyst� pi � i mówi si � wówczas o poł � czeniu cz� � ciowym, lokalnym. Zwykle poł � czenia dotycz wtedy cz� � ci warstwy poprzedniej skupionej w okre

�lonym

obszarze, tworz� cym pole recepcyjne danego neuronu. Neurony warstw ukrytych, jak pokazano w dalszej cz� � ci pracy, stanowi bardzo istotny element sieci, umo� liwiaj � cy uwzgl � dnienie zwi � zków mi � dzy sygnałami, wynikaj � cymi z zale� no

�ci statystycznych wy� szego rz� du.

Nale� y odnotowa� , � e sieci jednokierunkowe wielowarstwowe wykorzystuj � najcz� � ciej funkcj � aktywacji o nieliniowo

�ci typu sigmoidalnego i stanowi � naturalne uogólnienie perceptronu Rosenblatta. St� d

wywodzi si � ich inna, cz� sto jeszcze u� ywana nazwa perceptronu wielowarstwowego.

1.2.3. Sieci rekurencyjne Sieci rekurencyjne ró� ni � si � od sieci jednokierunkowych wyst� powaniem sprz� � enia zwrotnego mi � dzy warstwami wyj

�ciowi i wej

�ciowi. Mo� na tu wyró� ni � sieci jednowarstwowe majce jedynie jedni warstw�

neuronów (wyj�ciowych) oraz sieci majce dodatkowi warstw� ukryty. Na rysunku 1.3a przedstawiono typow�

sie� rekurencyjn� , jednowarstwow� , w której sygnały wyj�ciowe neuronów tworz� jednocze

�nie wektor

wej�ciowy sieci dla nast� pnego cyklu (z-1 oznacza jednostkowy operator opó� nienia). Jest to sie� Hopfielda,

w której zwykle nie wyst� puje sprz� � enie neuronu od własnego sygnału wyj�ciowego (waga Wii = 0). Na

rysunku 1.3b przedstawiono przykład sieci rekurencyjnej z warstw� ukryty neuronów. Neurony numerowane od 1 do M s� neuronami wyj

�ciowymi sieci, a warstw� ukryt� stanowi � neurony od 1 do K. Sygnały warstwy

wyj�ciowej i ukrytej ł � cznie z ewentualnymi sygnałami wej

�ciowymi x1,… , xN, stanowi � wektor wej

�ciowy

sieci dla nast� pnego cyklu obliczeniowego.

Rysunek 1.3 Schemat sieci rekurencyjnej : a) jednowarstwowej ; b) z jedn� warstwy ukryt � neuronów

Proces ustalania si � sygnałów wyj�ciowych sieci rekurencyjnych jest procesem dynamicznym ze

wzgl � du na wyst� powanie jednostkowych operatorów opó� nienia. Bior� c pod uwag� nieliniowo� � funkcji

aktywacji neuronów jest to dynamika nieliniowa, stanowi � ca istotn� cech� tego rodzaju sieci.

1.3. Przegl d podstawowych metod uczenia sieci Wa� n� wła

�ciwo

�ci � sieci neuronowej jest jej zdolno

� � adaptacyjna umo� l iwiaj � ca zaprojektowanie struktury i dobór parametrów sieci do wykonania okre

�lonego zadania. Celem procesu uczenia jest taki adaptacyjny dobór

wag, który umo� liwi dostosowanie działania sieci do warunków �rodowiskowych okre

�lonych w postaci

odpowiednich wymaga co do odwzorowania danych wej�ciowych w wyj

�ciowe. Adaptacja wag odbywa si �

w kolejnych cyklach i mo� e by� zapisana w postaci

( ) ( ) ( )kWkWkW ijijij ∆+=+1 (1.5)

przy czym k oznacza numer cyklu ucz� cego, Wij (k) jest star� , a Wij (k+1)- now� waga synaptyczn� ł � cz� c� neuron i-ty z j-tym (poł � czenie od neuronu j-tego do i-tego). Z punktu widzenia systemu ucz� cego sieci neuronowej mo� na wyró� ni � uczenie pod nadzorem (z nauczycielem), uczenie z krytykiem (reinforcement learning) oraz uczenie samoorganizuj � ce si � (bez nadzoru).

W przypadku pierwszym uczenie odbywa si � pod nadzorem „zewn� trznego nauczyciela" . W tym trybie wej

�ciowym sygnałom ucz� cym towarzysz warto

�ci � � dane na wyj

�ciu sieci. Typowym przykładem

takiego uczenia jest proces minimalizacji funkcji celu definiowanej ka� dorazowo dla okre�lonego zadania sieci.

Uczenie z krytykiem polega na doborze warto�ci wag sieci metod� prób i bł � dów w taki sposób, aby

zmaksymalizowa� wska� nik jako�ci uczenia, zale� ny zwykle od postaci jednego sygnału, zwanego krytykiem,

generowanego w procesie adaptacji. Podstawi tego uczenia jest przyj � cie, � e je�li podj � ta przez sie� akcja daje

rezultat pozytywny, to wagi sieci nale� y wzmocni � do działania w danym kierunku. W przeciwnym przypadku, gdy rezultat jest negatywny, nale� y tak zmodyfikowa� warto

�ci wag, aby t� tendencj � osłabi � .

W przypadku uczenia samoorganizuj � cego si � nie wyst� puje ani „nauczyciel", ani „krytyk" wskazuj � cy kierunek zmian wag. Uczenie nast� puje zgodnie z okre

�lony „ filozofii" działania sieci, umo� liwiaj � cy na

stowarzyszenie zmian sygnałów wej�ciowych sieci z odpowiedziami sieci po stronie wyj

�ciowej. Typowymi

przedstawicielami uczenia samoorganizuj � cego si � jest uczenie Hebba wraz z jego licznymi odmianami, gdzie adaptacja wagi Wi j zale� y od stanu aktywacji neuronów poł � czonych dani wagi, oraz uczenie typu Kohonena, gdzie wykorzystuje si � konkurencj � mi � dzy neuronami do wyłonienia zwyci � zcy, dopasowuj � cego swoje wagi do danych wej

�ciowych, dla których jego aktywno

� � jest najwi � ksza.

1.3.1. Uczenie pod nadzorem W uczeniu pod nadzorem ka� demu wektorowi wej

�ciowemu x(k)=[x1(k),x2(k),…,xN(k)] T towarzyszy zadany

wektor wyj�ciowy d(k)=[d1(k),d2(k),…,dM(k)] T. Dane ucz� ce s� podane w postaci par (x(k), d(k)), dla k = 1, 2, . .

., p, przy czym p oznacza liczb� wzorców ucz� cych. Je�l i wektorowi wej

�ciowemu x(k) odpowiada � � dana

posta� wektora wyj�ciowego d(k) sieci, to dla ka� dej pary ucz� cej mo� na zdefiniowa� funkcj � bł � du w postaci

( ) ( ) ( )( )kdkyke −= (1.6) przy czym y(k) jest aktualn� odpowiedzi � sieci na wymuszenie w postaci wektora wej

�ciowego x(k).

Celem uczenia pod nadzorem jest minimalizacja odpowiednio zdefiniowanej funkcji celu, która w wyniku umo� l iwi dopasowanie warto

�ci aktualnych odpowiedzi neuronów wyj

�ciowych (wektor y) do

warto�ci ��� danych (wektor d) dla wszystkich p par ucz� cych, przy czym dopasowanie to jest rozumiane w sensie

statystycznym. Najcz� � ciej przyjmowani postacie funkcji celu jest bł � d �redniokwadratowy

( )��= =

=p

k

M

jj keE

1 1

2

21

(1.7)

okre�lany dla wszystkich M neuronów wyj

�ciowych i wszystkich p par ucz� cych. Minimalizacja warto

�ci

funkcji celu odbywa si � zazwyczaj przy wykorzystaniu metod gradientowych optymalizacji pod warunkiem, � e funkcje aktywacji neuronów s� ci � głe. W metodach gradientowych zmiana warto

�ci wag odbywa si � pod

wpływem gradientu funkcji celu ∆W = f (∇ E(W)). Najpopularniejsz� i najcz� � ciej stosowan� metod� jest metoda najwi � kszego spadku, zgodnie z któr� ∆W = -η∇E(W), przy czym η jest współczynnikiem uczenia. Uaktualnienie wag mo� e nast� powa� ka� dorazowo po prezentacji jednej pary ucz� cej (w przypadku zastosowania gradientowej metody najwi � kszego spadku metoda taka nosi tradycyjn� nazw� reguły delta) lub po zaprezentowaniu wszystkich par ucz� cych (tzw. skumulowana reguła delta).

W przypadku skokowych funkcji aktywacji metody gradientowe staje si � nieskuteczne ze wzgl � du na niespełnienie warunku ci � gło

�ci funkcji celu. Stosuje si � wtedy metody bezgradientowe, z których najbardziej

znana jest tzw. reguła perceptronu i jej uogólnienie znane pod nazw� reguły Widrowa-Hoffa. Zgodnie z reguł � perceptronu dobór wag odbywa si � w nast� puj � cym cyklu. Przy zadanych wst� pnie warto

�ciach wag Wij oraz

Wi0 prezentuje si � na wej�ciu wektor ucz� cy x i oblicza warto

� � sygnału wyj�ciowego yi. W wyniku porównania

aktualnej warto�ci yi oraz warto

�ci � � danej di dokonuje si � aktualizacji wag.

• Je�li warto

� � yi równa si � warto�ci ��� danej di, to wagi Wij oraz Wi0 pozostaj � nie zmienione.

• Je�li warto

� � yi = 0, a odpowiadaj � ca mu warto� � ��� dana di = 1, to uaktualnianie wag odbywa si �

zgodnie ze wzorem Wij(k+1) = Wij(k) + xj oraz Wi0 (k+1) = Wi0 (k) + 1, przy czym k jest oznaczeniem cyklu poprzedniego, a k + 1 cyklu bie� � cego.

• Je�li warto

� � yi = 1, a odpowiadaj � ca mu warto� � ��� dana di = 0, to uaktualnianie wag opisuje zale� no

� � Wij(k+1) = Wij(k) - xj oraz Wi0 (k+1) = Wi0 (k) - 1.

Po uaktualnieniu wag nast� puje prezentacja nowego wektora ucz� cego x i stowarzyszonej z nim warto�ci

� � danej di, a nast� pnie ponowna aktualizacja wag. Proces powtarza si � dla wszystkich wzorców ucz� cych wielokrotnie, a� uzyska si � minimalizacj � ró� nic mi � dzy warto

�ciami yi i odpowiadaj � cymi im warto

�ciami

� � danymi di .

Rysunek 1.4 Sie� neuronowa jako układ adaptacyjny

Uogólnieniem reguły perceptronu jest reguła Widrowa-Hoffa, zgodnie z któr� dobór warto�ci wag

neuronu dowolnego typu odbywa si � według zale� no�ci:

( ) ( ) ijijij WkWkW ∆+=+1 (1.8)

( )iijij ydxW −=∆ (1.9)

Identyczna relacja opisuje dobór wag polaryzacji Wi0, dla której sygnałem wej�ciowym jest zawsze

warto� � 1, w zwi � zku z czym

( )iii ydW −=∆ 0 (1. 30)

Jak łatwo mo� na zauwa� y� , przy zało� eniu warto�ci binarnych 0, 1 dla sygnału yi i di reguła Widrowa-

Hoffa przekształca si � w reguł � perceptronu. Cech� charakterystyczn� zarówno reguły perceptronu, jak i uogólnionej reguły Widrowa-Hoffa jest

wykorzystywanie w uczeniu jedynie informacji o aktualnej warto�ci sygnału wyj

�ciowego neuronu i warto

�ci

� � danej. Ze wzgl � du na nieci � gło� � funkcji nieliniowej perceptronu nie mo� na wykorzysta� informacji

o zmianach warto�ci yi (pochodnej). Minimalizacja ró� nic mi � dzy odpowiedziami aktualnymi neuronu yi

i warto�ciami ��� danymi di, odpowiada minimalizacji kwadratowej funkcji celu E

( ) ( )[ ]�=

−=p

kii kdkyE

1

2 (1.11)

przy czym p oznacza liczb� zadanych wzorców ucz� cych. Nale� y podkre�li � , � e efektywno

� � tej metody jest niewielka, a liczba cykli ucz� cych i czas uczenia wzrasta niepomiernie, zwłaszcza przy du� ej liczbie neuronów i próbek ucz� cych.

W podsumowaniu mo� na zaznaczy� , � e ogólny schemat procesu uczenia pod nadzorem zarówno typu gradientowego, jak i bezgradientowego mo� e by� przedstawiony w postaci systemu adaptacyjnego (rys. 1.4), w którym adaptacja wag sieci odbywa si � pod wpływem bł � du e(k), okre

�lanego dla ka� dej pary ucz� cej. Istotn�

cech� tego procesu jest istnienie sprz� � enia zwrotnego, umo� liwiaj � cego korekcj � warto�ci wag sieci,

prowadz� c� do minimalizacji ró� nic mi � dzy aktualn� odpowiedzi � układu wyra� on� przez wektor y a warto

�ciami � � danymi reprezentowanymi przez wektor d.

Rysunek 1.5 Struktura sieci neuronowej z krytykiem

1.3.2. Uczenie z krytykiem Uczenie z krytykiem1 jest odmian� uczenia pod nadzorem, w którym nie wyst� puje informacja o warto

�ciach

� � danych na wyj�ciu systemu, a jedynie informacja, czy podj � ta przez system akcja (np. zmiana warto

�ci wagi)

daje wyniki pozytywne w sensie po� � danego zachowania systemu, czy negatywne. Je�li działanie podj � te przez układ ucz� cy daje wynik pozytywny, to nast� puje wzmocnienie tendencji

do wła�ciwego zachowania si � systemu w podobnych sytuacjach w przyszło

�ci. W przeciwnym przypadku, je

�li

wynik jest negatywny, to nast � puje osłabienie tendencji takiego działania systemu. Typowy schemat blokowy adaptacyjnego układu z krytykiem przedstawiono na rys. 1.5. Układ ucz� cy

współpracuje ze �rodowiskiem za po

�rednictwem krytyka, który na podstawie aktualnego stanu

�rodowiska

i predykcji co do jego przyszłych zmian wypracowanej na podstawie aktualnej wiedzy przekazuje sygnał steruj � cy r umo� liwiaj � cy podj � cie odpowiedniej akcji a, wpływaj � cej na stan

�rodowiska x. Zarówno x, jak i a

oznaczaj wektory o wymiarach zale� nych od specyfiki rozwi � zywanego problemu. Podj � ta przez układ ucz� cy w chwili k akcja a(k) wpływa na

�rodowisko zmieniaj � c jego stan z x(k) na x(k+1). Po zmianie stanu

�rodowiska

układ ucz� cy otrzymuje od krytyka sygnał steruj � cy r^(k+1), zale� ny w okre�lony sposób od poprzedniego stanu

systemu x(k) oraz podj � tej akcji a, której optymalno� � b� dzie oceniana z punktu widzenia zmian zachodz� cych

w �rodowisku. Wska� nik jako

�ci uczenia jest okre

�lany najcz� � ciej w postaci

( ) ( ) ��

��

� += �∞

==

001

ixx

i irEJ γ (1. 42)

przy czym operator warto�ci oczekiwanej E jest rozumiany w sensie strategii wyboru akcji przez system ucz� cy.

Współczynnik γ jest parametrem z przedziału 0 ≤ γ < 1, wpływaj � cym na zakres zmian poprzednich akcji uwzgl � dnianych w sterowaniu. Je

�li γ = 0, to w sterowaniu jest jedynie uwzgl � dniany sygnał r(1) jako wynik

pierwszej akcji a(0). System nale� y do kategorii układów z opó� nieniem, gdy� sygnał steruj � cy r w chwili h jest okre

�lany

na podstawie stanu �rodowiska w chwilach poprzednich i sekwencji tych zmian. Zachowanie aktualne układu

zale� y od sekwencji zmian �rodowiska wywołanych akcjami podj � tymi przez układ ucz� cy.

Głównym elementem układu krytyka jest predykcja sygnału steruj � cego r wpływaj � cego bezpo�rednio

na układ ucz� cy, a za po�rednictwem elementu wykonawczego i bazy wiedzy, decyduj � cych o podj � tej akcji a.

Zgodnie z prac� [135] jego estymat� w chwili (k + 1) okre�la wzór

1 W oryginalnej wersji j � zykowej uczenie tego typu nosi nazw� reinforcement learning, które w ,j � zyku polskim jest równie� nazywane uczeniem ze wzmocnieniem [46].

( ) ( ) ( ) ( )kJkJkrkr ˆ1ˆ11ˆ −+++=+ γ (1.13) w którym J jest estymat� wska� nika jako

�ci J opisanego zale� no

�ci (1.12). Uczenie systemu polega na doborze

wag synaptycznych Wij elementu ucz� cego wg zale� no�ci [135]

( ) ( ) ( ) ( )kekrkWkW ijijij 1ˆ1 ++=+ η (1.14)

w której η jest współczynnikiem uczenia, a eij - u�rednionym parametrem dopasowania (eligibility), okre

�lanym

według zale� no�ci rekurencyjnej

( ) ( ) ( ) ( )kekeke aijijij λλ −+−= 11 (1.15)

Składnik eaij jest parametrem dopasowania wagi Wij i jest okre�lany jako iloczyn dwu czynników,

z których pierwszy zale� y bezpo�rednio od aktualnie podj � tej akcji, a drugi od wyst� pienia okre

�lonego

pobudzenia [135]. Parametr λ jest uto� samiany ze współczynnikiem zapominania, a jego warto� � mo� e by�

dobierana z przedziału [0,1]. Przy warto�ci bliskiej λ jedno

�ci aktualnie podj � ta akcja mało wpływa na dobór

wagi, w przeciwnym przypadku, gdy λ maleje do zera, odpowiedzialno� � podj � tej akcji za zmian� wag wzrasta.

Uczenie z krytykiem, w odró� nieniu od uczenia pod nadzorem, ocenia skutki podj � tej akcji i w zale� no

�ci od tego oraz aktualnej bazy danych podejmuje decyzj � co do dalszej akcji. Jest znacznie bardziej

uniwersalne w zastosowaniu, gdy� nie wymaga obecno�ci sygnałów � � danych na wyj

�ciu systemu. Jednocze

�nie

jego realizacja praktyczna jest bardziej skomplikowana.

1.3.3. Uczenie samoorganizuj � ce si � typu Hebba W modelu Hebba wykorzystuje si � wynik obserwacji neurobiologicznych [48], zgodnie z którymi waga powi � za mi � dzy dwoma neuronami wzrasta przy jednoczesnym stanie pobudzenia obu neuronów, w przeciwnym przypadku maleje. Na tej podstawie zaproponowano schemat matematyczny uczenia Hebba, spełniaj � cy ten postulat. W ogólnym przypadku, je

�li model neuronu zostanie przedstawiony w postaci z rys.

1.6, to reguła uczenia Hebba okre�laj � ca zmiany warto

�ci wag w kolejnych cyklach ucz� cych Wij(k+1) = Wij(k)

+ ∆Wij(k) mo� e by� zapisana nast� puj � co:

( ) ( )ijij yxFkW ,=∆ (1.56)

przy czym F() jest funkcj � stanu sygnału wej�ciowego xj, zwanego presynaptycznym, oraz sygnału wyj

�ciowego

yi, zwanego postsynaptycznym. W klasycznym uj � ciu reguła Hebba upraszcza si � do funkcji iloczynowej tych sygnałów

( ) ( ) ( )kykxkW ijij η=∆ (1.17)

przy czym η jest współczynnikiem uczenia okre�laj � cym stopie , w jakim sygnały ucz� ce w chwili k wpływaj �

na dobór warto�ci wag.

Uczenie neuronu z zastosowaniem reguły Hebba mo� e si � odbywa� w trybie bez nauczyciela lub z nauczycielem. W pierwszym przypadku w regule Hebba u� ywa si � aktualnej warto

�ci yi sygnału wyj

�ciowego

neuronu, jak to przedstawia zale� no� � (1.17). W uczeniu z nauczycielem warto

� � sygnału wyj�ciowego yi

zast� puje si � warto�ci � � � dan� di dla tego neuronu. W tym przypadku reguł � Hebba mo� na zapisa� w postaci

( ) ( ) ( )kdkxkW ijij η=∆ (1.18)

Reguła Hebba mo� e by� stosowana do ró� nego typu struktur sieci neuronowych i ró� nych funkcji aktywacji neuronu.

Wad� prostej reguły Hebba jest wykładniczy wzrost wag przy wielokrotnej prezentacji takiego samego wymuszenia xj. Efektem tego jest nasycenie neuronu. Dla unikni � cia takiej sytuacji modyfikuje si � reguł � (1.17) przez

Rysunek 1.6 Model neuronu

Dla unikni � cia takiej sytuacji modyfikuje si � reguł � (1.17) przez wprowadzenie współczynnika zapominania γ ( ) ( ) ( ) ( ) ( )kykWkykxkW iijijij γη −=∆ (1. 69)

dzi � ki czemu sygnał postsynaptyczny yi(k) wpływa na warto� � wagi neuronu. Przy sygnale iji Wx

ηγ< zmiana

wagi ∆Wij mo� e by� ujemna. Odpowiedni dobór warto�ci γ umo� l iwia powstrzymanie niekontrolowanego

wzrostu wag. Dobór warto�ci współczynnika γ jest kluczowy dla zapewnienia stabilno

�ci procesu uczenia

i zale� y od konkretnego problemu. Lepsze rezultaty uzyskuje si � przyjmuj � c modyfikacj � Oji , zgodnie z któr� ( ) ( ) ( ) ( ) ( )[ ]kWkykxkykW ijijiij −=∆ η (1. 70)

Reguła przypomina propagacj � wsteczn� sygnału yi (sygnał wyj�ciowy yi neuronu jest kierowany od wyj

�cia

z powrotem na wej�cie, modyfikuj � c warto

� � sygnału wej�ciowego xj). Przy jednym neuronie w warstwie reguła

Oji jest reguł � lokaln� , gdy� w procesie modyfikacji bior� udział jedynie sygnały zwi � zane z neuronem poddanym uczeniu.

Modyfikacja (1.20) wprowadza samonormalizacj � wektora wagowego W neuronu w ka� dym kroku ucz� cym. Wprowadzaj � c uogólnion� posta� wektorow� modyfikacji wag, w której

( ) xWWxxWky TT

jjiji ===� , ( ) ( )( )WyxkykW ii −=∆ η , przy czym W - wektor wag i-tego

neuronu, a x - wektor wej�ciowy stanowi � cy pobudzenie tego neuronu, reguł � Oji mo� na zapisa� w postaci

wektorowej

( ) [ ] WxxWWkW TT−=∆ 1η (1. 21) Macierz korelacji oznaczy si � tu przez C = xxT . Stabilny proces uczenia wymaga, aby po dostatecznie

długim czasie uczenia ||∆W=0||, czyli

CWWWCW T= (1. 22) Niech λ oznacza najwi � kszy warto

� � własn� macierzy korelacji, a wektor W dobiera si � jako wektor własny stowarzyszony z ni � ; z definicji warto

�ci własnej otrzymuje si � CW = λW. Podstawiaj � c t� zale� no

� � do wzoru (1.22) otrzymuje si �

2WWWT λλλ == (1. 23)

Z zale� no�ci (1.23) wida� , � e wynikiem zastosowania reguły Oji jest ograniczenie modułu wektora W

do jedno�ci, |W| = 1, co odpowiada ograniczeniu wag w stanie ustalonym uczenia.

Inne, statystyczne sformułowanie postulatu Hebba zaproponował Sejnowski w pracy [128], zgodnie z którym

( ) ( ) ( )[ ] ( )( ) ( )( )[ ]yixjijij CkyCkxEkykxkW −−==∆ ηη cov (1. 24)

Symbol cov[ ] oznacza kowariancj � , E - operator warto�ci oczekiwanej, a Cx i Cy - warto

�ci

�rednie

sygnałów odpowiednio presynaptycznych xj(k) oraz postsynaptycznych yi(k). Z zale� no�ci (1.24) wynika, � e siła

powi � za synaptycznych wzrasta, je�li zarówno sygnały presynaptyczne, jak i postsynaptyczne s� skorelowane

dodatnio, a maleje, je�li ta korelacja jest ujemna. Uwzgl � dnienie w zale� no

�ci (1.24) warto

�ci

�rednich Cx i Cy

branych ze znakiem przeciwnym stanowi czynnik samoograniczaj � cy nadmierny wzrost wag. Przedstawione zale� no

�ci modyfikuj � ce reguł � Hebba dotycz� jedynie neuronów liniowych.

Uogólnienie tej modyfikacji na neurony nieliniowe zaproponował Oja w pracy [101]. W przypadku jednego neuronu uogólniona reguła Oji ma posta�

( ) [ ] ( )xWxLWWkW TT−=∆ 1η (1. 25) Funkcja L(xTW) jest odpowiednikiem zale� no

�ci xTW wyst� puj � cej we wzorze (1.21) i wynika z istnienia

nieliniowej funkcji aktywacji neuronu, a składnik WWTL(xTW)x jest czynnikiem stabilizuj � cym reguł � Hebba w przypadku neuronu nieliniowego. Posta� funkcji L(u) zale� y od przyj � tej definicji funkcji aktywacji f (u) neuronu nieliniowego i jest zdefiniowana w postaci

( ) ( )du

udfuL

2

= (1. 26)

W przypadku neuronu sigmoidalnego o f (u) = tgh(u) funkcja L(u) przyjmuje posta� L(u) = tgh(u) [1 - tgh2 (u)]. W szczególno

�ci przy zało� eniu liniowej funkcji aktywacji f (u) = u zale� no

� � (1.25) upraszcza si � do zale� no

�ci (1.21) obowi � zuj � cej w przypadku liniowym. W ogólno

�ci algorytmy ucz� ce Hebba mo� na zaliczy� do uczenia typu korelacyjnego, w którym siła

poł � czenia mi � dzyneuronowego wzrasta przy istnieniu korelacji mi � dzy sygnałami presynaptycznym i postsynaptycznym neuronu.

Przeciwnym typem uczenia jest uczenie dekorelacyjne antyhebbowskie, w którym siła poł � czenia mi � dzyneuronowego wzrasta wówczas, gdy sygnały presynaptyczny i postsynaptyczny s� zdekorelowane (jeden sygnał w stanie pobudzenia, a drugi w stanie zgaszenia). Uczenie antyhebbowskie wyró� nia przeciwny znak uwzgl � dniony przy ∆Wij(k)

( ) ( ) ( )kykxkW ijij η−=∆ (1. 27)

W przeciwie stwie do reguły Hebba uczenie antyhebbowskie nigdy nie wprowadza nieograniczonego wzrostu wag (warto

�ci własne macierzy korelacji niedodatnio okre

�lone) i jest stabilne bez � adnych

dodatkowych modyfikacji reguły.

1.3.4. Uczenie samoorganizuj � ce si � typu konkurencyjnego W uczeniu typu konkurencyjnego neurony współzawodniczy ze sob� , aby sta� si � aktywnymi (pobudzonymi). W odró� nieniu od uczenia Hebba, gdzie dowolna liczba neuronów mogła by� pobudzona, w uczeniu konkurencyjnym tylko jeden neuron mo� e by� aktywny, a pozostałe pozostaje wstanie spoczynkowym. Z tego powodu uczenie tego typu nosi równie� nazw� WTA (Winner Takes All). Grupa neuronów współzawodnicz� cych otrzymuje te same sygnały wej

�ciowe xj. W zale� no

�ci od aktualnych warto

�ci wag

sygnały wyj�ciowe neuronów �=

jjiji xWu ró� ni � si � mi � dzy sob� . W wyniku porównania tych sygnałów

zwyci � � a ten neuron, którego warto� � ui jest najwi � ksza. Neuron zwyci � zca przyjmuje na swoim wyj

�ciu stan 1,

a pozostałe (przegrywaj � ce) stan 0. Uczenie typu WTA nie wymaga nauczyciela i odbywa si � zwykle z zastosowaniem znormalizowanych

wektorów wej�ciowych x. Na wst� pie przyjmuje si � losowe, znormalizowane wzgl � dem 1 warto

�ci wag

poszczególnych neuronów. Po podaniu pierwszego wektora wej�ciowego x jest wyłaniany zwyci � zca. Neuron

zwyci � � aj � cy w konkurencji przyjmuje stan 1, co umo� liwia mu aktualizacj � wag Wij dochodz� cych do niego. Neurony przegrywaj � ce konkurencj � maj � na wyj

�ciu stan 0, co blokuje proces aktualizacji ich wag.

Aktualizacja wag neuronu zwyci � zcy odbywa si � według tak zwanej reguły Kohonena [68], która, wobec binarnych warto

�ci sygnałów wyj

�ciowych (0 lub 1) neuronów uczestnicz� cych we współzawodnictwie,

przyjmuje posta� ( ) ( ) ( )[ ]kWxkWkW ijjijij −+=+ η1 (1. 28)

Na działanie neuronów typu WTA istotny wpływ ma normalizacja wektorów wej�ciowych i wag.

Sygnał wyj�ciowy ui i-tego neuronu, b� d� cy sum� wagow� jego sygnałów wej

�ciowych, mo� e by� opisany

zale� no�ci � wektorow�

iT

i xWxWu ϕcos== (1. 29)

Wobec unormowania wektorów, ||W|| = ||x|| = 1, o warto�ci ui decyduje ró� nica k� towa mi � dzy

wektorami x oraz W, ui = cosϕi . Zwyci � � a zatem ten neuron, którego wektor wag jest najbli � szy aktualnemu wektorowi ucz� cemu x. W wyniku zwyci � stwa neuronu nast� puje adaptacja (zbli � enie) jego wag do danego wektora x. Przy podaniu na wej

�cie sieci wielu wektorów zbli � onych do siebie b� dzie zwyci ��� a� ci � gle ten sam

neuron, w wyniku czego jego wagi b� d� odpowiada� u�rednionym warto

�ciom wektorów wej

�ciowych, dla

których dany neuron był zwyci � zc� . Neurony przegrywaj � ce nie zmieniaj � swoich wag. Dopiero zwyci � stwo przy nast� pnej prezentacji wektora wej

�ciowego umo� l iwi im dokonanie aktualizacji wag i rozpocz� cie procesu

douczania przy kolejnych zwyci � stwach. W efekcie takiego współzawodnictwa nast� puje samoorganizacja procesu uczenia. Neurony

dopasowuj � swoje wagi w ten sposób, � e przy prezentacji grup wektorów wej�ciowych zbli � onych do siebie

zwyci � � a zawsze ten sam neuron. W trybie odtworzeniowym, w którym przy ustalonych warto�ciach wag

podaje si � na wej�cie sieci sygnały testuj � ce, neuron poprzez zwyci � stwo we współzawodnictwie rozpoznaje

swoje kategori � . Układy tego typu s� stosowane najcz� � ciej do klasyfikacji wektorów.

Rysunek 1.7 Sie� neuronowa do przykładu ilustruj � cego uczenie ze współzawodnictwem

Jako przykład rozwa� ono sie� neuronow� zło� on� z 4 neuronów typu WTA do klasyfikacji wektorów wej

�ciowych dwuelementowych (rys. 1.7). Wektory wej

�ciowe ucz� ce x przyj � to w postaci znormalizowanej:

��

��

�=

20,0

97,01x �

�

��

�=

00,0

00,12x �

�

��

�−=

70,0

72,03x �

�

��

�−=

74,0

67,04x

��

��

�−=

60,0

80,05x �

�

��

�

−=

00,1

00,06x �

�

��

�

−=

97,0

20,07x �

�

��

�

−−

=95,0

30,08x

Przebieg procesu uczenia przedstawiono na rys. 1.8. Kółkami zaznaczono kolejne poło� enia wektorów wag neuronów zwyci ��� aj � cych we współzawodnictwie, a liniami - wektory liniowe. Jak z rysunku wida� , jedynie trzy neurony zwyci ��� ały w procesie uczenia. Neuron czwarty pozostał martwy (nigdy nie zwyci � � ył) i nie dopasował si � do � adnej kategorii wektorowej.

Rysunek 1.8 Przebieg uczenia sieci czterowyj � ciowej przy zastosowaniu współzawodnictwa

Rysunek 1.9 Podział obszaru danych na wieloboki Voronoia

Uczenie sieci ze współczynnikiem uczenia η = 0, 05 umo� liwia po 320 cyklach ucz� cych uzyskanie wag trzech pierwszych neuronów w postaci

��

��

�−=

6786,0

7314,01W �

�

��

�

−=

9790,0

0276,02W �

�

��

�

−=

0656,0

9904,03W

Odzwierciedlaj � one 3 kategorie wektorów wej�ciowych: (x1, x2), (x3, x4, x5) oraz (x6, x7, x8), na które

samoczynnie został podzielony zbiór wej�ciowy.

Odmian� uczenia konkurencyjnego jest uczenie typu WTM ( Winner Takes Most), w którym neuron wygrywaj � cy konkurencj � uaktywnia si � w sposób maksymalny przyjmuj � c warto

� � sygnału wyj�ciowego yi = 1

i umo� liwiaj � c cz� � ciowe uaktywnienie innych neuronów z s� siedztwa. Stopie uaktywnienia neuronów z s� siedztwa zale� y od odległo

�ci ich wektorów wagowych od wag neuronu wygrywaj � cego.

Algorytmy wykorzystuj � ce konkurencj � mi � dzy neuronami, niezale� nie od tego, czy jest to konkurencja typu WTA, czy WTM, dokonuj � podziału obszaru danych na strefy wpływów poszczególnych neuronów. Współrz� dne punktu centralnego Wc, zwanego wektorem Voronoia, okre

�laj � wagi neuronu,

zwyci � � aj � cego w tych przypadkach, gdy wektor wej�ciowy x le� y w danej strefie wpływów. Zbiór wszystkich

punktów centralnych nosi tradycyjn� nazw� ksi ��� ki kodowej, a elementy obszaru przyci � gania wokół punktu centralnego (zwanego wielobokiem Voronoia) tworz� słowa kodowe. Wieloboki Voronoia dziel � przestrze danych odpowiednio do reguły najbli � szego s� siada, zgodnie z któr� przypisanie wektora wej

�ciowego x do

odpowiedniego obszaru nast� puje według najmniejszej odległo�ci ||x - Wc|| od najbli � szego punktu centralnego

Wc. Rysunek 1.9 przedstawia przykładowy podział obszaru dwuwymiarowego na wieloboki Voronoia w przypadku istnienia wielu punktów centralnych. Ka� dy wielobok Voronoia zawiera obszar najbli � szy w sensie okre

�lonej metryki punktowi centralnemu.

W przypadku przypisania ka� dej warto�ci wektora wej

�ciowego x odpowiedniej klasy C, do której ten

wektor nale� y, algorytm samoorganizacji nosi nazw� adaptacyjnego kwantowania wektorowego (Learning Vector Quantization - LVQ) i został zdefiniowany przez Kohonena w roku 1986 [70].

Zgodnie z tym algorytmem kolejny wektor x ze zbioru wej�ciowego jest porównywany z wektorami Wc

punktów centralnych. Je�l i klasa, do której przynale� y wektor x, jest zgodna z klask zwyci � skiego wektora Wc,

to wektor Wc jest przesuwany w stron� x, w przeciwnym przypadku - odsuwany od niego. Oznaczaj � c przez Wcj (j = 1, 2, . . . , n) zbiór wektorów Voronoia, a przez xi (i = 1, 2, . . . , p) zbiór wektorów wej

�ciowych, algorytm

LVQ mo� e by� przedstawiony nast� puj � co: 1. Prezentacja kolejnego (k + 1)-go wektora xi, wybranego losowo ze zbioru wej

�ciowego i okre

�lenie

najbli � szego mu pod wzgl � dem wybranej metryki wektora Voronoia Wc

2. Porównanie klasy Cxi przypisanej wektorowi xi i klasy CWc przypisanej zwyci � skiemu wektorowi Voronoia

• je�li Cxi = CWc , to

( ) ( ) ( )[ ]kWxkWkW cikcc −+=+ α1

• je�li Cxi ≠ CWc , to

( ) ( ) ( )[ ]kWxkWkW cikcc −−=+ α1

przy czym αk jest współczynnikiem liczbowym z przedziału 0 < αk < 1. 3. Pozostałe wektory Voronoia nie ulegaj � modyfikacji. Współczynniki αk nosz� nazw� współczynników uczenia, a ich warto

� � maleje do zera wraz z liczb� iteracji k. Typowa warto

� � startowa αk jest zwykle mniejsza ni � 0,1, a jej zmienno� � z liczb� iteracji jest liniowa b� d�

wykładniczo malej � ca.

1.4. Zdolno ci uogólniania sieci neuronowej Podstawow� cech� sieci neuronowej jest jej zdolno

� � do uogólniania, a wi � c generowania wła�ciwego

rozwi � zania dla danych, które nie pojawiły si � w zestawie danych ucz� cych. Rysunek 1.10 ilustruje graficznie sposób rozumienia zjawiska uogólniania. Zbiór danych wej

�ciowych, do których stosuje si � reguł � R zostaje

rozdzielony na 2 podzbiory : zbiór testuj � cy T oraz zbiór ucz� cy L, z którego dodatkowo wydzielono podzbiór V u� ywany w trakcie uczenia do sprawdzania stopnia nauczenia sieci (validation).

Rysunek 1.10 Podział przestrzeni danych na dane ucz� ce L, testuj � ce T oraz sprawdzaj � ce V

Rysunek 1.11 I lustracja zasady liniowego odseparowania wszystkich wzorców ucz� cych

Sie� zostaje poddana uczeniu na zbiorze L z bie��� cym sprawdzaniem stopnia uczenia na zbiorze V. Zdolno� �

odtworzenia zbioru L przez sie� jest miar� zdolno�ci zapami � tania danych ucz� cych, natomiast zdolno

� � do generowania wła

�ciwych rozwi � za dla danych nale� � cych do zbioru T, na których sie� nigdy nie była

trenowana, jest miar� zdolno�ci uogólniania. Zakłada si � przy tym, � e zarówno dane tworz� ce zbiór L, jak

i zbiór T s� typowymi reprezentantami zbiorów tworz� cymi reguł � R. Ilo

�ciowa miara uogólniania jest poj � ciem trudnym do zdefiniowania i jest oparta na zale� no

�ciach

statystycznych odnosz� cych si � do zbiorów [140]. Podstawow� wielko�ci � jest tu miara Vapnika-

Chervonenkisa, zwana w skrócie VCdim. Miara VCdim systemu została zdefiniowana jako liczebno� �

najwi � kszego zbioru S danych wzorców, dla których system mo� e zrealizowa� wszystkie mo� liwe 2n dychotomii zbioru S (podział zbioru na 2 cz� � ci za pomoc� linii).

Na przykład VCdim dla neuronu o dwóch wej�ciach wynosi n = 3. Łatwo mo� na wykaza� , � e zbiór

zło� ony z trzech danych ucz� cych jest najwi � kszym zbiorem, w którym mo� na przeprowadzi � podział na dwie liniowo separowalne grupy na 23 sposobów. Rysunek 1.11 ilustruje taki podział. Zwi � kszenie o jeden rozmiaru próbek ucz� cych powoduje, � e 2 neurony nie s� w stanie zrealizowa� wszystkich 24 podziałów liniowo odseparowanych. W ogólno

�ci dla neuronu o N wej

�ciach (wektor x N-elementowy) miara VCdim wynosi N +

1. Innymi słowy, miara VCdim dla sieci rozwi � zuj � cej problem klasyfikacji binarnej oznacza maksymaln� liczb� danych ucz� cych, które mog� zosta� bezbł � dnie odtworzone we wszystkich mo� liwych konfiguracjach.

Niech vL(W) oznacza bł � d uczenia sieci, czyli cz� stotliwo� � wyst� pienia bł � dnej klasyfikacji podczas

procesu uczenia, a P(W) - �rednie prawdopodobie stwo wyst� pienia bł � dnej klasyfikacji podczas uczenia.

Oznaczaj � c przez ε warto� � dopuszczalnego bł � du wykazano [139], � e Prob { |P(W) - vL (W)| > ε} → 0, je

�li

liczba próbek ucz� cych p→ ∝, przy czym Prob{ } oznacza prawdopodobie stwo zdarzenia okre�lonego

wewn� trz nawiasów. Niech α oznacza prawdopodobie stwo zdarzenia, � e

( ) ( )W

WvWP L ε>−sup (1. 30)

Prawdopodobie stwo to zostało oszacowane w pracy [139] w postaci

( )ph

peh

2exp2 εα −�

�

���

�= (1. 31)

przy czym e oznacza liczb� naturaln� , p - liczb� próbek ucz� cych, a h aktualn� warto� � VCdim. Oznaczaj � c

przez ε0 warto� � ε spełniaj � c� relacj � (1.31) przy zadanej warto

�ci α otrzymuje si �

( )αε ln1

12

ln0 ph

p

p

h −��

��

���

���

� += (1. 32)

Warto� � ε reprezentuje przedział ufno

�ci. Przedział ten jest funkcji aktualnej miary VCdim, liczby

próbek ucz� cych p oraz warto�ci α i nie zale� y od bł � du uczenia sieci vL(W). Miara ta obowi � zuje tylko

w przypadku dopuszczenia du� ych warto�ci P(W).

Przy wymaganiu małych warto�ci P(W) zmodyfikowana definicja przedziału ufno

�ci (oznaczona tym

razem przez ε1) zale� y równie� od bł � du uczenia vL (W) i przybiera posta� [139]

( )���

����

�++= 2

0

201 11

εεε WvL (1. 33)

Na podstawie zdefiniowanych przedziałów ufno�ci mo� na stwierdzi � , � e w ogólno

�ci, przy małym

poziomie bł � du ucz� cego vL(W), �rednie prawdopodobie stwo wyst� pienia bł � du klasyfikacji spełnia

nierówno� �

( ) ( ) 1ε+< WvWP L (1. 34) Przy bardzo du� ych bł � dach uczenia vL (W ) dokładniejsz� estymat� � redniego prawdopodobie stwa wyst� pienia bł � du klasyfikacji okre

�la relacja

( ) ( ) 0ε+< WvWP L (1. 35)

Podobnie jak bł � d uczenia, definiuje si � bł � d uogólniania vg(W) jako cz� stotliwo� � wyst� pienia bł � du

podczas testowania zbioru na danych testuj � cych. Vapnik [139] wykazał, � e przy liczbie próbek ucz� cych p > h (h - aktualna warto

� � VCdim sieci poddanej uczeniu) z prawdopodobie stwa (1 - α) bł � d uogólnienia jest mniejszy ni � vgm(W), vg(W) ≤, vgm(W) przy czym

( ) ( ) 1ε+= WvWv Lgm (1. 36)

a ε1 okre�la zale� no

� � (1.33). Przy stałej liczbie próbek p i wzrastaj � cej warto�ci miary VCdim bł � d uczenia vL

(W ) maleje monotonicznie, a przedział ufno�ci ε1 ro

�nie.

Rysunek 1.12 Wykres bł � du uczenia i uogólniania sieci w funkcj i miary VCdim

W efekcie maksymalny bł � d uogólniania vgm(W), jako superpozycja obu tych wielko�ci (wzór (1.36)), osi � ga

swoje minimum, jak to przedstawiono na rys. 1.12. Zakres VCdim < hopt odpowiada nadmiarowo�ci danych

bie��� cych wzgl � dem aktualnej warto�ci VCdim. Z kolei zakres VCdim > hopt odpowiada zbyt małej liczbie

danych ucz� cych przy aktualnej warto�ci VCdim. Warto

� � VCdim = hopt odpowiada punktowi optymalnemu, w którym liczba danych ucz� cych jest optymalnie dobrana pod wzgl � dem zdolno

�ci uogólniania sieci.

W przypadku ustalonej warto�ci VCdim bł � d uogólniania zale� y w istotnym stopniu od liczby próbek

ucz� cych. Dla zapewnienia odpowiednio małej warto�ci tego bł � du liczba próbek musi spełnia� odpowiednie

proporcje wzgl � dem VCdim. Dla ka� dego rodzaju sieci jest to oddzielny problem. Szczególnie jaskrawo wyst� puje on w przypadku sieci wielowarstwowej, gdzie liczba wag jest zwykle bardzo du� a w stosunku do liczby neuronów.

Główna trudno� � okre

�lenia optymalnego wymiaru zbioru ucz� cego dla danej sieci wynika

z niemo� liwo�ci okre

�lenia dokładnej warto

�ci miary VCdim. Tylko w nielicznych przypadkach najprostszych

rodzajów sieci miara ta jest b� d� okre�lona w sposób jawny, b� d� podlega oszacowaniu. W ogólnym przypadku

jej warto� � wzrasta przy wzrastaj � cej liczbie wag. St� d w praktyce dla uzyskania dobrych zdolno

�ci uogólniania

sieci nale� y ogranicza� liczb� neuronów ukrytych oraz liczb� powi � za mi � dzyneuronowych, jak równie� stosowa� takie metody wst� pnego przetworzenia danych, które umo� liwiaj zmniejszenie wymiarowo

�ci wektora

wej�ciowego sieci. Ka� dy z tych czynników, po

�rednio lub bezpo

�rednio, wpływa na zmniejszenie efektywnej

liczby wag sieci neuronowej. Inny problem to wpływ sposobu i czasu uczenia na zdolno

�ci uogólniania sieci. W ogólnym przypadku

wraz z upływem czasu uczenia bł � d uczenia vL (W ) maleje i bł � d testowania równie� (przy ustalonej warto�ci

liczby próbek ucz� cych p oraz miary VCdim.

Rysunek 1.13 Wykres bł � du uczenia i testowania na danych sprawdzaj � cych w funkcj i cykli ucz� cych

Taka sytuacja trwa zwykle do pewnego momentu uczenia, poczynaj � c od którego bł � d testowania b� d� pozostaje stały, b� d� zaczyna nieznacznie rosn� � , chocia� bł � d uczenia nadal maleje. Sytuacj � tak� przedstawia rys. 1.13. Wynika to zwykle z ograniczonej liczby próbek ucz� cych, która powoduje, � e w

�ród próbek znajduj �

si � w znacz� cej proporcji takie, które zawieraj � dane zaszumione b� d� wykazuj � ce inne nieregularno�ci

odbiegaj � ce od cech charakterystycznych danego procesu. W pewnym momencie uczenia, zwykle w jego ostatnich fazach, te wła

�nie nieregularno

�ci zaczynaj � odgrywa� rol � i wpływaj � na dobór warto

�ci wag sieci,

wprowadzaj � c dysproporcje, zakłócaj � ce wła�ciwy proces uczenia i powoduj � ce wzrost bł � du testowania.

Tendencje te s� tym silniejsze, im wi � ksza nadmiarowo� � wag wyst� puje w sieci. Wagi „niepotrzebne" dla

odzwierciedlenia cech danego procesu dopasowuje si � do wszelkich nieregularno�ci danych ucz� cych traktuj � c

je jako cech� główn� . W procesie testowania sieci na danych testuj � cych powstaj � w efekcie dodatkowe bł � dy. Bior� c pod uwag� , � e zwykle trudno jest okre

�li � wła

�ciwy wymiar sieci ze wzgl � du na brak

wskazówek co do liczby neuronów ukrytych, proces uczenia jest przeplatany z procesem sprawdzania, jak dalece jest zaawansowany proces uczenia. Z tego wzgl � du dane ucz� ce dzielone s� na dwie cz� � ci: podstawow� L oraz sprawdzaj � c� V, jak to przedstawiono na rys. 1.10. Zbiór V pełni funkcj � testera wskazuj � cego, w którym miejscu nale� y zako czy� proces uczenia.

2. Sieci neuronowe jednokierunkowe wielowarstwowe Spo

�ród wielu istniej � cych rodzajów sieci neuronowych najwi � kszym zainteresowaniem ciesz� si �

sieci jednokierunkowe wielowarstwowe o neuronach typu sigmoidalnego, zwane równie� perceptronem wielowarstwowym. Przepływ sygnałów w tych sieciach odbywa si � tylko w jednym kierunku -od wej

�cia do

wyj�cia, a zjawiska tam powstaj � ce mo� na do

� � łatwo opisa� . Równie� metody uczenia tych sieci s� proste i łatwe do zrealizowania w praktyce. W rozdziale tym przedstawiono podstawowe zale� no

�ci odnosz� ce si � do sieci wielowarstwowych. Poczynaj � c

od opisu neuronu sigmoidalnego poprzez zale� no�ci energetyczne, wprowadzono podstawowe metody uczenia

tych sieci, w tym algorytm propagacji wstecznej, metody minimalizacyjne funkcji celu, a tak� e ró� ne metody doboru warto

�ci startowych wag sieci, przyspieszaj � ce proces uczenia i umo� liwiaj � ce unikni � cie zatrzymania

procesu w minimum lokalnym.

2.1. Podstawowe zale no ci odnosz ce si do neuronu W dalszej cz� � ci rozwa� a przyj � to model neuronu wraz z oznaczeniami w postaci przedstawionej na

rys. 2.1. Składa si � on z elementu sumacyjnego, do którego dochodz� sygnały wej�ciowe xl, x2,..., xN tworz� ce

wektor wej�ciowy x = [xl, x2,..., xN] T pomno� one przez przyporz� dkowane im wagi Wi1, Wi2, ..., WiN tworz� ce

wektor wag i-tego neuronu Wi = = [Wi1, Wi2, ..., WiN] T oraz warto� � Wi0 zwan� progiem. Sygnał wyj

�ciowy

sumatora oznaczono ui, przy czym

�=

+=N

jijiji WxWu

10 (2.1)

Sygnał ten jest podawany na blok realizuj � cy nieliniow� funkcj � aktywacji f(ui). Funkcja ta, w zale� no�ci od

konkretnego celu, jakiemu słu� y neuron, mo� e przyjmowa� ró� ne postacie. W dalszej cz� � ci rozwa� a ograniczono si � do postaci sigmoidalnej, b� d� w szczególno

�ci skokowej. Posta� skokowa funkcji mo� e by�

typu unipolarnego, przyjmuj � c warto� � 0 lub 1 (przykładem mo� e by� perceptron), b� d� bipolarnego, dla której

warto� � sygnału wyj

�ciowego mo� e by� ±l (przykładem jest neuron typu adaline Widrowa [150]).

Rysunek 2.1 Model neuronu sigmoidalnego z przyj � tymi oznaczeniami wag

Obie stosuje si � głównie w tego typu systemach, gdzie sygnał wyj�ciowy powinien przyjmowa� jedn� z dwóch

warto�ci dyskretnych, np. klasyfikatorach wektorowych.

Sieci neuronowe wykorzystuj � ce skokowe funkcje aktywacji maj � charakterystyki nieci � głe, co utrudnia proces uczenia tych sieci. Przykładem algorytmu ucz� cego dostosowanego do skokowej funkcji aktywacji jest przedstawiony w rozdz. 1 algorytm Widrowa-Hoffa, który wykorzystywał jedynie informacj � o aktualnej warto

�ci funkcji celu. Algorytmy gradientowe, uznawane za najskuteczniejsze w uczeniu, nie mog�

mie� bezpo�redniego zastosowania, gdy� podstawowe wymaganie dotycz� ce ci � gło

�ci funkcji celu nie jest

wówczas spełnione. Wada ta została wyeliminowana przez przyj � cie sigmoidalnej funkcji aktywacji, stanowi � cej ci � głe przybli � enie funkcji skokowej, przy której sygnał wyj

�ciowy neuronu yi przyjmuje dowolne

warto�ci z przedziału [0,1] dla funkcji unipolarnej lub [-1,1] dla funkcji bipolarnej. funkcja sigmoidalna

unipolarna jest najcz� � ciej definiowana w postaci

( ) ( )iiu u

ufβ−+

=exp1

1 (2.2)

natomiast bipolarna

( ) ( )iib utghuf β= (2.3)

lub

( ) ( ) 12 −= iuib ufuf (2.4)

Posta� bipolarna okre�lona wzorem (2.4) wi ��� e oba rodzaje funkcji sigmoidalnych.

Im wi � ksza jest warto� � współczynnika β, tym bardziej stroma jest posta� funkcji. Przykładowo przy

warto�ci β = 10 przebieg funkcji sigmoidalnej przy odpowiedniej skali wymuszenia x upodabnia si � do funkcji

skokowej. Mała warto� � współczynnika β zwi � ksza zakres liniowo

�ci funkcji, przybli � aj � c j � do funkcji

liniowej. W praktyce przyjmuje si � zwykle warto� � współczynnika β = 1.

Wa� n� cech� funkcji sigmoidalnej jest jej ró� niczkowalno� � . W przypadku funkcji unipolarnej

otrzymuje si �

( ) ( ) ( )( )xfxfdx

xdfuu

u −= 1β (2.5)

W przypadku funkcji bipolarnej o postaci (2.3)

( ) ( )( )xfdx

xdfb

b 21−= β (2.6)

a w przypadku funkcji o postaci (2.4)

( ) ( ) ( )( )xfxfdx

xdfuu

b −= 12β (2.7)

Obie postacie funkcji s� ci � głe z maksimum odpowiadaj � cym warto�ci x = O, a do ich okre

�lenia wystarczy

znajomo� � warto

�ci samej funkcji f (x).

2.2. Podstawowe definicje funkcji celu Najskuteczniejsz� metod� uczenia sieci jednokierunkowych sigmoidalnych pozostaje optymalizacja

funkcji celu zdefiniowanej dla sieci, minimalizuj � ca bł � d mi � dzy warto�ciami � � danymi i aktualnie

otrzymanymi na wyj�ciu sieci dla wszystkich danych ucz� cych. Jest to uczenie pod nadzorem ( z nauczycielem).

W uczeniu tego typu zakłada si � , � e s� znane � � dane warto�ci sygnałów neuronów wyj

�ciowych di (i = 1,2, ...,

M), przy czym M oznacza liczb� neuronów wyj�ciowych, a dobór wag sieci musi zapewni � dopasowanie sygna-

łów wyj�ciowych Y i do warto

�ci � � danych di. Uczenie odbywa si � przez minimalizacj � odpowiednio

zdefiniowanej funkcji celu E(W), przy czym wektor W reprezentuje wagi sieci poddawane optymalizacji. Oznaczaj � c przez d wektor warto

�ci � � danych sieci, d = [d1, d2, ..., dM] T, w przypadku jednej pary ucz� cej (x, d)

najprostsza definicja funkcji celu ma posta� bł � du �redniokwadratowego

( )�=

−=M

iii dyE

1

2

21

(2.8)

przy czym yi =f(ui), a f( ) reprezentuje funkcj � sigmoidaln� . W przypadku wielu par ucz� cych (x(j), d(j)) dla j = 1,2, ...,p definicja funkcji celu uwzgl � dnia sumowanie bł � dów po wszystkich p parach ucz� cych

( ) ( )( )��= =

−=p

j

M

iii jdjyE

1

2

121

(2.9)

Zało� enie ci � głej funkcji aktywacji umo� liwia minimalizacj � funkcji celu metodami gradientowymi. W metodach tych do aktualizowania wektora wag wykorzystuje si � informacj � o gradiencie funkcji celu

T

nW

E

W

E

W

EE �

�

��

�

∂∂

∂∂

∂∂=∇ ,,,

21

� , przy czym w ka� dym kroku uczenia wyznacza si � tzw. kierunek

minimalizacji. Istnieje wiele sposobów obliczania tego kierunku, które szczegółowo zostan� omówione w nast� pnych punktach tego rozdziału. Ograniczaj � c si � tutaj do ogólnego zapisu kierunku minimalizacji w postaci p(W(k)), w której k odpowiada okre

�lonemu cyklowi ucz� cemu, równanie adaptacji wag mo� na

zapisa� w postaci dyskretnej

( ) ( ) ( )( )kWpkWkW η+=+1 (2.10) przy czym 17 jest współczynnikiem uczenia, przyjmowanym z przedziału [0,1], b� d� w postaci ci � głej przez rozwi � zanie układu równa ró� niczkowych [13]

( )Wpdt

dW µ= (2.11)

w którym µ jest odpowiednikiem η z równania (2.10). Najprostsz� metod� wyboru kierunku minimalizacji p(W), stosowan� dotychczas najcz� � ciej, jest wybór zgodny z kierunkiem ujemnego gradientu, tzw. algorytm najwi � kszego spadku, w którym

( ) ( )WEWp −∇= (2.12)

Równania (2.10) i (2.11) okre�laj � gradientowy algorytm uczenia neuronu. Algorytm ten umo� liwia

wyznaczenie minimum funkcji celu. Bior� c pod uwag� , � e jest to algorytm lokalny, nie ma gwarancji � e znalezione minimum jest globalne. W trakcie uczenia sieci bardzo cz� sto "utykaj � " w minimach lokalnych, dla których warto

�ci sygnałów wyj

�ciowych sieci Y i ró� ni � si � znacznie od warto

�ci � � danych d i tych sygnałów.

Mówi si � wówczas, � e sie� nie została prawidłowo nauczona. Utykanie to jest spowodowane wielomodalno�ci �

funkcji celu, która, wobec zło� onych nieliniowych zale� no�ci obowi � zuj � cych wewn� trz sieci, mo� e

charakteryzowa� si � ogromn� liczb� minimów lokalnych. Na rysunku 2.2a przedstawiono trójwymiarowy wykres funkcji celu, zdefiniowanej według zale� no

�ci (2.9) dla jednego neuronu o 2 wagach Wo i Wl

realizuj � cych separacj � dwu klas danych, a na rys. 2.2b odpowiadaj � cy mu wykres linii ekwipotencjalnych. W zale� no

�ci od punktu startu (znak + na wykresie linii ekwipotencjalnych) trajektoria rozwi � zania zd��� a albo do

minimum globalnego na �rodku wykresu (punkt x) , albo trafia na w� sk� dolin� wyprowadzaj � c� rozwi � zanie

poza zakres obj � ty rysunkiem.

Rysunek 2.2 Przykładowy wykres funkcj i celu sieci neuronowej : a) wykres trójwymiarowy funkcj i; b) przebieg linii ekwipotencjalnych i procesu uczenia ( + -punkt star towy, x -stan ko� cowy)

Z wykresu zmian funkcji wida� , � e nie z ka� dego punktu wykresu i nie ka� d� drog� jest mo� liwe zej

�cie do minimum globalnego. Wybranie niewła

�ciwego punktu startowego (niewła

�ciwie przyporz� dkowanie

warto�ci pocz� tkowych wag) oraz niewła

�ciwej drogi mo� e spowodowa� wej

�cie w minimum lokalne, którego

algorytm optymalizacyjny nie b� dzie w stanie samoczynnie opu�ci � .

Jakkolwiek definicja funkcji celu sieci neuronowej w postaci sumy kwadratów ró� nic mi � dzy warto

�ciami ��� danymi i aktualnymi (zale� no

� � (2.9)) jest najcz� � ciej wykorzystywana w praktyce, stosuje si � równie� w szczególnych przypadkach inne definicje. Do bardziej znanych mo� na zaliczy� funkcj � wykorzystuj � c� norm� L1, umo� liwiaj � c� bardziej równomierny udział poszczególnych składników bł � du w ogólnej definicji funkcji celu. Ograniczaj � c si � do jednej próbki ucz� cej definicj � funkcji celu w tym przypadku przyjmuje si � w postaci [16]

�=

−=M

iii dyE

1

(2.13)

Definicj � tego typu stosuje si � niekiedy w cyfrowym przetwarzaniu sygnałów przy u� yciu sieci neuronowej. W przeciwnym przypadku, gdy zadaniem układu jest minimalizacja najwi � kszego odchylenia odpowiedzi od wielko

�ci � � danej, stosuje si � wy� sze pot� gi bł � du w definicji funkcji celu [16]

( )�=

−=M

i

Kii dyE

1

2 (2.14)

przy czym K ≥ 2. Wprowadzenie wi � kszych warto�ci K powoduje jednak znaczne trudno

�ci natury

obliczeniowej algorytmu optymalizacyjnego, wynikaj � ce z pogarszaj � cego si � uwarunkowania problemu. Interesuj � c� posta� funkcji celu zaproponował Karayiannis w pracy [60]. Przy ograniczeniu si � , podobnie jak wy� ej, do jednej próbki ucz� cej, jego definicj � mo� na przedstawi � w postaci

( ) ( ) ( ) ( )� �= =

−++−=M

i

M

iiii dydyWE

1 111

2 121 φλλ (2.15)

przy czym λ jest współczynnikiem zmieniaj � cym si � w przedziale [0,1], a φ1 ( ) jest funkcj � ci � gł � , wypukł � , dodatnio okre

�lon� i ró� niczkowaln� w całym zakresie zmienno

�ci argumentu. Dla warto

�ci λ = 1 definicja